فهرست مطالب

گزارشی جدید نشان میدهد که ChatGPT برخلاف تصور اولیه، از آن چیزی که قبلاً تصور میشد، انرژی کمتری مصرف میکند.

به گزارش تکناک، تحقیقی جدید نشان میدهد که مصرف انرژی چتبات ChatGPT ممکن است کمتر از آن چیزی باشد که پیشتر تصور میشد. این مطالعه را مؤسسه پژوهشی Epoch AI انجام داده است.

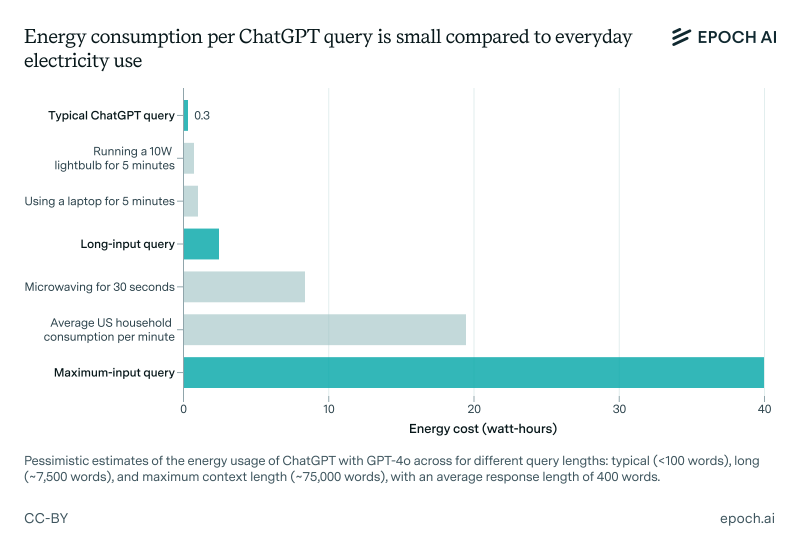

براساس آمار رایج، پاسخ به هر پرسش در ChatGPT حدود ۳ واتساعت انرژی مصرف میکند که این مقدار ۱۰ برابر مصرف انرژی جستوجویی معمولی در گوگل است. بااینحال، بررسی Epoch AI نشان داده است که این رقم احتمالاً بیشازحد برآورد شده است. این مطالعه با استفاده از مدل GPT-4o انجام شده است که جدیدترین مدل پیشفرض OpenAI برای ChatGPT محسوب میشود. مطالعه یادشده نشان داده است که میزان مصرف انرژی آن کمتر از بسیاری از لوازم خانگی است.

جاشوا یو، تحلیلگر داده در Epoch AI و مسئول این پژوهش، در گفتوگو با تککرانچ اظهار کرد:

مصرف انرژی ChatGPT در مقایسه با استفاده از وسایل خانگی معمولی و سیستم گرمایش و سرمایش یا حتی رانندگی با خودرو چندان چشمگیر نیست.

01

از 02نگرانیها درباره تأثیرات زیستمحیطی هوش مصنوعی

به نقل از تککرانچ، درحالیکه نگرانیها درباره افزایش مصرف انرژی هوش مصنوعی در حال گسترش است، این فناوری بهسرعت در حال رشد است و شرکتها زیرساختهای خود را توسعه میدهند. تنها در هفته گذشته، بیش از ۱۰۰ سازمان با امضای نامهای سرگشاده از صنعت هوش مصنوعی و مقامات نظارتی خواستند که از تأثیرات زیستمحیطی این فناوری، بهویژه تخلیه منابع طبیعی و اتکا به انرژیهای تجدیدناپذیر، جلوگیری کنند.

یو در پاسخ به این نگرانیها اشاره کرد که بسیاری از تخمینهای پیشین درباره مصرف انرژی ChatGPT مبتنیبر دادههای قدیمی و تراشههای کمبازدهتر بوده است. با وجود این یافتهها، Epoch AI پیشبینی میکند که مصرف انرژی ChatGPT در آینده افزایش یابد. یو افزود:

هوش مصنوعی بهمرور پیشرفتهتر خواهد شد و آموزش مدلهای جدید به انرژی بیشتری نیاز خواهد داشت. همچنین، با گسترش دامنه استفاده از این فناوری، نیاز به منابع محاسباتی بیشتر، به افزایش مصرف انرژی منجر خواهد شد.

گزارشهای اخیر حاکی از آن است که مراکز داده OpenAI و سایر شرکتهای هوش مصنوعی در سالهای آینده میلیاردها دلار برای توسعه زیرساختهای پردازشی سرمایهگذاری خواهند کرد. طبق پژوهشی که Rand انجام داده، پیشبینی میشود که تا سال ۲۰۲۷ مراکز داده هوش مصنوعی نیازمند مصرفی معادل کل ظرفیت برق ایالت کالیفرنیا در سال ۲۰۲۲ (حدود ۶۸ گیگاوات) باشند. همچنین، تا سال ۲۰۳۰، آموزش مدلهای پیشرفته میتواند معادل توان تولیدی ۸ راکتور هستهای (حدود ۸ گیگاوات) برق مصرف کند.

02

از 02گسترش مدلهای استدلالی و افزایش مصرف انرژی

یکی از عواملی که میتواند به افزایش مصرف انرژی منجر شود، گسترش استفاده از مدلهای استدلالی است. برخلاف مدلهای معمولی مانند GPT-4o که تقریباً بلافاصله به پرسشها پاسخ میدهند، مدلهای استدلالی برای تولید پاسخهای پیچیدهتر، به چندین ثانیه یا حتی دقیقهها پردازش نیاز دارند. این فرایند مستلزم استفاده از محاسبات بیشتر است که بهطور طبیعی مصرف انرژی را افزایش میدهد. یو در اینباره توضیح داد:

مدلهای استدلالی وظایفی را برعهده خواهند گرفت که مدلهای قدیمیتر ازپس انجام آنها برنمیآیند. این مدلها برای پردازش دادههای بیشتر، به تعداد بیشتری از مراکز داده نیاز دارند.

در همین راستا، OpenAI در حال توسعه مدلهای استدلالی کممصرفتر مانند o3-mini است. بااینحال، کارشناسان معتقدند که این پیشرفتها ممکن است نتواند رشد شدید مصرف انرژی ناشی از گسترش استفاده از هوش مصنوعی را بهطور کامل جبران کند. یو در نهایت پیشنهاد کرد که کاربران برای کاهش تأثیرات زیستمحیطی استفاده از هوش مصنوعی، تاحدامکان از مدلهای کممصرفتر استفاده کنند.