فهرست مطالب

محققان شرکت انویدیا با معرفی فناوری تازهای به نام NVFP4 موفق شدهاند انقلابی در آموزش مدلهای زبانی بزرگ (LLM) ایجاد کنند.

به گزارش تکناک، این فناوری امکان آموزش مدلها را با دقت ۴ بیتی فراهم میکند، در حالی که سطح پایداری و دقت آن با مدلهای ۸ بیتی برابری میکند. نتیجه این پیشرفت، کاهش چشمگیر هزینهها و مصرف منابع در آموزش و اجرای مدلهای هوش مصنوعی است؛ موضوعی که میتواند مسیر توسعه نسل آینده LLMها را برای شرکتهای کوچک و متوسط نیز هموار کند.

در حال حاضر، یکی از چالشهای اصلی صنعت هوش مصنوعی، مدیریت هزینه و توان محاسباتی بالای مورد نیاز برای آموزش مدلهای زبانی است. هرچه مدل بزرگتر و پارامترهای بیشتری داشته باشد به حافظه و انرژی بیشتری نیاز دارد. راهکار سنتی برای کاهش این نیاز، استفاده از تکنیک کوانتیزهسازی (Quantization) است؛ روشی که طی آن وزنها و مقادیر عددی مدل از حالتهای دقیق ۱۶ یا ۳۲ بیتی به فرمتهای سادهتر مانند ۸ یا ۴ بیتی تبدیل میشوند تا حجم محاسبات و مصرف انرژی کاهش یابد.

اما کاهش دقت همیشه با یک هزینه همراه بوده است. تبدیل به فرمتهای پایینتر مانند ۴ بیتی معمولاً باعث از دست رفتن بخشی از دقت مدل میشود و عملکرد آن را در درک، استدلال یا تولید زبان طبیعی تضعیف میکند. شرکت انویدیا با فناوری NVFP4 ادعا میکند که این مانع را پشت سر گذاشته و موفق شده است تعادلی بیسابقه بین سرعت، حافظه و دقت برقرار کند.

01

از 05چگونگی غلبه فناوری NVFP4 انویدیا بر محدودیتهای ۴ بیتی

در فناوریهای مرسوم، مانند فرمت MXFP4، مدلها تنها قادر به نمایش ۱۶ سطح عددی متمایز هستند. این محدودیت باعث میشود که دادههای پرت (outliers) در هنگام آموزش، کل مجموعه داده را منحرف و خطاهای تجمعی در محاسبات ایجاد کنند. اما NVFP4 با بهکارگیری روشی موسوم به «مقیاسگذاری چندسطحی» توانسته است این ضعف را برطرف کند.

این رویکرد امکان میدهد مدل به شکل دقیقتری مقادیر تنسور (Tensor) را در زمان آموزش نمایش دهد و از نوسانات عددی جلوگیری کند. علاوه بر این، محققان انویدیا از استراتژی دقت ترکیبی (Mixed-Precision Strategy) بهره گرفتهاند. در این روش، بیشتر لایههای مدل با دقت ۴ بیتی آموزش داده میشوند، اما بخشهای حساستر مدل – مانند لایههای نرمالسازی یا توجه (Attention Layers) – در فرمتهای دقیقتر مانند BF16 باقی میمانند. این ترفند به پایداری مدل در نقاط بحرانی کمک میکند، بدون اینکه مزیت صرفهجویی در حافظه را از بین ببرد.

به گفته تیم تحقیقاتی، NVFP4 نحوه محاسبه گرادیانها در مرحله Backpropagation را بازطراحی کرده است تا از انباشته شدن خطاهای عددی جلوگیری شود. نتیجه این نوآوری، آموزش مدلهایی است که با وجود استفاده از تنها نیمی از حافظه نسخه FP8، همان سطح عملکرد و دقت را ارائه میدهند.

02

از 05آزمایشهای عملی و نتایج بهدستآمده

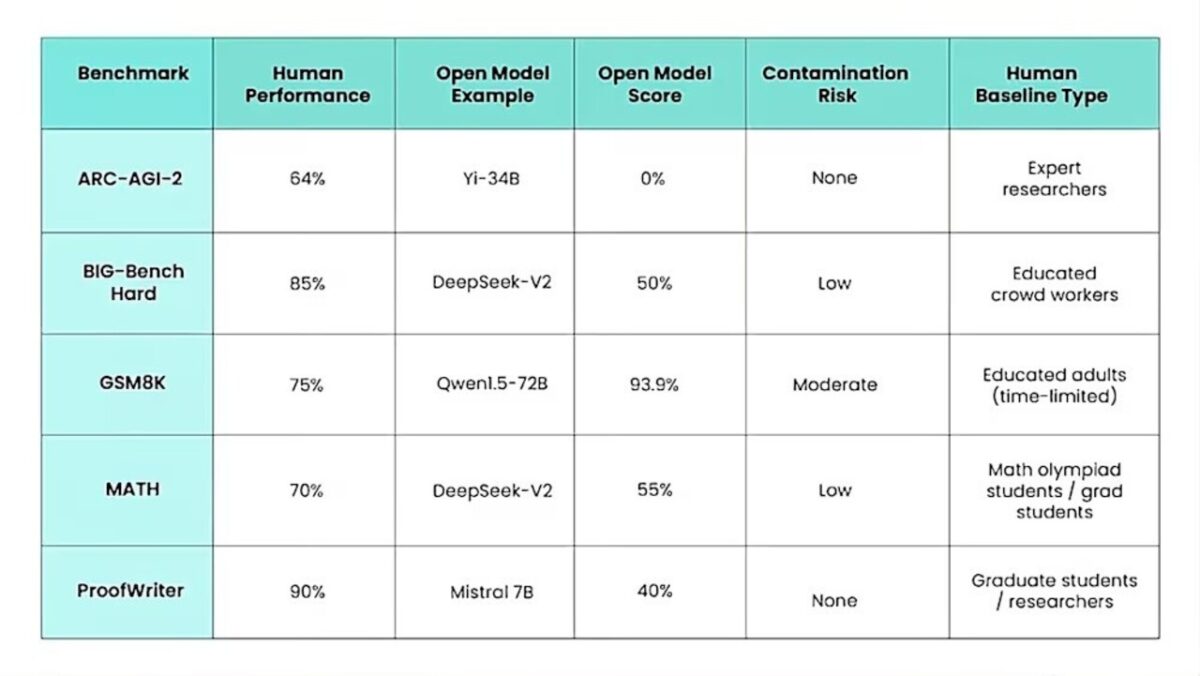

تیم انویدیا برای ارزیابی فناوری NVFP4، یک مدل ترکیبی Mamba–Transformer با ۱۲ میلیارد پارامتر را روی ۱۰ تریلیون توکن آموزش داد و نتایج آن را با مدل مشابهی در قالب FP8 مقایسه کرد. طبق گزارش منتشرشده، منحنی خطای آموزش (Training Loss) و دقت وظایف پاییندستی (Downstream Accuracy) در مدل NVFP4 تقریباً بهطور کامل با نسخه FP8 همپوشانی داشت.

این مدل در حوزههایی مانند استدلال منطقی، ریاضیات، پرسشهای دانشی و وظایف مربوط به درک عمومی، عملکرد مشابهی با مدل ۸ بیتی داشت. تنها تفاوت قابل توجه، کاهش جزئی در تستهای مربوط به کدنویسی در مراحل پایانی آموزش بود؛ مسئلهای که محققان آن را با بهینهسازیهای آینده قابل رفع میدانند.

شرکت انویدیا در آزمایشی دیگر، مدل ۸ میلیارد پارامتری مشابهی را با دو فرمت MXFP4 و NVFP4 آموزش داد. نتایج نشان داد مدل NVFP4 توانست با ۳۶ درصد داده کمتر به همان سطح دقت MXFP4 برسد، که این به معنی کاهش محسوس هزینه و زمان آموزش است.

03

از 05اظهارات مدیران انویدیا درباره فناوری NVFP4

شار ناراسیمن، مدیر محصول بخش GPU و مرکز داده انویدیا در گفتوگویی با VentureBeat اعلام کرد: «NVFP4 به توسعهدهندگان اجازه میدهد مدلهایی با دقت نزدیک به مدلهای بزرگتر با مصرف بسیار کمتر حافظه و توان محاسباتی بسازند.» وی تصریح کرد: «این فناوری سقف محدودیتهای FP8 را میشکند و به ما فضای بیشتری برای رشد و نوآوری میدهد.»

به گفته ناراسیمن، در حالی که FP8 در مقایسه با FP16 پیشرفت بزرگی بود، هنوز محدودیتهایی از نظر اندازه مدل و کارایی در استنتاج (Inference) داشت. اما NVFP4 با نصف حافظه همان عملکرد را ارائه میدهد و مسیر تازهای برای آموزش مدلهای سفارشی باز میکند.

04

از 05تأثیر اقتصادی و صنعتی

از دیدگاه صنعتی، فناوری NVFP4 انویدیا فراتر از یک دستاورد فنی است. این فناوری نشان میدهد که مدلهای زبانی با میلیاردها پارامتر را میتوان با هزینهای بسیار کمتر آموزش داد، بدون آنکه از دقت کاسته شود. چنین رویکردی میتواند اقتصاد آموزش مدلهای هوش مصنوعی را متحول کند.

در حال حاضر، تنها شرکتهای غولپیکری مانند OepnAI، Google یا Anthropic قادر به آموزش مدلهای در مقیاس GPT یا Claude هستند. اما با NVFP4، امکان دارد شرکتهای متوسط یا حتی استارتآپها بتوانند مدلهای زبانی تخصصی خود را از صفر توسعه دهند.

ناراسیمن تأکید کرد: «نمایش موفقیتآمیز آموزش مدلهای چندمیلیاردپارامتری با دقت ۴ بیتی، دروازهای به سوی آیندهای باز میکند که در آن هر سازمان میتواند مدل اختصاصی خود را آموزش دهد و فقط به نسخههای بهینهشده از مدلهای موجود محدود نباشد.»

05

از 05افق آینده و نتیجهگیری

هرچند مقاله انویدیا بر مزایای فناوری NVFP4 در مرحله پیشآموزش تمرکز دارد، اما تأثیر آن در استنتاج نیز چشمگیر است. مدلهایی که با این فرمت آموزش میبینند، میتوانند پاسخهای پیچیدهتر را با سرعت بالاتر و هزینه کمتر تولید کنند و در عین حال مصرف انرژی را کاهش دهند.

در نهایت، NVFP4 نشان میدهد که آینده بهینهسازی مدلهای هوش مصنوعی تنها در کاهش دقت خلاصه نمیشود، بلکه در ساخت معماریهای هوشمندتر نهفته است. ناراسیمن بیان کرد: «ما بهسوی سیستمی میرویم که نهتنها سریعتر و سبکتر است، بلکه با درک عمیقتر از توازن میان دقت، انرژی و کارایی طراحی شده است.»

با چنین رویکردی، انویدیا یک گام بزرگ در مسیر طراحی مدلهای کارآمدتر، کمهزینهتر و در دسترستر برای نسل بعدی هوش مصنوعی برداشته است؛ گامی که میتواند چشمانداز صنعت AI را برای همیشه دگرگون کند.