فهرست مطالب

دانشمندان با استفاده از هوش مصنوعی (AI)، فعالیت پیچیده مغز را که در طول مکالمات روزمره رخ میدهد، رمزگشایی کردهاند.

به گزارش تکناک، این دستاورد میتواند بینشهای جدیدی در مورد عصبشناسی زبان ارائه دهد و در آینده به بهبود فناوریهای تشخیص گفتار یا کمک به افراد برای برقراری ارتباط بهتر کمک کند.

01

از 06چگونگی عملکرد هوش مصنوعی در تحلیل مکالمات

در این مطالعه، محققان از یک مدل هوش مصنوعی به نام Whisper استفاده کردند. این مدل، فایلهای صوتی و متنهای مربوط به آنها را بررسی میکند و از آنها برای آموزش تبدیل صوت به متن بهره میگیرد. سپس، براساس این اطلاعات، یاد میگیرد که چگونه از فایلهای صوتی جدید متن درست کند، حتی اگر قبلاً آنها را نشنیده باشد.

برخلاف مدلهای سنتی که ویژگیهای خاص ساختار زبان مانند واجها (Phonemes) و اجزای کلام (Parts of Speech) را کدگذاری میکنند، Whisper تنها از طریق آمار و بدون نیاز به کدگذاری اولیه ساختارهای زبانی عمل میکند. البته محققان نشان دادند که این ساختارها پس از آموزش مدل به طور طبیعی در آن ظاهر میشوند.

02

از 06بینشهای جدید در مورد زبان و مغز انسان

این مطالعه نه تنها به درک بهتر از نحوه عملکرد مدلهای زبانی بزرگ (LLMs) کمک میکند، بلکه بینشهای ارزشمندی در مورد زبان و مغز انسان نیز ارائه میدهد. شناسایی شباهتهای بین نحوه توسعه تواناییهای پردازش زبان در این مدلها و نحوه یادگیری این مهارتها توسط انسانها میتواند برای طراحی دستگاههایی که به افراد در برقراری ارتباط کمک میکنند، مفید باشد.

03

از 06جزئیات مطالعه و یافتههای کلیدی

این مطالعه که در ۷ مارس در مجله Nature Human Behaviour منتشر شد، روی چهار بیمار مبتلا به صرع انجام شد که برای درمان بالینی، الکترودهای نظارت بر فعالیت مغز در مغز آنها کار گذاشته شده بود. با رضایت این بیماران، محققان تمام مکالمات آنها را در طول اقامت در بیمارستان (از چند روز تا یک هفته) ضبط کردند و بیش از ۱۰۰ ساعت صوت جمعآوری شد.

هر یک از شرکتکنندگان بین ۱۰۴ تا ۲۵۵ الکترود در مغز خود داشتند که فعالیت مغز آنها را ثبت میکرد.

04

از 06نحوه مشارکت مناطق مختلف مغز در گفتار

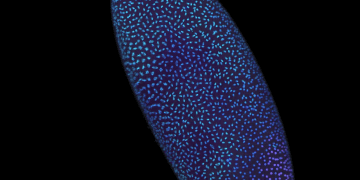

این مطالعه نشان داد که چگونه بخشهای مختلف مغز در طول وظایف مرتبط با تولید و درک گفتار فعال میشوند. گلدشتاین که محقق اصلی این مطالعه بود، توضیح داد که بحثهای زیادی در مورد این موضوع وجود دارد که آیا بخشهای مجزای مغز در این وظایف فعال میشوند یا کل مغز به صورت جمعی پاسخ میدهد.

برخی نظریهها میگویند که یک بخش از مغز، اصوات تشکیلدهنده کلمات را پردازش میکند، بخش دیگر معانی کلمات را تفسیر میکند و بخش سوم حرکات لازم برای صحبت کردن را کنترل میکند. در مقابل، نظریه دیگر بیان میکند که این مناطق مغز به صورت توزیعشده و هماهنگ عمل میکنند.

محققان در این مطالعه جدید کشف کردند که برخی مناطق مغز تمایل به همبستگی با وظایف خاص دارند. به عنوان مثال، مناطق مرتبط با پردازش صدا، مانند شیار گیجگاهی فوقانی (Superior Temporal Gyrus)، در مواجهه با اطلاعات شنیداری فعالتر میشوند، در حالی که مناطق مرتبط با تفکر سطح بالا، مانند شیار پیشانی تحتانی (Inferior Frontal Gyrus)، بیشتر در درک معانی زبان فعال هستند.

05

از 06ارتباط بین مدلهای هوش مصنوعی و مغز

محققان از ۸۰ درصد از صوتهای ضبطشده و متنهای مربوطه برای آموزش Whisper استفاده کردند تا بتواند متنهای مربوط به ۲۰ درصد باقیمانده صوتها را پیشبینی کند. سپس، آنها نحوه نمایش صوت و متن در Whisper را به فعالیت مغز ثبتشده توسط الکترودها مرتبط کردند.

پس از این تحلیل، مدل هوش مصنوعی قادر بود فعالیت مغز مربوط به مکالماتی که در دادههای آموزشی وجود نداشتند را پیشبینی کند. دقت این مدل از مدلهای مبتنی بر ویژگیهای ساختار زبان فراتر رفت.

06

از 06نظرات کارشناسان

لئونارد شیل باخ، رهبر گروه تحقیقاتی در مرکز علوم اعصاب مونیخ آلمان، این مطالعه را پیشگامانه توصیف کرد و گفت: این تحقیق نشاندهنده پیوند بین عملکرد مدلهای محاسباتی تبدیل صوت به گفتار و عملکرد مغز است.

گاسپر بگوژ، استاد زبانشناسی در دانشگاه کالیفرنیا، برکلی، نیز افزود: مقایسه مغز با شبکههای عصبی مصنوعی یک خط تحقیقاتی مهم است. اگر بتوانیم نحوه عملکرد نورونهای مصنوعی و بیولوژیکی و شباهتهای آنها را درک کنیم، میتوانیم آزمایشها و شبیهسازیهایی انجام دهیم که در مغز واقعی امکانپذیر نیستند.

این مطالعه نه تنها به درک بهتر از نحوه عملکرد مدلهای هوش مصنوعی در پردازش زبان کمک میکند، بلکه بینشهای جدیدی در مورد فعالیت مغز انسان در حین مکالمات روزمره ارائه میدهد. این یافتهها میتوانند راه را برای توسعه فناوریهای پیشرفتهتر در حوزه تشخیص گفتار و کمک به افراد دارای اختلالات ارتباطی هموار کنند.