فهرست مطالب

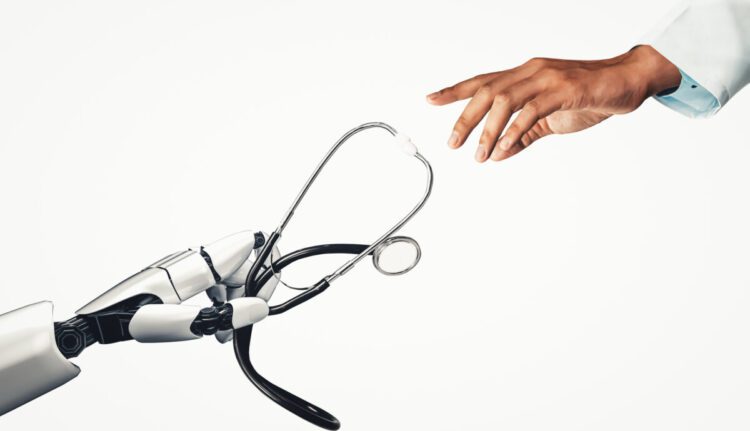

تحقیقات جدید نشان میدهد که استقرار سریع هوش مصنوعی در حوزه سلامت، وضعیت غیرمنصفانهای برای پزشکان ایجاد کرده است.

به گزارش تکناک، بر اساس مطالعهای که در مجله JAMA Health Forum منتشر شده است، اگرچه هوش مصنوعی وعده کاهش خطاهای پزشکی و فرسودگی شغلی را میدهد، اما در عمل با تحمیل فشار غیرواقعبینانه، ممکن است هر دو مشکل را تشدید کند.

محققان دانشگاه تگزاس در جدیدترین تحقیقات خود به این نتیجه رسیدند که سازمانهای بهداشتی بسیار سریعتر از تنظیم مقررات و استانداردهای حقوقی، به استفاده از هوش مصنوعی روی آوردهاند. این شکاف نظارتی، پزشکان را مجبور میکند تا همزمان دو نقش متضاد را ایفا کنند:

- برای کاهش خطاها به هوش مصنوعی اعتماد کنند.

- همزمان، مسئولیت کامل تشخیص اشتباهات این سیستمها را نیز بر عهده بگیرند.

مطالعات نشان میدهد که وقتی یک پزشک تحت راهنمایی هوش مصنوعی تصمیم میگیرد، در مقایسه با زمانی که توسط همکاران انسانی مشورت میکند، مردم مسئولیت اخلاقی بیشتری به او نسبت میدهند. حتی اگر شواهد واضحی وجود داشته باشد که هوش مصنوعی اطلاعات نادرست ارائه داده است، باز هم مقصر اصلی پزشک شناخته میشود.

پزشکان اغلب به عنوان افرادی بدون اشتباه دیده میشوند و انتظار میرود که تواناییهای ذهنی، جسمی و اخلاقی استثنایی داشته باشند، انتظاراتی که فراتر از حد معقول برای هر انسانی است.

01

از 03چالشهای پزشکان در استفاده از هوش مصنوعی

پزشکان هنگام کار با هوش مصنوعی با دو چالش پیچیده مواجه هستند:

- خطای مثبت (اعتماد بیش از حد به راهنمایی نادرست هوش مصنوعی)

- خطای منفی (عدم اعتماد به توصیههای صحیح هوش مصنوعی)

این دو چالش پیچیده بین دو فشار متضاد ایجاد میشود:

- از یک سو، سازمانهای بهداشتی، پزشکان را تشویق میکنند تا بر اساس شواهد تصمیمگیری نمایند و هوش مصنوعی را به عنوان ابزاری بیطرف برای تحلیل دادهها معرفی میکنند. این رویکرد میتواند باعث شود پزشکان بیش از حد به ابزارهایی که ممکن است کامل نباشند، متکی شوند.

- از سوی دیگر، پزشکان تحت فشار هستند تا به تجربه و قضاوت شخصی خود اعتماد کنند، حتی در شرایطی که هوش مصنوعی عملکرد بهتری در برخی وظایف نشان داده باشد.

پیچیدگی موضوع با مشکلی به نام فرایند غیرشفاف بیشتر میشود. فرایند غیرشفاف یعنی بسیاری از سیستمهای هوش مصنوعی توصیههایی ارائه میکنند بدون اینکه منطق تصمیمگیری خود را توضیح دهند. حتی اگر این سیستمها واضحتر شوند، روش تصمیمگیری پزشکان و هوش مصنوعی همچنان متفاوت است چرا که هوش مصنوعی الگوهای آماری را از دادههای عظیم شناسایی میکند، اما پزشکان بر اساس استدلال، تجربه و شهود عمل میکنند و بر شرایط خاص بیمار تمرکز دارند.

02

از 03پیامدهای پنهان انتظارات فوقبشری از پزشکان

پیامدهای این انتظارات، هم بر درمان بیماران و هم بر سلامت روانِ پزشکان تأثیر میگذارد. تحقیقات در سایر حوزههای پرتنش نشان میدهد کارکنانی که تحت فشار انتظارات غیرواقعبینانه هستند، اغلب از اقدام میترسند و بیشازحد محتاط میشوند.

به همین ترتیب، پزشکان ممکن است فقط زمانی به هوش مصنوعی اعتماد کنند که توصیههای آن با استانداردهای مراقبتی موجود همخوانی داشته باشد، اما این رویکرد دفاعی خود مشکلاتی ایجاد میکند. به عنوان مثال، با بهبود سیستمهای هوش مصنوعی، محافظهکاری بیش از حد توجیهپذیر نیست، بهویژه اگر رد توصیههای صحیح هوش مصنوعی باعث نتایج بدتر برای بیمار شود.

همچنین این فشارهای روانی میتواند انگیزه و احساس هدفمندی پزشکان را تضعیف کند.

03

از 03راهحل: مسئولیت مشترک و آموزش بهتر

حل این مشکلات تنها به بهبود قابلیت اعتماد هوش مصنوعی خلاصه نمیشود. سازمانهای بهداشتی باید پزشکان را آموزش دهند و مهارتهای لازم را در اختیار آنها قرار دهند تا بتوانند به طور صحیح و متعادل به هوش مصنوعی اعتماد کنند. برخی از راهکارهای عملی در این زمینه عبارتانداز:

- اجرای روشهای استاندارد (مثل چکلیست برای ارزیابی توصیههای هوش مصنوعی)

- رصد نتایج تصمیمهای مبتنی بر هوش مصنوعی برای شناسایی الگوهای قابل اطمینان

- ادغام آموزش شبیهسازی هوش مصنوعی در برنامههای تحصیلی و بیمارستانی

- ایجاد فرهنگ مسئولیت مشترک به جای سرزنش فردی

پزشکان آینده ناگزیر با هوش مصنوعی همکاری خواهند کرد، اما نباید این بار را به تنهایی حمل کنند. با ایجاد محیطی که در آن مسئولیت تقسیم میشود، آموزش در اولویت است و کمالگرایی غیرواقعبینانه انتظار نمیرود، میتوانیم اطمینان حاصل کنیم که هوش مصنوعی یک عامل تقویتکننده هوش انسانی باشد.