مطالعه جدید اپل نشان میدهد که مدلهای زبانی بزرگ با تحلیل دادههای صوتی و حرکتی قادر به شناسایی دقیق فعالیتهای روزمره کاربران هستند.

به گزارش سرویس فناوری تکناک، این رویکرد میتواند حتی در شرایط محدودیت دادههای سنسوری، دقت شناسایی فعالیتها را به طور قابل توجهی افزایش دهد.

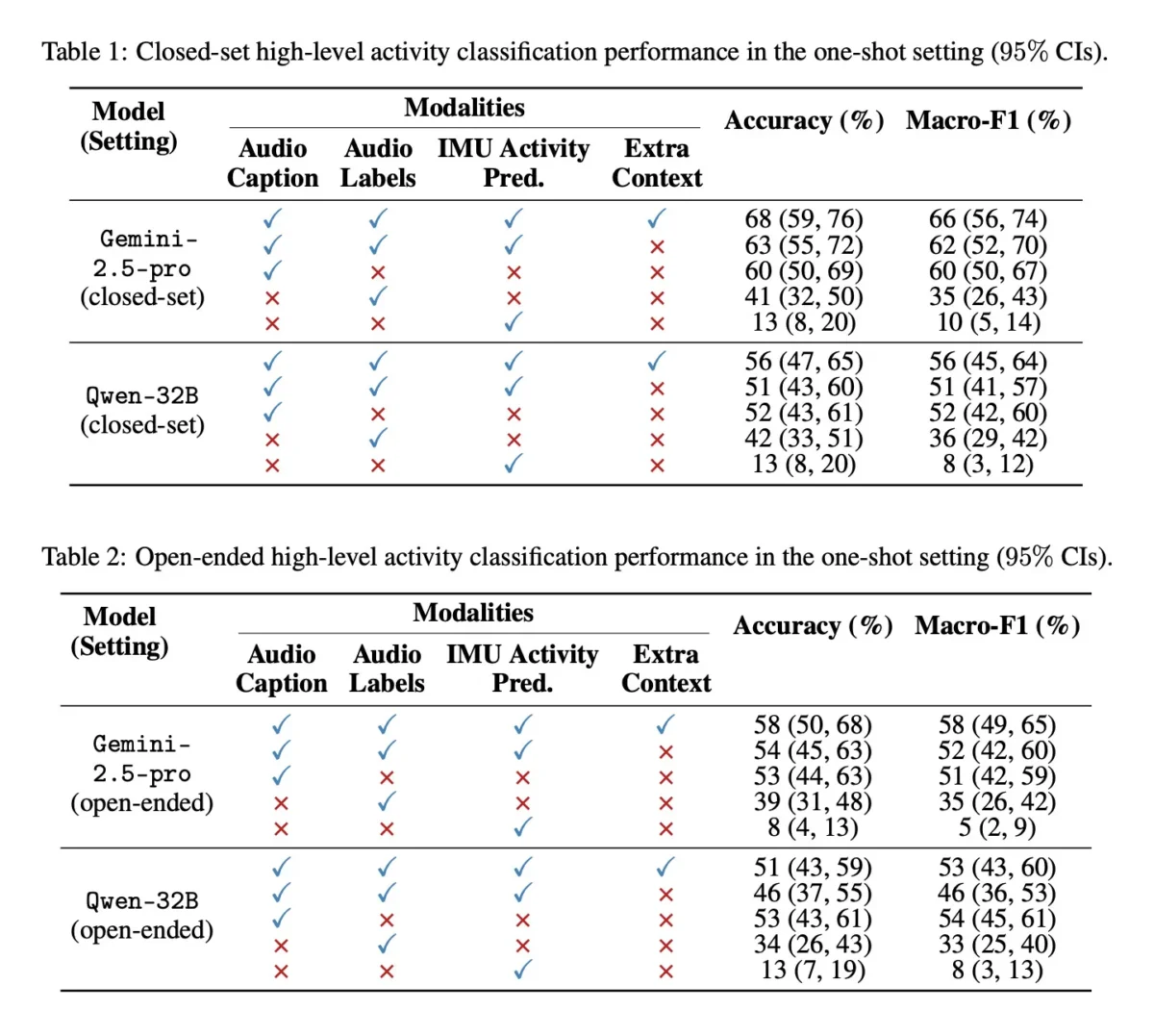

به نقل از 9to5mac، مقالهای با عنوان «استفاده از LLM برای ادغام دیرهنگام حسگرهای چندرسانهای در شناسایی فعالیت» نشان میدهد که ترکیب تحلیل مدلهای زبانی بزرگ با دادههای سنسوری سنتی میتواند درک دقیقتری از فعالیتهای کاربران فراهم کند. نتایج اولیه حاکی از آن است که این مدلها قادر به تشخیص فعالیتها بدون نیاز به آموزش اختصاصی هستند و حتی با ارائه یک نمونه ساده، دقت آنها افزایش مییابد.

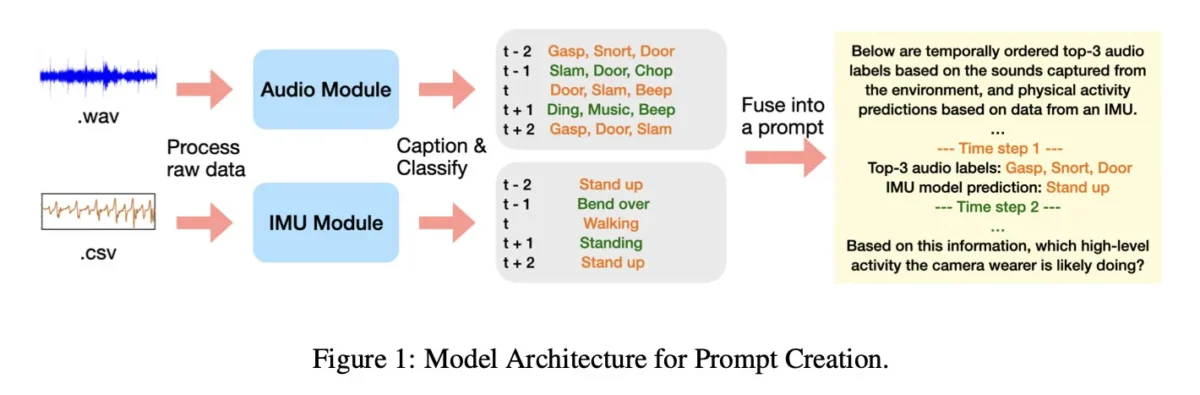

در این تحقیق، مدلها به جای دریافت فایل صوتی کامل، توضیحات کوتاه متنی تولیدشده توسط مدلهای صوتی و مدل حرکتی مبتنی بر IMU را دریافت کردند. دادهها از مجموعه Ego4D جمعآوری شده و شامل فعالیتهای متنوع روزمره و ورزشی مانند: جارو کردن، آشپزی، شستن ظروف، بازی با حیوانات خانگی و ورزشهای مختلف است. مدلهای کوچکتر ابتدا دادهها را به برچسبها و توضیحات متنی تبدیل کردند و سپس خروجیها به LLMهای Gemini-2.5-pro و Qwen-32B داده شد تا میزان شناسایی فعالیتها ارزیابی شود.

نتایج نشان میدهد که ادغام چند مدل میتواند اطلاعات مربوط به فعالیت و سلامت کاربران را حتی در شرایط کمبود دادههای خام سنسوری بهبود دهد. همچنین اپل مواد تکمیلی شامل شناسههای بخشهای Ego4D، زمانبندیها، پرامپتها و مثالهای یکباره را منتشر کرده است تا پژوهشگران بتوانند نتایج را بازتولید کنند.