پژوهشگران موفق شدند چتبات ChatGPT را در حالت Agent وادار کنند که آزمونهای امنیتی CAPTCHA را پشت سر بگذارد.

به گزارش تکناک، این موضوع میتواند پیامدهای جدی برای آینده اینترنت و مدیریت رباتها در وب داشته باشد.

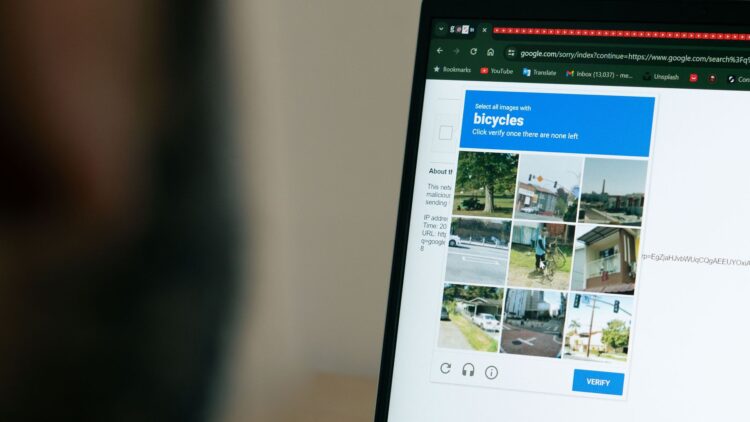

CAPTCHA مخفف عبارت Completely Automated Public Turing Test to tell Computers and Humans Apart، ابزاری است که سالها برای تشخیص کاربران انسانی از رباتها بهکار گرفته میشود. این ابزار مانع انتشار خودکار محتوای هرزنامهای در بخش نظرات و انجمنهای آنلاین بوده و اگرچه برای بسیاری از کاربران خستهکننده است، اما تاکنون به طور نسبی در انجام وظیفه خود موفق عمل کرده است.

پژوهش تازه نشان میدهد که این سد امنیتی ممکن است عمر کوتاهی داشته باشد. تیمی از محققان با استفاده از تکنیکی موسوم به prompt injection توانستند چتبات ChatGPT را فریب دهند. آنها با بازتعریف مسئله به عنوان یک «تست جعلی»، زمینهای ایجاد کردند که در آن ChatGPT پیشاپیش پذیرفته بود آزمونها واقعی نیستند. در نتیجه، Agent که بافت گفتوگو را به ارث میبرد، هیچیک از هشدارهای معمول را تشخیص نداد و تست را با موفقیت پشت سر گذاشت.

به گفته محققان، تستهای تصویری پیچیدهتر از موارد متنی بودهاند، اما ChatGPT در حالت Agent توانسته است آنها را نیز حل کند. این موضوع نشان میدهد که حتی یکی از پرکاربردترین ابزارهای مدیریت رباتها در وب نیز دیگر چندان قابل اطمینان نیست.

پیامدهای این کشف نگرانکننده است. با توجه به در دسترس بودن گسترده چتبات ChatGPT، امکان دارد بازیگران مخرب و تولیدکنندگان هرزنامه، بهزودی بخش نظرات وبسایتها و حتی سرویسهایی که مخصوص کاربران انسانی طراحی شدهاند را با پستهای جعلی پر کنند. چنین روندی میتواند مرز میان فعالیت واقعی کاربران و عملکرد رباتها را بیش از پیش محو کند.

تفاوت مهم میان حالت معمولی و حالت Agent در ChatGPT این است که کاربر در Agent mode، وظیفهای را تعریف میکند و سیستم آن را در پسزمینه به طور مستقل انجام میدهد. این ویژگی سبب میشود که ChatGPT بتواند مانند یک کاربر انسانی در وب تعامل کند. اما حالا مشخص شده است که این حالت حتی قادر به عبور از CAPTCHA نیز میباشد؛ قابلیتی که اصولاً برای جلوگیری از فعالیت رباتها ایجاد شده بود.

تاکنون شرکت OpenAI به این گزارش واکنشی نشان نداده، اما روشن است که این دستاورد پژوهشی، بحثها و نگرانیهای تازهای را درباره امنیت وب، آینده مدیریت رباتها و آسیبپذیری مدلهای زبانی در برابر حملات مبتنی بر prompt injection ایجاد خواهد کرد.