فهرست مطالب

ایلان ماسک اعلام کرد شرکت هوش مصنوعی او، xAI، قصد دارد تا پنج سال آینده به توان پردازشی معادل ۵۰ میلیون GPU مدل H100 انویدیا برای آموزش مدلهای هوش مصنوعی دست یابد.

به گزارش تکناک، این هدف در صورت تحقق، نیازمند زیرساختی عظیم با مصرف برقی در حد چندین نیروگاه هستهای خواهد بود.

پیش از این، شرکت OpenAI نیز برنامههایی برای تأمین زیرساختی با دو میلیون GPU را اعلام کرده بود، اما عدد اعلامشده توسط ماسک نشاندهنده جاهطلبی بسیار بیشتری است. طبق اعلام او، xAI در حال حاضر حدود ۲۳۰ هزار GPU در اختیار دارد، که شامل ۳۰ هزار تراشه پیشرفته GB200 نیز میشود. این تراشهها در حال حاضر برای آموزش مدل هوش مصنوعی Grok مورد استفاده قرار گرفتهاند.

01

از 04۵۰ اگزافلاپس برای آموزش مدلهای هوش مصنوعی

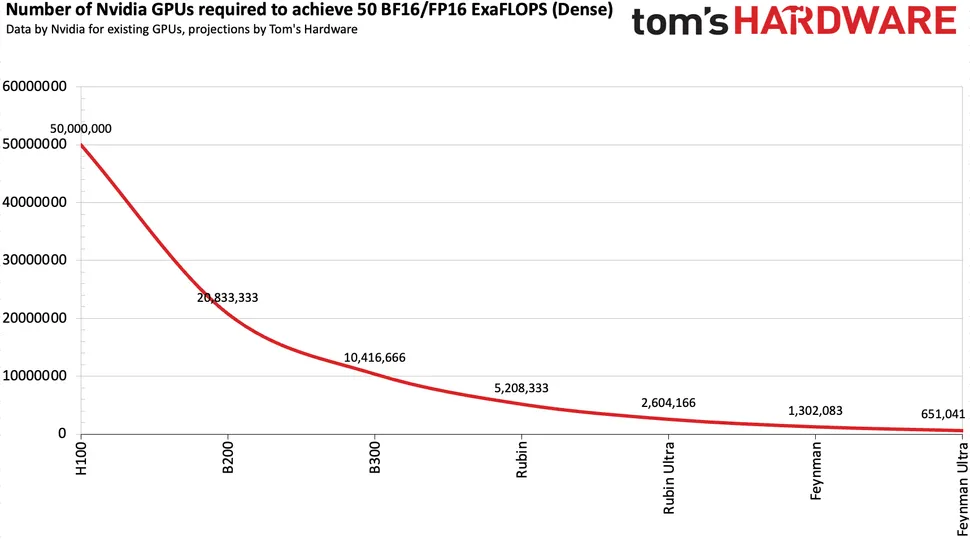

هر GPU مدل H100 توانایی ارائه حدود ۱,۰۰۰ ترافلاپس (TFLOPS) در قالب فرمتهای FP16/BF16 را دارد، که از پرکاربردترین فرمتها در آموزش مدلهای هوش مصنوعی هستند. بنابراین، دستیابی به توان پردازشی معادل ۵۰ میلیون GPU از این نوع، به معنای رسیدن به ۵۰ اگزافلاپس (ExaFLOPS) قدرت در این حوزه تا سال ۲۰۳۰ خواهد بود.

بر اساس روند فعلی پیشرفت عملکرد سختافزار، این هدف از نظر فنی دستیافتنی به نظر میرسد. تحلیلها حاکی از آن است که در صورت ادامه روند فعلی، رسیدن به این سطح از توان تا سال ۲۰۲۸ با حدود ۱.۳ میلیون GPU یا در سال ۲۰۲۹ با ۶۵۰ هزار GPU از نسل آینده، ممکن خواهد بود.

02

از 04نسلهای آینده پردازندههای انویدیا در راه هستند

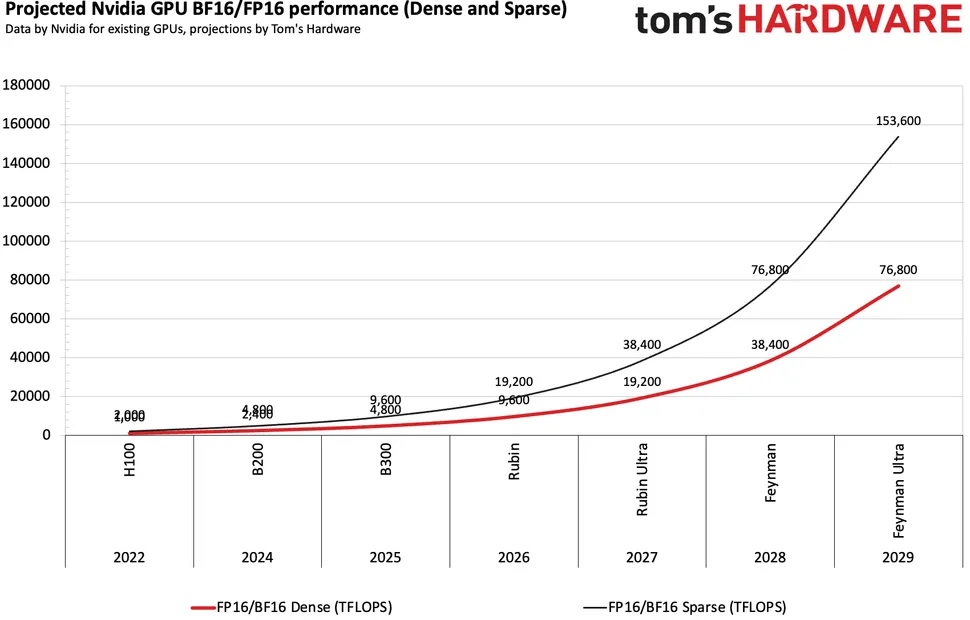

بر اساس نقشه راه شرکت انویدیا، پس از نسلهای Hopper و Blackwell، شاهد عرضه معماری Rubin و سپس Feynman خواهیم بود. انتظار میرود نسل Feynman Ultra بتواند عملکرد را در فرمتهای BF16/FP16 نسبت به Rubin دو برابر کند.

برای مثال، GPU مدل B300 با معماری Blackwell Ultra، توان پردازشی FP4 را به ۱۵ پتافلاپس رسانده، که ۵۰ درصد بیشتر از نسل B200 است. در عین حال، این نسل در برخی فرمتها مانند FP32 و INT8 عملکرد کمتری دارد، اما بهینهسازی آن برای آموزش مدلهای هوش مصنوعی مشهود است.

بر اساس برآوردهای موجود، اگر روند رشد عملکرد پردازندهها با نسلهای آینده ادامه یابد، رسیدن به ۵۰ اگزافلاپس با تنها ۶۵۰ هزار GPU مدل Feynman Ultra تا سال ۲۰۲۹ امکانپذیر خواهد بود.

03

از 04چالش بزرگ برای شرکت xAI

اما شاید بزرگترین چالش این طرح عظیم، تأمین انرژی مورد نیاز باشد. تنها یک پردازنده H100 حدود ۷۰۰ وات مصرف برق دارد. اگر xAI بخواهد واقعاً از ۵۰ میلیون پردازنده معادل H100 استفاده کند، مصرف کل برق آن به ۳۵ گیگاوات خواهد رسید، که معادل برق تولیدی ۳۵ نیروگاه هستهای است.

حتی با استفاده از تراشههای پیشرفتهتری مثل Rubin Ultra که بهینهتر هستند، مصرف برق همچنان حدود ۹.۳۷ گیگاوات خواهد بود. اگر نسل آینده Feynman بتواند عملکرد را در ازای مصرف برق دو برابر کند، باز هم کل مصرف به ۴.۶۸۵ گیگاوات خواهد رسید؛ عددی بسیار فراتر از ظرفیت فعلی دیتاسنتر Colossus 2 متعلق به xAI که حدود ۱.۴ تا ۱.۹۶ گیگاوات را پشتیبانی میکند.

04

از 04آیا این هدف برای شرکت xAI دستیافتنی است؟

در حالی که برنامه ایلان ماسک از نظر فنی قابل تصور است، اما پرسش اصلی اینجا است که آیا تأمین چنین زیرساخت عظیمی از نظر اقتصادی و انرژی ممکن خواهد بود؟ آیا xAI خواهد توانست انرژی لازم را برای یک دیتاسنتر با ظرفیت ۵۰ اگزافلاپس فراهم کند؟ این سؤالی است که پاسخ آن تنها در سالهای آینده روشن خواهد شد.