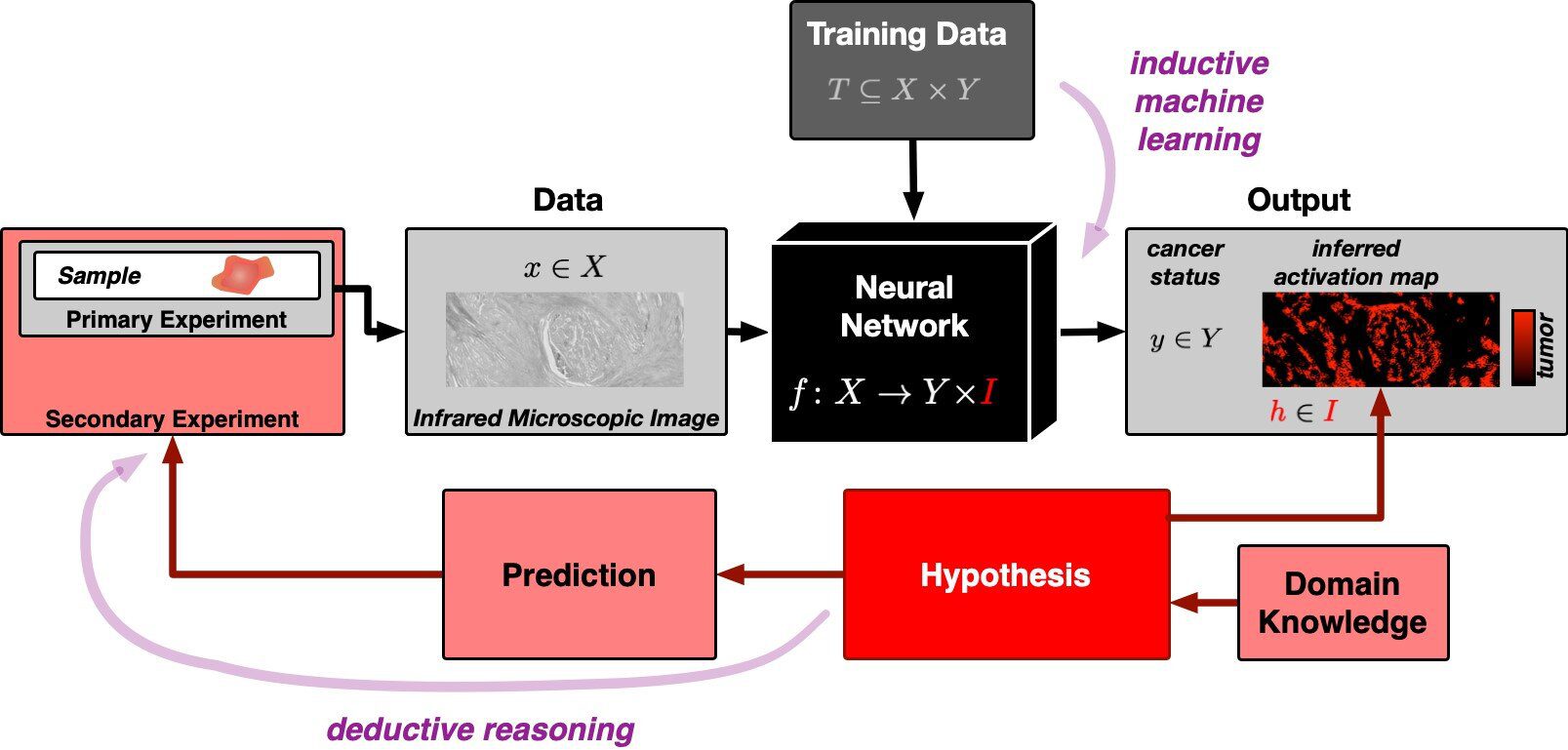

هوش مصنوعی (AI) را می توان برای تشخیص بافت حاوی تومور در تصویر آموزش داد. با این حال، نحوه تصمیم گیری دقیق هوش مصنوعی تاکنون یک راز بودهاست. یک تیم تحقیقاتی از دانشگاه روهر بوخوم رویکرد جدیدی برای شفافسازی تصمیمات هوش مصنوعی در تشخیص تومورها از بافتهای میکروسکوپی توسعه داده است. در این مطالعه، محققان یک شبکه عصبی طراحی کردند که میتواند تصاویر بافت حاوی تومور را از بدون تومور تشخیص دهد. این سیستم از استدلال استقرایی برای تصمیمگیری استفاده کرده و علاوه بر شناسایی تومور، نقشهای از فعالیتهای شبکه عصبی نیز ایجاد میکند که نشاندهنده محلهای احتمالی تومور در تصویر است. این رویکرد بهطور خاص به آزمایشپذیری فرضیههای شبکه عصبی تأکید دارد، که این امر باعث میشود هوش مصنوعی در کاربردهای پزشکی قابل اعتمادتر و شفافتر باشد.

به گزارش تک ناک، تیمی از مرکز تحقیقات تشخیص پروتئین (PRODI) در دانشگاه روهر بوخوم در حال توسعه رویکرد جدیدی است که تصمیم هوش مصنوعی را شفاف و در نتیجه قابل اعتمادتر خواهد کرد. محققان به سرپرستی پروفسور اکسل موسیگ این رویکرد را در ژورنال آنالیز تصویر پزشکی توصیف کردند.

- بیشتر بخوانید: هوش مصنوعی در هوش هیجانی از انسان پیشی گرفت

برای این مطالعه، اکسل موسیگ، دانشمند بیوانفورماتیک، با پروفسور آندریا تاناپفل، رئیس مؤسسه آسیب شناسی، پروفسور آنک ریناچر، شیک انکولوژیست از بیمارستان دانشگاه سنت جوزف روهر ، و پروفسور کلاوس گرورت، بیوفیزیکدان و مدیرو مؤسس پرودی همکاری کردند.

این گروه یک شبکه عصبی، یعنی یک هوش مصنوعی، با توانایی شناسایی و طبقه بندی نمونه بافتی حاوی تومور اختراع کردند. برای این منظور، آنها تعداد زیادی تصویر بافت میکروسکوپی را به هوش مصنوعی دادند که برخی از آنها حاوی تومور بودند، در حالی که برخی دیگر بدون تومور بودند.

اکسل موسیگ توضیح میدهد: شبکههای عصبی در ابتدا یک جعبه سیاه هستند، مشخص نیست که شبکه کدام ویژگیهای شناسایی را از دادههای آموزشی میآموزد. برخلاف متخصصان انسانی، آنها توانایی توضیح تصمیمات خود را ندارند. دیوید شوماچر، دانشمند بیوانفورماتیک، که در این مطالعه همکاری داشت، میافزاید: با این حال، برای کاربردهای پزشکی بهویژه، مهم است که هوش مصنوعی قادر به توضیح و در نتیجه قابل اعتماد باشد.

فهرست مطالب

پایه تصمیم گیری هوش مصنوعی بر اساس فرضیه های آزمون پذیر است

هوش مصنوعی تیم بوخوم تنها قابلیت توضیح بر اظهارات معنادار شناخته شده برای علم را دارد. بر اساس فرضیه های آزمون پذیر اگر یک فرضیه نادرست است، این واقعیت باید از طریق آزمایش قابل اثبات باشد. هوش مصنوعی معمولاً از اصل استدلال استقرایی پیروی می کند. هوش مصنوعی با استفاده از مشاهدات عینی، یعنی داده های آموزشی، یک مدل کلی ایجاد می کند که بر اساس آن تمام مشاهدات بعدی را ارزیابی می کند.

- بیشتر بخوانید: چگونه از ابزار هوش مصنوعی character.ai استفاده کنیم؟

مشکل اساسی 250 سال پیش توسط فیلسوف دیوید هیوم توصیف شده بود و به راحتی می توان آن را توضیح داد. مهم نیست که چقدر قوهای سفید را مشاهده می کنیم، هرگز نمی توانیم از این داده ها نتیجه بگیریم که همه قوها سفید هستند و هیچ قو سیاهی وجود ندارد. بنابراین علم از منطق به اصطلاح قیاسی استفاده می کند. در این رویکرد، یک فرضیه کلی نقطه شروع است. به عنوان مثال، این فرضیه که همه قوها سفید هستند، زمانی که یک قو سیاه دیده می شود، رد می شود.

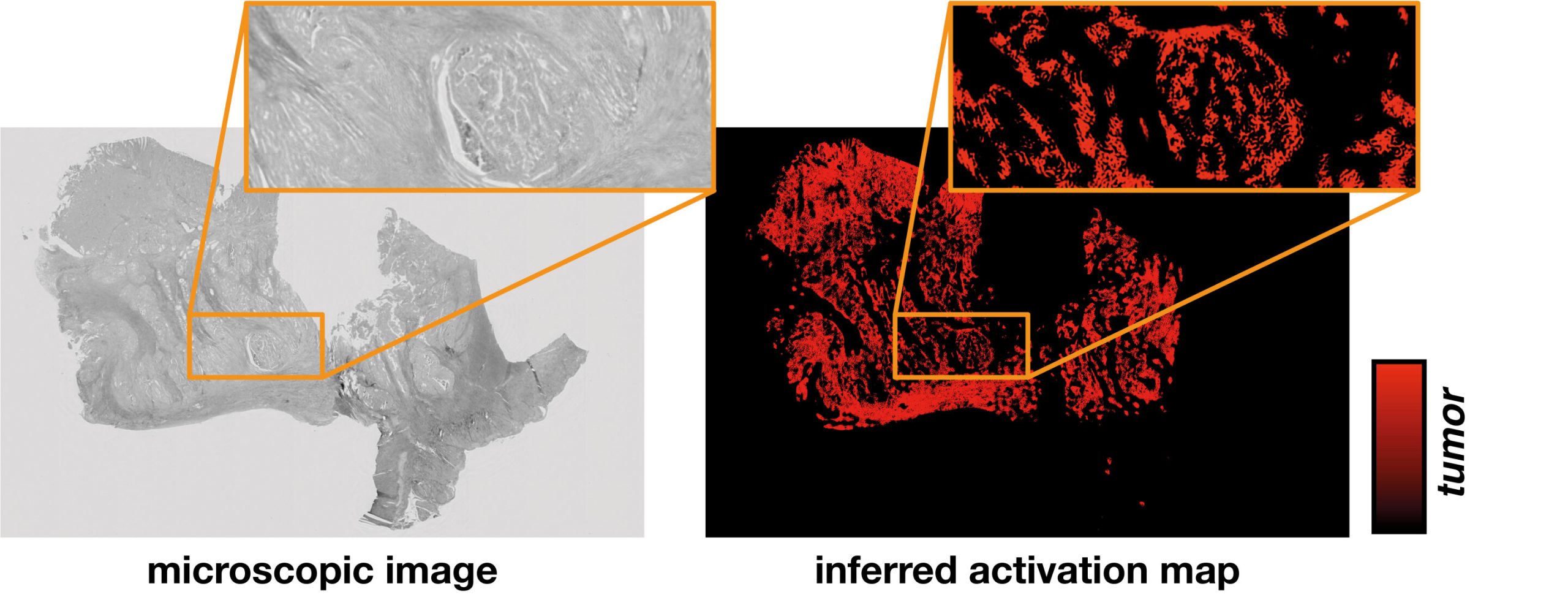

نقشه فعال سازی محل شناسایی تومور را نشان می دهد

استفانی شرنر، فیزیکدانی که به همین ترتیب در این مطالعه مشارکت داشته است، می گوید: «در نگاه اول، هوش مصنوعی استقرایی و روش علمی قیاسی تقریباً ناسازگار به نظر می رسند. اما محققان راهی پیدا کردند. شبکه عصبی جدید آنها نه تنها می تواند استنتاج کند که آیا نمونه بافت حاوی تومور است یا عاری از تومور، بلکه نقشه فعال سازی بافت میکروسکوپی را نیز به تصویر میکشد.

نقشه فعال سازی بر اساس یک فرضیه آزمون پذیر است، یعنی اینکه فعال سازی به دست آمده از شبکه عصبی دقیقاً با مناطق تومور در نمونه مطابقت دارد. برای آزمایش این فرضیه می توان از روش های مولکولی ویژه خاستگاه استفاده کرد.

اکسل موسیگ نتیجه می گیرد: به لطف ساختارهای بین رشته ای در PRODI، ما بهترین پیش نیازها را برای ترکیب رویکرد مبتنی بر فرضیه در توسعه شاخص زیستی هوش مصنوعی قابل اعتماد در آینده در اختیار داریم، به عنوان مثال قادر به تمایز بین برخی زیرگروه های تومور مرتبط با درمان خواهیم بود. روش تشخیص تومور آسان تر میشود.

اگر از این مطلب لذت بردید، حتما سایر آخرین اخبار هوش مصنوعی را هم بررسی کنید! مطالب ما پر از اطلاعات مفید و جذاب هستند که میتوانند به شما کمک کنند تا به راحتی با دنیای جدید آشنا شوید. همراه ما باشید و دانش خود را گسترش دهید!