فهرست مطالب

متا، با همکاری بنیاد ویکیمدیا، مدل جدیدی از یادگیری ماشینی را توسعه داده است که قادر است استنادهای ویکیپدیا را به طور خودکار بررسی کند تا صحت یا نادرستی ادعاها را ارزیابی کند. این مدل با استفاده از دادههای ویکیپدیا، میتواند استنادها را تجزیه و تحلیل کرده و منابع معتبر را پیشنهاد دهد. این فناوری هنوز در مراحل ابتدایی است و نیاز به دادههای بیشتری برای بهبود عملکرد دارد. هدف این مدل کمک به دقت و صحت مقالات ویکیپدیا است، بهویژه در مورد استنادهای نادرست یا جعلی. با این حال، چالشهایی در زمینه اعتبار منابع و کیفیت اطلاعات باقی مانده است که باید حل شود. در ادامه ارتقای هوش مصنوعی متا به بررسی آخرین اخبار هوش مصنوعی میپردازیم.

به گزارش تک ناک، ویکیپدیا یکی از بزرگترین پروژههای مشارکتی در تاریخ بشر است. بیش از یک صدهزار ویراستار داوطلب در ساخت و نگهداری یک دایرهالمعارف بسیار بزرگ و چند زبانه متشکل از میلیونها مقاله مشارکت دارند.هر ماه بیش از 17000 مقاله جدید به ویکیپدیا اضافه میشود، در حالی که به طور مداوم تغییرات و اصلاحات بر روی مجموعه مقالات موجود در آن انجام میشود. محبوبترین مقالات ویکی منعکسکننده جدیدترین تحقیقات، بینشها و اطلاعات بهروز هستند هزاران بار ویرایش شدهاند.

چالش، البته، دقت است. وجود ویکیپدیا ثابت میکند که تعداد زیادی از انسانها میتوانند برای خلق چیزی مثبت گرد هم آیند. اما برای اینکه مقالههای ویکیپدیا واقعاً مفید باشند و دیوار گرافیتی گستردهای از ادعاهای بیثبات نباشند، باید با فکت ها پشتیبانی شوند.اینجاست که راستی آزمایی ها وارد میشوند. این ایده که در بیشتر موارد این کار بسیار جوابگو است این است که کاربران و ویراستاران ویکیپدیا میتوانند لینک هایی را که منابع و وفکت های مقاله را راستی آزمایی و تأیید می کنند را با یک کلیک به مقاله خود بیفزایند.

01

از 04استناد مورد نیاز است

برای مثال من میخواهم مقاله باراک اوباما در ویکیپدیا را تأیید کنم که بیان میکند وی در سال 1988 به اروپا و سپس کنیا سفر کرد، جایی که برای اولین بار با بسیاری از بستگان پدریاش ملاقات کرد. تنها کاری که باید انجام دهم این است که به نقلقولهای جمله نگاه کنید و مطمئناً، سه مرجع کتاب جداگانه وجود دارد که ظاهراً تأیید میکند که این مطلب درست است.

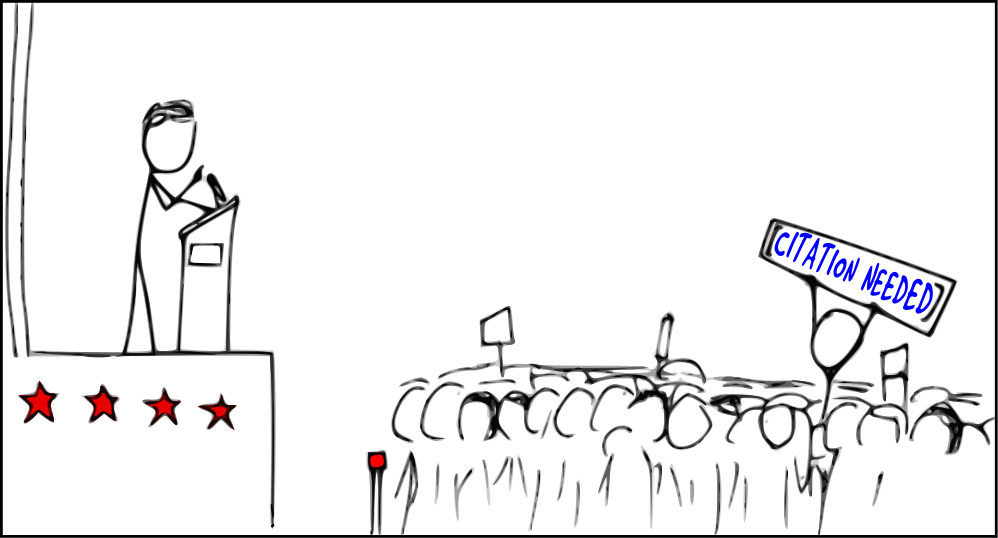

در مقابل، عبارت «نیاز به استناد» احتمالاً مذمومترین عبارت در تمام ویکیپدیاها است، زیرا آنها نشان میدهد که هیچ مدرکی وجود ندارد که نویسنده کلمات را از اثر دیجیتال القا نکرده باشد. عنوان «نیاز به استناد» که به یک ادعای ویکیپدیا اضافه شده است، معادل گفتن یک واقعیت نقل شده غیر واقعی است.

با این حال، استنادها همه چیز را به ما نمی گوید. اگر به شما بگویم که سال گذشته، من بیست و سومین روزنامهنگار پردرآمد فناوری در جهان بودم و یک دور دنیا را گشته ام، به نظر میرسد که این ادعا به طور سطحی قابل قبول است زیرا لینکهایی برای پشتیبانی توهمات من وجود دارد.

- بیشتر بخوانید: OpenAI بهدنبال ساخت مرکز داده بزرگی در ابوظبی امارات است

این واقعیت که لینکها به هیچ وجه از حقایق جایگزین من پشتیبانی نمیکنند، بلکه منجر به هدایت مخاطب صفحات غیرمرتبط در اینترنت میشوند، تنها زمانی آشکار میشود که روی آنها کلیک کنید.

برای 99.9 درصد از خوانندگانی که هرگز من را ندیده اند، ممکن است این مقاله را با انبوهی از تصورات نادرست ترک کنند. در دنیای ابرپیوندی مفرط اطلاعات، که در آن ما به طور فزایندهای در مورد چیزی که نیکلاس کار از آن به عنوان «کم عمقیها» یاد میکند، سر و صدا میکنیم، به نظر میرسد که وجود این لینک های استناد خود گواه این مسئله باشد.

02

از 04متا وارد می شود

اما اگر استناد هایی که توسط ویراستاران به ویکیپدیا اضافه می شوند به صفحاتی که واقعاً ادعاها را پشتیبانی میکنند پیوند نشوند، چه اتفاقی میافتد؟ به عنوان مثال، مقاله اخیر ویکیپدیا در مورد جو هیپ عضو قبیله بلکفیت، توضیح میدهد که چگونه هیپ اولین بوکسور بومی آمریکایی بود که برای کسب عنوان WBA به چالش کشیده شد و به صفحه وب مناسبی پیوند خورد. با این حال، صفحه وب مورد بحث مطلبی در مورد بوکس و جو هیپ را ذکر کرد.

در مورد ادعای جو هیپ، مطلب ویکیپدیا دقیق بود، حتی اگر استناد نامناسب بود. با این وجود، به راحتی می توان دید که چگونه می توان از این موضوع، عمدا یا سهوا ، برای انتشار اطلاعات نادرست استفاده کرد.

اینجاست که متا فکر میکند راهی برای کمک ابداع کرده است. Meta AI (که آزمایشگاه تحقیق و توسعه هوش مصنوعی برای غول رسانه های اجتماعی است) با همکاری با بنیاد ویکی مدیا، اولین مدل یادگیری ماشینی را توسعه داده است که می تواند صدها هزار استناد را به طور خودکار اسکن کند تا درستی یا نادرستی ادعاهای مطروحه را بررسی کند. در حالی که این ربات با اولین رباتی که ویکیپدیا استفاده میکند بسیار فاصله دارد، اما میتواند بسیار تاثیرگذارترینها باشد.

فابیو پترونی، مدیر ارشد فناوری تحقیقاتی تیم FAIR (تحقیقات بنیادی هوش مصنوعی) از تیم هوش مصنوعی متا ، به Digital Trends گفت: ما میخواستیم ببینیم محدودیت این فناوری چیست. ما کاملاً مطمئن نبودیم که این هوش مصنوعی بتواند در این زمینه کار معناداری انجام بدهد یا نه. هیچ کس تا به حال سعی نکرده بود کاری مشابه انجام دهد.

03

از 04درک معنا

ابزار هوش مصنوعی متا که با استفاده از مجموعه های دادهای متشکل از 4 میلیون استناد ویکیپدیا آموزش دیده است، میتواند به طور موثر اطلاعات مربوط به یک استناد را تجزیه و تحلیل کند و سپس آن را به شواهد پشتیبان ارجاع دهد و این فقط یک مقایسه متنی رشته ای (string) ساده نیست.

پترونی گفت: با این مدلها، کاری که ما انجام دادهایم این است که فهرستی از تمام این صفحات وب ایجاد کردهایم که آنها را به قسمتهایی تقسیم میکنیم و یک نمایش دقیق برای هر قسمت ارائه میکنیم. این نشاندهنده کلمه به کلمه متن نیست، بلکه معنای آن متن است. این بدان معناست که دو تکه متن با معانی مشابه در یک موقعیت بسیار نزدیک در فضای n بعدی که در آن همه این قسمتها ذخیره میشوند، نمایش داده میشوند.

- بیشتر بخوانید: ویکیپدیا استراتژی سهساله هوش مصنوعی خود را مشخص کرد

با این حال، به همان اندازه که توانایی تشخیص استنادهای جعلی قابل توجه است، این ابزار پتانسیل پیشنهاد مراجع بهتر را نیز دارد. این ابزار که به عنوان یک مدل تولید به کار گرفته میشود، میتواند منابعی پیشنهاد کند که به بهترین نحو یک مفهوم ویک موضوع خاص را ترسیم کند. در حالی که پترونی از تشبیه آن به یک بررسی املایی واقعی، علامت گذاری خطاها و پیشنهاد بهبودها خودداری می کند، ساده ترین مسیر برای فکر کردن در مورد کارهایی است که این ابزار ممکن است انجام دهد.

اما همانطور که پترونی توضیح میدهد، هنوز کارهای بیشتری باید انجام شود تا این ابزار به این نقطه برسد. او گفت: آنچه ما ساختهایم دلیلی براثبات این مفهوم است. این ابزار در حال حاضر واقعاً قابل استفاده نیست. برای اینکه بتوان از این ابزار هوش مصنوعی استفاده کرد ، باید یک فهرست تازه داشته باشید که داده های بسیار بیشتری از آنچه در حال حاضر داریم جمع آوری کند.

این فهرست جدید باید با اطلاعات جدید روزانه به روزرسانی شود. حداقل در تئوری، این ابزار می تواند نه تنها متن، بلکه چند رسانه ای را نیز شامل شود. شاید یک مستند معتبر در YouTube وجود داشته باشد که سیستم بتواند کاربران را به سمت آن هدایت کند. شاید پاسخ به یک ادعای خاص در یک تصویر آنلاین پنهان شده باشد.

04

از 04مساله کیفیت و ارتقای هوش مصنوعی متا

در این میان اما چالش های دیگری نیز وجود دارد. در غیاب این ابزار به طور قابل توجهی هرگونه تلاش برای درجهبندی مستقل کیفیت منابع ذکر شده چالش برانگیز است.

الگوریتم رتبه بندی تریلیون دلاری گوگل -معروف ترین الگوریتمی که تا به حال بر اساس استنادها ساخته شده است –در مدل خود با یک منبع با کیفیت بالا را با منبعی که تعداد لینک های ورودی بالایی دارد ولی ممکن است کیفیت پایینی داشته باشد معادل سازی میکند. اما عملکرد هوش مصنوعی اینگونه عمل نمی کند.

اگر قرار بود ابزار هوش مصنوعی متا به عنوان یک ابزار موثر عمل کند، باید چیزی شبیه به الگوریتم گوگل می بود. به عنوان یک مثال فرض کنید که فردی میخواهد فاحش ترین و مذموم ترین نظر را برای درج در صفحه ویکی پدیا “اثبات” کند . اگر تنها شواهد مورد نیاز برای تأیید صحت چیزی این باشد که مطالب مشابه آن جای دیگر آنلاین منتشر شده باشد یا خیر، تقریباً هر ادعایی که مهم نیست چقدر اشتباه باشد از نظر فنی قابل اثبات است.پترونی گفت: یکی از حوزههایی که ما به آن علاقهمندیم تلاش برای مدلسازی قابل اعتماد بودن یک منبع، تلاش برای یافتن معتبر بودن یک دامنه (domain) است.

“فکر میکنم ویکیپدیا از قبل فهرستی از دامنههایی دارد که قابل اعتماد نیستند و البته دامنههایی که در نظر گرفته نمیشوند اما به جای داشتن یک لیست ثابت، بهتر است راهی برای ارتقای الگوریتمی این لیست پیدا کنیم.”

اگر از این مطلب لذت بردید، حتما سایر اخبار فناوری را هم بررسی کنید! مطالب ما پر از اطلاعات مفید و جذاب هستند که میتوانند به شما کمک کنند تا به راحتی با دنیای جدید آشنا شوید. همراه ما باشید و دانش خود را گسترش دهید!