ابزارهای یادداشتبرداری پزشکی مبتنی بر هوش مصنوعی که با هدف تسهیل کار پزشکان طراحی شدهاند، به تازگی با چالشهای جدی روبرو شده اند.

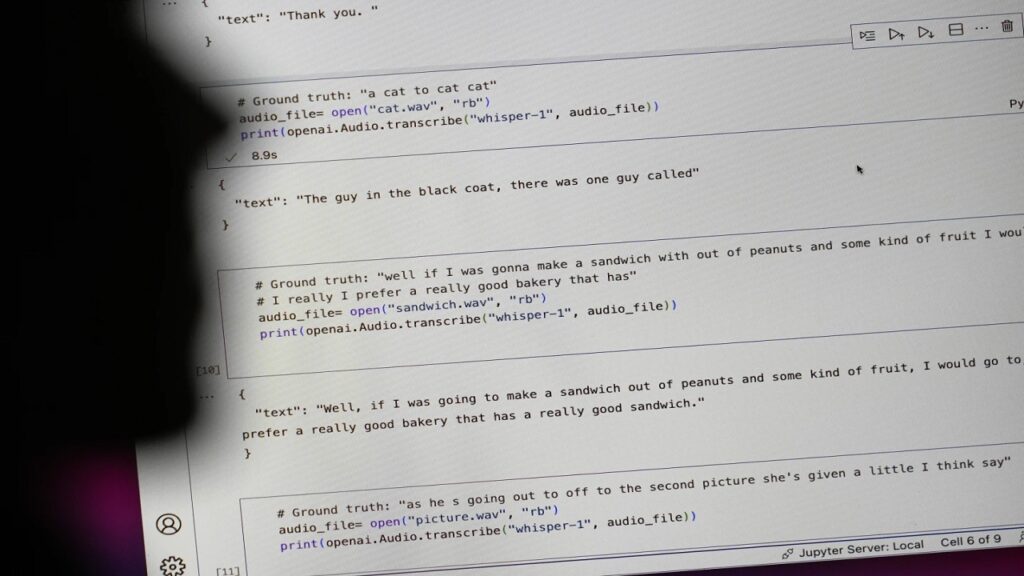

به گزارش تکناک، تحقیقات جدید نشان میدهد که این ابزارها، به ویژه آنهایی که از مدل زبانی Whisper شرکت OpenAI استفاده میکنند، به طور مرتب اطلاعات نادرست و ساختگی تولید میکنند.

یک مطالعه جامع نشان داده است که در حدود 80 درصد از موارد، این ابزارها در رونویسیهای پزشکی اشتباهات فاحشی مرتکب میشوند. از جمله این اشتباهات میتوان به تغییر کامل معنا، اختراع اصطلاحات پزشکی بیمعنی و حتی اشتباه در تشخیص ویژگیهای ظاهری افراد اشاره کرد.

به عنوان مثال، در یکی از موارد، جمله سادهای درباره برداشتن چتر به یک داستان پیچیده و خونین تبدیل شده است. نمونههای دیگری نیز وجود دارند که نشان میدهند این ابزار حتی در تشخیص ویژگیهای ظاهری افراد مانند رنگ پوست نیز دچار خطا میشود.

یکی دیگر از موارد نگرانکننده، تولید اصطلاحات پزشکی ساختگی توسط این ابزار است. به عنوان مثال، عبارت آنتیبیوتیکهای هایپر فعال که اصلاً وجود ندارد، توسط این ابزار تولید شده است.

این موضوع نگرانیهای جدی در مورد استفاده از هوش مصنوعی در حوزه پزشکی ایجاد کرده است، جایی که حتی کوچکترین خطا میتواند عواقب جبرانناپذیری داشته باشد.

با وجود این، شرکتهای توسعهدهنده این ابزارها همچنان به استفاده از مدلهای زبانی پرخطر ادامه میدهند. Nabla، یکی از این شرکتها، مدعی است که بیش از 45 هزار پزشک در بیش از ۸۵ سازمان بهداشتی از ابزار آنها استفاده میکنند. اما حتی خود شرکت OpenAI نیز به صراحت از استفاده از مدل Whisper برای یادداشتبرداری حیاتی اجتناب کرده و هشدار داده است که استفاده از آن در تصمیمگیریهای بالینی که خطای دقت میتواند باعث عواقب جدی شود، مخاطرهآمیز است.

با وجود این، چرا این اتفاق میافتد؟ یکی از دلایل اصلی این است که این ابزارها برای حفظ حریم خصوصی بیماران، ضبطهای صوتی اصلی را حذف میکنند و در نتیجه امکان بررسی صحت اطلاعات تولیدشده وجود ندارد.

اگرچه Nabla از کاربران خود میخواهد که یادداشتهای رونویسی شده را ویرایش و تأیید کنند. در این صورت بررسی متن استخراج شده از هوش مصنوعی با بیماری که هنوز در اتاق پزشک است به ارائهدهنده خدمات بهداشتی فرصتی میدهد تا تأیدیه صحت نتایج را به دست آورد و حتی در صورت نادرست بودن دادههای تحویل داده شده توسط رونویسی هوش مصنوعی، اطلاعات را با بیمار مجدد بررسی و سپس تأیید نماید.

این موضوع نشان میدهد که اگرچه هوش مصنوعی میتواند ابزار قدرتمندی باشد، اما عاری از خطا نیست و هنوز هم به نظارت انسانی نیاز دارد. ما نمیتوانیم به طور کامل به این ابزارها اعتماد کنیم و باید همیشه نتایج آنها را با دقت بررسی نماییم.

در نهایت، این مسئله زنگ خطری برای توسعهدهندگان هوش مصنوعی است تا با دقت بیشتری به این فناوری نزدیک شوند و از ایجاد ابزارهایی که میتوانند خطرات جدی برای سلامت انسان ایجاد نمایند، خودداری کنند