فهرست مطالب

پژوهشگران اپل، مدل انتشارمحور (diffusion model) جدیدی معرفی کردهاند که میتواند متن را تا 128 برابر سریعتر از مدلهای زبانی مشابه تولید کند.

به گزارش تکناک، مدلهای زبانی بزرگ (LLM) مانند ChatGPT از نوع خودرگرسیو هستند، یعنی متن را توکن به توکن و به صورت متوالی تولید میکنند و هر مرحله تولید به توکنهای قبلی و درخواست کاربر وابسته است. این روند باعث میشود که تولید متن طولانی، زمانبر باشد و سرعت پردازش محدود شود. برخلاف مدلهای خودرگرسیو، مدلهای انتشارمحور قادر هستند چندین توکن را به طور همزمان تولید کنند و آنها را طی چند مرحله تکراری اصلاح نمایند تا پاسخ نهایی شکل گیرد. این قابلیت باعث میشود که سرعت تولید متن به طرز چشمگیری افزایش یابد. یکی از انواع مدلهای انتشارمحور، مدلهای flow-matching است. این مدلها در عمل، مراحل تکراری مدلهای انتشارمحور را کنار میگذارند و یاد میگیرند که نتیجه نهایی را یکباره تولید کنند. نتیجه، تولید متن طولانی با سرعتی بیسابقه است. برای علاقهمندان به جزئیات فنی، اپل منابعی درباره مدل انتشارمحور برای کدنویسی و مدل flow-matching برای تا شدن پروتئین منتشر کرده است. این منابع نشان میدهند که چگونه مدلهای زبانی جدید اپل میتوانند تولید متن طولانی را با سرعت و دقت بالا ممکن سازند.

01

از 01روش کار مدل زبانی جدید اپل

در مطالعهای که امروز با عنوان «FS-DFM: تولید سریع و دقیق متنهای طولانی با مدلهای انتشارمحور چند مرحلهای» منتشر شد، پژوهشگران اپل و دانشگاه اوهایو، مدل جدیدی به نام Few-Step Discrete Flow-Matching (FS-DFM) ارائه کردند. در این مطالعه نشان داده شد که FS-DFM قادر است متنهای کامل را تنها با هشت مرحله سریع اصلاح تولید کند، بدون اینکه کیفیت متن پایین بیاید، در حالی که مدلهای انتشارمحور سنتی برای رسیدن به کیفیت مشابه به بیش از هزار مرحله نیاز داشتند.

پژوهشگران برای دستیابی به این سرعت از یک رویکرد سهمرحلهای جالب استفاده کردند:

- ابتدا مدل برای مدیریت بودجههای متفاوت از مراحل اصلاح آموزش داده شد.

- سپس از یک مدل «معلم» هدایتکننده بهره بردند تا در هر مرحله تغییرات بزرگتر و دقیقتری انجام دهد، بدون اینکه متن بیش از حد اصلاح شود.

- در نهایت، نحوه عملکرد هر مرحله بهینه شد تا مدل بتواند با گامهای کمتر و پایدار به نتیجه نهایی برسد.

زمانی که FS-DFM با مدلهای بزرگتر انتشارمحور مقایسه شد، عملکرد خوبی در دو معیار کلیدی پیچیدگی متن و نااطمینانی از خود نشان داد. به طور خلاصه، پیچیدگی متن یک معیار استاندارد برای سنجش کیفیت متن در مدلهای زبانی است. هرچه این مقدار کمتر باشد، متن دقیقتر و طبیعیتر به نظر میرسد.

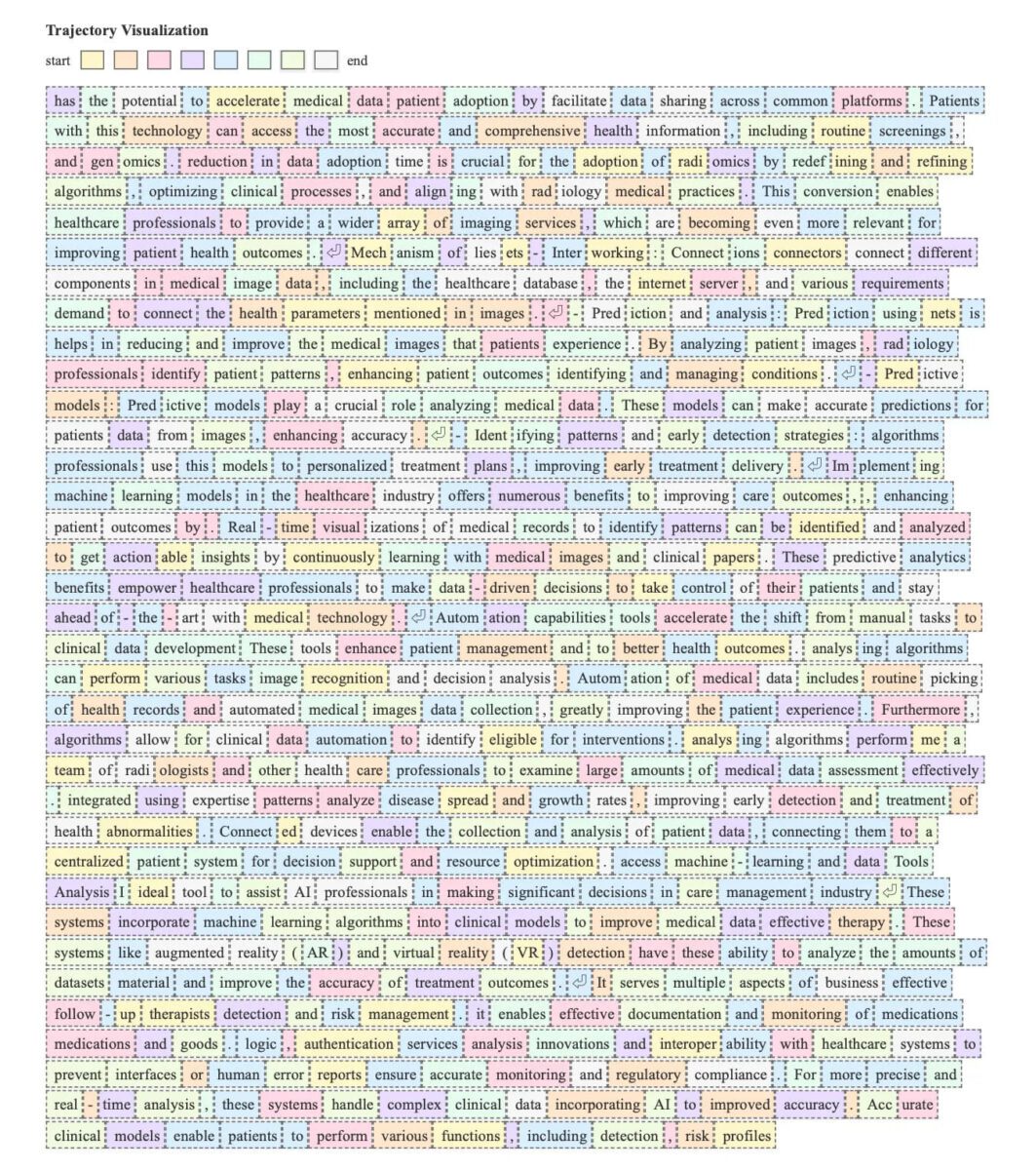

توجه داشته باشید که بسیاری از توکنها به رنگ زرد هستند؛ این نشان میدهد که آنها در ابتدای فرایند پیشبینی شدهاند. این موضوع به دلیل مقدار تجمعی اسکالر رخ میدهد، که بر ترتیب و شدت اصلاحات مدل تأثیر میگذارد.

همچنین نااطمینانی مدل، میزان اعتماد مدل در انتخاب هر کلمه را نشان میدهد. در عمل، اگر نااطمینانی مدل خیلی پایین باشد، متن تکراری یا قابل پیشبینی خواهد بود و اگر خیلی بالا باشد، متن ممکن است نامنسجم یا تصادفی به نظر برسد.

زمانی که FS-DFM با مدلهای انتشارمحور Dream با 7 میلیارد پارامتر و LLaDA با 8 میلیارد پارامتر مقایسه شد، نسخههای FS-DFM با 1.7، 1.3 و 0.17 میلیارد پارامتر به طور مداوم پیچیدگی متن پایینتر و نااطمینانی مدل پایدارتر را در همه مراحل اصلاح نشان دادند. با توجه به نتایج امیدوارکننده و کمبود مدلها و مطالعات مشابه، پژوهشگران اعلام کردند که «برنامه دارند کد و نقاط ذخیره مدلها را منتشر کنند تا امکان بازتولید نتایج و تحقیقات بیشتر فراهم شود.»

برای علاقهمندان به جزئیات فنی، مقاله کامل اپل در arXiv منتشر شده است. این مقاله نمونههای متعددی از عملکرد مدل زبانی جدید اپل را ارائه میدهد، از جمله نمودارهایی که نشان میدهند هر کلمه در کدام مرحله، آخرین بار اصلاح شده است.