پساز پیشگامی انویدیا، حالا AMD و کوالکام با هدف رفع گلوگاههای حافظه در سیستمهای هوش مصنوعی، به استفاده از استاندارد SOCAMM روی آوردهاند.

به گزارش سرویس سختافزار تکناک، AMD و کوالکام درحال بررسی ادغام SOCAMM در محصولات هوش مصنوعی خود هستند؛ چراکه با گسترش کاربردهای هوش مصنوعی عاملمحور، حافظه به یکی از گلوگاههای اصلی در سیستمهای فعلی تبدیل شده است. حافظه SOCAMM در ابتدا بهصورت اختصاصی برای انویدیا در نظر گرفته شده بود و حالا توجه رقبا را نیز به خود جلب کرده است.

مرتبط: متا برای ارتقای سیستمهای هوش مصنوعی با آرم همکاری میکند

SOCAMM یکی از استانداردهای حافظه است که در ابتدا بهعنوان راهکاری متناسب با نیازهای انویدیا معرفی شد و تیم سبز از نخستین پذیرندگان آن بوده است. برای کسانی که با این فناوری آشنا نیستند، SOCAMM برپایه حافظه LPDDR DRAM ساخته شده است؛ حافظهای که بهطور سنتی در دستگاههای موبایل و کممصرف استفاده میشود.

مرتبط: HP بزرگترین مجموعه کامپیوترهای هوش مصنوعی

بااینحال، برخلاف راهکارهایی مانند HBM و LPDDR5X، حافظه SOCAMM ارتقاپذیر است. این ماژولها به برد اصلی لحیم نمیشوند و گفته میشود که گزینهای مناسب برای کار در کنار HBM هستند تا وظایف محدودشده بهواسطه حافظه را مدیریت کنند.

براساس گزارشی از Hankyung، انویدیا و کوالکام و AMD درحال بررسی استفاده از ماژولهای SOCAMM در رکهای هوش مصنوعی آینده خود هستند. در گزارشی مرتبط نیز آمده است که انویدیا قصد دارد امسال تا ۸۰۰ هزار واحد از ماژولهای SOCAMM را در محصولات هوش مصنوعی خود به کار بگیرد.

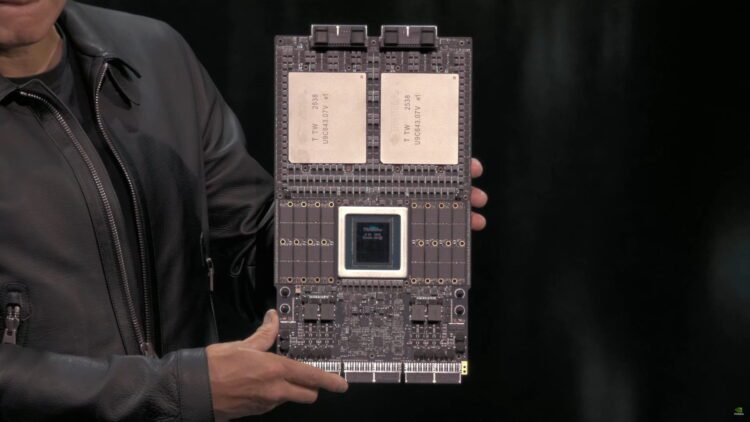

ادعا میشود که AMD و کوالکام درحال بررسی رویکردی متفاوت از انویدیا هستند. این رویکرد شامل چیدمان ماژولی مربعیشکل با دو تراشه DRAM در دو ردیف مجزا است. هدف از این طراحی، امکان کنترل توان مستقیم روی خود ماژول ازطریق PMIC است که به تنظیم مؤثرتر توان کمک میکند و باعث میشود تا SOCAMM بدون مشکل در سرعتهای بسیار زیاد کار کند. با انتقال PMIC به خود ماژول، AMD و کوالکام میتوانند پیچیدگی تولید مادربرد را کاهش دهند؛ چراکه دیگر به مدارهای تأمین توان جداگانه روی برد نیازی نخواهد بود.

مرتبط: جعبه ابزار GPU هوش مصنوعی هواوی متنباز شد

به نوشته Wccftech، با گسترش پذیرش SOCAMM، میزان استفاده از DRAM برای این نوع حافظه نیز افزایش خواهد یافت. با توجه به هوش مصنوعی عاملمحور، وجود فضای ذخیرهسازی کوتاهمدت در کنار HBM به ضرورت تبدیل شده و SOCAMM این امکان را فراهم میکند که هر پردازنده به چندین ترابایت حافظه دسترسی داشته باشد.

همین موضوع به عاملهای هوش مصنوعی اجازه میدهد تا میلیونها توکن را بهصورت فعال در حافظه خود نگه دارند. هرچند توان عملیاتی SOCAMM در مقایسه با HBM کمتر است، همچنان گزینهای کاربردی و کممصرف به شمار میرود.

درحالحاضر، انویدیا قصد دارد SOCAMM 2 را همراه با کلاسترهای هوش مصنوعی Vera Rubin عرضه کند و با توجه به اینکه AMD و کوالکام نیز درحال بررسی این راهکار هستند، میتوان انتظار داشت این نوع حافظه بهزودی در کلاسترهای هوش مصنوعی نسل بعدی آنها نیز استفاده شود.