فهرست مطالب

یک مطالعه جدید نشان داده است که چتباتهای هوش مصنوعی همچنان قابل اعتماد نیستند، اما اپل با رویکرد خود در این حوزه تصمیم درستی گرفته است.

به گزارش تکناک، این تحقیق نشان میدهد که مدلهای هوش مصنوعی در برخی موارد پاسخهای نادرست یا گمراهکننده ارائه میدهند، درحالیکه اپل با تمرکز بر کنترل کیفیت و یکپارچگی دادهها، استراتژی بهتری را اتخاذ کرده است.

یکی از مهمترین توصیههایی که درباره چتباتهای هوش مصنوعی باید همواره در نظر داشت، این است که «برای یافتن اطلاعات دقیق به آنها تکیه نکنید این ابزارها کاملاً غیرقابل اعتماد هستند.»

نتایج یک پژوهش جدید بار دیگر این مسئله را تأیید کرده است. بااینحال، همین مطالعه نشان میدهد که اپل با انتخاب ChatGPT شرکت OpenAI برای پاسخگویی به پرسشهایی که سیری قادر به پاسخ دادن به آنها نیست، تصمیم درستی گرفته است.

01

از 07چرا چتباتهای هوش مصنوعی جایگزین مناسبی برای جستجوی وب نیستند؟

مدلهای زبانی بزرگ مانند ChatGPT، Gemini و Grok دو مشکل اساسی دارند:

- این مدلها اغلب پاسخهای نادرستی ارائه میدهند.

- معمولاً با اطمینان کامل، اطلاعات نادرست خود را بهعنوان واقعیت مطرح میکنند.

به نقل از 9to5mac، بررسیای که Columbia Journalism Review به آن استناد کرده است، نشان میدهد حتی زمانی که چتباتها با یک نقلقول دقیق از یک مقاله خبری تغذیه شده و از آنها خواسته میشود جزئیات بیشتری ارائه دهند، بیشتر پاسخهای آنها اشتباه است.

02

از 07ارزیابی عملکرد هشت چتبات در جستجوی اطلاعات واقعی

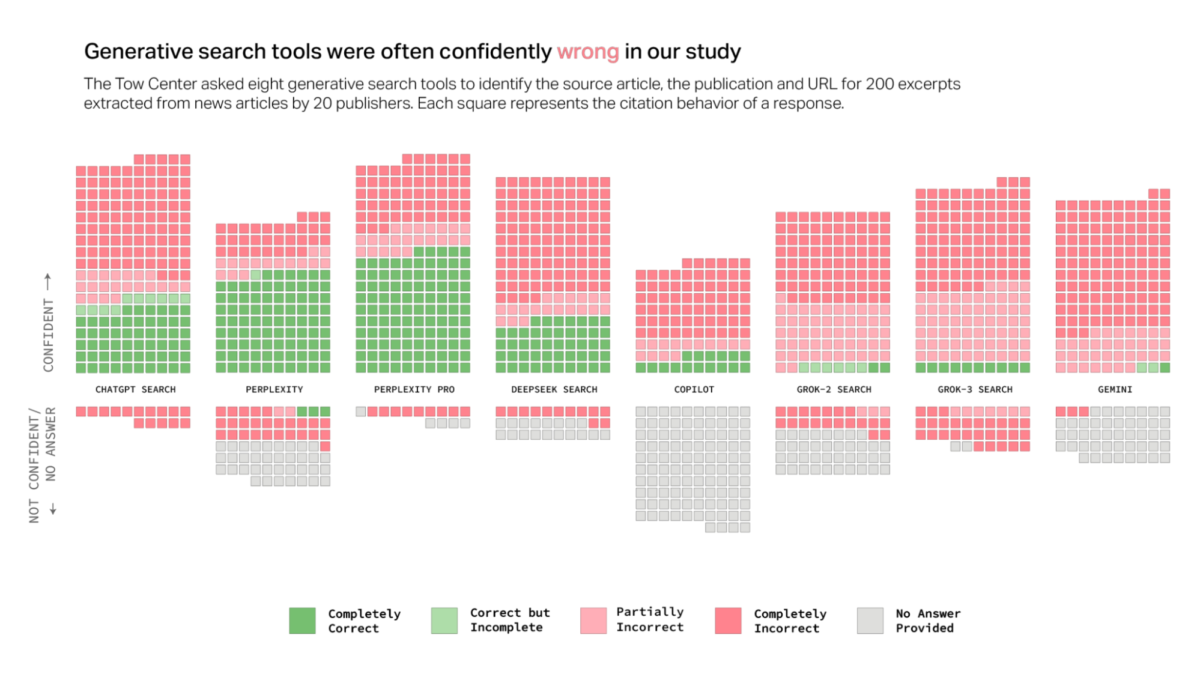

پژوهشگران Tow Center for Digital Journalism عملکرد هشت چتبات هوش مصنوعی را که مدعی توانایی جستجوی زنده در وب هستند، مورد بررسی قرار دادند. این چتباتها عبارتاند از:

- ChatGPT

- Perplexity

- Perplexity Pro

- DeepSeek

- Copilot (مایکروسافت)

- Grok-2

- Grok-3

- Gemini

03

از 07آزمون سادهای که چتباتها در آن شکست خوردند

محققان از چتباتها خواستند تا بر اساس یک نقلقول مشخص، مقالهای را بهصورت آنلاین پیدا کرده و علاوه بر لینک، عنوان مقاله، نام ناشر و تاریخ انتشار را ارائه دهند.

برای اطمینان از امکان انجام این کار، آنها نقلقولهایی را انتخاب کردند که منبع اصلی آنها در میان سه نتیجه نخست جستجوی گوگل قرار داشت.

چتباتها بر اساس میزان دقت پاسخهایشان در پنج دسته قرار گرفتند:

- کاملاً درست

- درست اما با اطلاعات ناقص

- تا حدودی نادرست

- کاملاً نادرست

- ناتوان در ارائه پاسخ

همچنین بررسی شد که این ابزارها پاسخهای خود را با چه میزان اطمینان ارائه میدهند؛ آیا آنها نتایج را بهعنوان حقیقت مسلم نمایش میدهند یا از عباراتی مانند «به نظر میرسد» استفاده میکنند و به محدودیتهای خود اذعان دارند؟

04

از 07نتایج نگرانکننده: چتباتها کمتر از ۴۰ درصد مواقع پاسخ درستی ارائه دادند

میانگین دقت پاسخهای این چتباتها کمتر از ۴۰ درصد بود. در این میان، Perplexity با نرخ موفقیت ۶۳٪ بهترین عملکرد را داشت، درحالیکه Grok-3 متعلق به ایکس (توییتر سابق) با تنها ۶٪، بدترین نتیجه را ثبت کرد.

05

از 07دیگر یافتههای کلیدی پژوهش

- چتباتها معمولاً بهجای رد پرسشهایی که قادر به پاسخگویی به آنها نیستند، اطلاعات نادرست یا حدسی ارائه میدهند.

- چتباتهای پولی با اطمینان بیشتری اطلاعات نادرست منتشر میکنند.

- برخی از چتباتها پروتکل Robot Exclusion را که برای جلوگیری از خزیدن رباتها در سایتها طراحی شده، نادیده میگیرند.

- ابزارهای جستجوی مولد در برخی موارد لینکهای جعلی ساخته و نسخههای کپیشده مقالات را بهعنوان منبع ارائه میدهند.

- قراردادهای رسمی میان شرکتهای خبری و پلتفرمهای هوش مصنوعی، تضمینی برای صحت استنادها در پاسخهای چتباتها نیست.

06

از 07چرا اپل تصمیم درستی گرفت؟

با وجود عملکرد برتر Perplexity، شواهدی نشان میدهد که این چتبات ممکن است از روشهای غیرمجاز استفاده کرده باشد. ناشران میتوانند با استفاده از فایل robots.txt مانع از دسترسی چتباتها به محتوای سایت خود شوند. بهعنوان مثال، National Geographic چنین محدودیتی اعمال کرده است، اما بااینحال، Perplexity توانسته تمام ۱۰ نقلقول مورد بررسی را از این سایت پیدا کند، درحالیکه مقالات آن پشت دیوار پرداخت بوده و هیچ توافقنامهای میان طرفین وجود نداشته است.

در میان سایر چتباتها، ChatGPT بالاترین دقت را داشت یا بهتر است بگوییم، کمترین میزان خطا را داشت.

07

از 07نتیجهگیری: چتباتهای هوش مصنوعی برای جستجوی اطلاعات واقعی قابل اعتماد نیستند

مطالعه انجامشده بار دیگر مسئلهای را که پیشتر نیز روشن بود، تأیید میکند: چتباتهای هوش مصنوعی ابزاری مفید برای ایدهپردازی و الهام گرفتن هستند، اما نباید برای دریافت پاسخهای دقیق و واقعی به آنها اعتماد کرد.