فهرست مطالب

با گسترش کاربرد مدلهای زبانی بزرگ هوش مصنوعی مانند ChatGPT، بسیاری تصور میکنند که این ابزارهای پیشرفته قابلیت «فکر کردن» و «درک» دارند اما عملکرد این فناوریها بر حدس زدن الگوهای زبانی بر اساس دادههای پیشین استوار است.

به گزارش تکناک، مدلهای زبانی بزرگ یا LLMها، سامانههایی هستند که با استفاده از میلیاردها توکن برگرفته از کتابها، وبسایتها و گفتوگوهای انسانی، آموزش میبینند تا بتوانند با بالاترین احتمال، کلمه یا مفهوم بعدی را پیشبینی کنند. این پیشبینی نه از درک و استدلال، بلکه صرفاً از تحلیل آماری الگوهای زبانی ناشی میشود. این روش اگرچه قدرتمند است، اما پیامدهایی نگرانکنندهای نیز به همراه دارد.

در این ساختار، زبان به اجزای کوچکی به نام توکن تقسیم میشود و مدل با بهرهگیری از وزنهای تنظیمپذیر در شبکه عصبی خود، رابطه میان توکنها را میآموزد. سپس با استفاده از تابع خطا، میزان اشتباه خود را ارزیابی میکند و به اصلاح عملکرد میپردازد. در نهایت، مدل به سامانهای قدرتمند در تشخیص الگوهای زبانی تبدیل میشود، اما بدون آنکه دانش واقعی از مفاهیم داشته باشد.

01

از 03خطر توهم، سوگیری و عقبماندگی در هوش مصنوعی

کارکرد مبتنی بر حدس، زمینهساز بروز خطاهایی جدی در عملکرد این مدلها شده است. یکی از شایعترین چالشها، پدیده «توهم» یا Hallucination است؛ حالتی که در آن مدل با اطمینان کامل اطلاعات جعلی تولید میکند، از جمله ساخت مقالههای علمی ساختگی یا ارجاع به منابعی که وجود خارجی ندارند. این خطا در حوزههایی مانند: پزشکی، حقوق یا آموزش میتواند پیامدهای جبرانناپذیری داشته باشد.

از سوی دیگر، سوگیری یا Bias نیز مشکلی اساسی در مدلهای زبانی به حساب میآید. این مدلها به واسطه آموزش بر اساس محتوای اینترنتی، به صورت ناخواسته، کلیشههای فرهنگی، تبعیضهای جنسیتی و تمایلات سیاسی را جذب میکنند. در نتیجه، ممکن است خروجیهایی ارائه دهند که یکسویه یا غیراخلاقی باشند.

همچنین عقبماندگی مدل یا Model Drift از دیگر مشکلات رایج است. مدلهایی که اطلاعات آنها به زمان خاصی محدود میشود، در برابر تحولات بعدی ناتوان از تحلیل و واکنش خواهند بود. این مسئله در مواردی مثل پیشبینی روندهای اقتصادی یا اجتماعی، دقت و قابلیت اتکای مدل را به شدت کاهش میدهد.

02

از 03چرا اصلاح این مدلها دشوار است؟

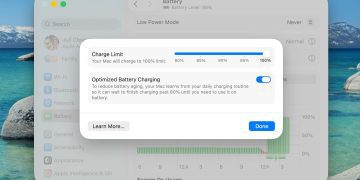

با وجود شناخت این چالشها، بهروزرسانی و اصلاح مدلهای زبانی فرایندی پیچیده، پرهزینه و زمانبر است. آموزش مجدد مدلهایی مثل GPT-4 مستلزم زیرساختهای عظیم محاسباتی، تجهیزات پیشرفته و سرمایهگذاریهای کلان است.

همچنین به دلیل ساختار پیچیده و غیرشفاف (به اصطلاح جعبهسیاه) این مدلهای هوش مصنوعی، حتی مهندسان سازنده نیز نمیتوانند منشأ دقیق یک خطای خاص را شناسایی کنند. به همین علت، اصلاح رفتار مدلها با دشواریهای زیادی مواجه است.

ابزاری به نام یادگیری تقویتی با بازخورد انسانی (RLHF) به عنوان یکی از روشهای کنترل و هدایت خروجیها استفاده میشود. در این روش، بازبینهای انسانی، خروجیهای مدل را ارزیابی میکنند و به آن بازخورد میدهند. اما این روش نیز به دلیل مقیاسپذیری محدود و هزینههای بالا، تنها در موارد کلی و رایج کاربرد دارد.

03

از 03تلاشها برای بهبود ایمنی و شفافیت مدلها

پژوهشگران و شرکتهای فناوری با درک ابعاد گسترده خطرات احتمالی، تلاشهایی را برای افزایش ایمنی، شفافیت و هماهنگی مدلها با ارزشهای انسانی آغاز کردهاند.

- شرکت OpenAI پروژهای به نام Superalignment را راهاندازی کرده است و هدف آن طراحی مدلهایی است که بدون نیاز به نظارت مداوم انسانی، بتوانند تصمیمهایی منطبق با اهداف و ارزشهای بشر اتخاذ کنند.

- شرکت Anthropic نیز روش جدیدی به نام Constitutional AI توسعه داده است، که بهجای تکیه بر بازخورد انسان، از مجموعه اصول از پیش تعیینشده برای هدایت رفتار مدل استفاده میکند.

- در سطح قانونگذاری، قانون هوش مصنوعی اتحادیه اروپا (EU AI Act) به عنوان یکی از نخستین چارچوبهای جامع جهانی برای ایمنی و مسئولیتپذیری در حوزه هوش مصنوعی تصویب شده است.

- در محافل دانشگاهی، مراکزی مانند Stanford CRFM، MIT CSAIL و Oxford FHI روی شفافسازی عملکرد مدلها، کاهش سوگیری و تعریف استانداردهای ارزیابی دقیقتر تمرکز کردهاند.

اگرچه هنوز هیچ راهکار نهایی برای چالشهای مدلهای زبانی بزرگ ارائه نشده، اما اجماع فزایندهای در میان پژوهشگران، قانونگذاران و فعالان صنعت شکل گرفته است، که همراستا کردن هوش مصنوعی با ارزشهای انسانی باید بخش اصلی فرایند توسعه آن باشد.

هدف نهایی، فقط عملکرد بهتر نیست، بلکه عملکرد ایمن، شفاف و قابلاعتماد در راستای نیازهای جوامع انسانی است.

بسیار هم حدس اشتباه می زنند این هوش مصنوعی ها، از خود درآوردی حرف می زنند اگر حتی چیزی ر ا نمیدانند ، نمی گویند ،نمی دانند یک دادستانی سر هم می کنند ،یک بار در مورد یک هنرپیشه سؤال کردم یک مزخرفات بافت که نمی دانم از کجا پیدا کرده بود هرچه در اینترنت گشتم پیدا نکردم ، فقط هوش مصنوعی کارش داستان سرایی ،و چرند بافی است ،بقول خودشان مدل زبانی هستند . اکثراً هم نه به داده های جدید دسترسی دارند و نه هوشی دارند،خلاصه یک جستجوی ساده در اینترنت بهتر است