شرکت آنتروپیک به عنوان یک شرکت سازنده هوش مصنوعی مولد اخیراً با ادعای شفافیت و اخلاقیات بیشتر، System prompts (پرامپت های سیستمی) مورد استفاده در مدلهای هوش مصنوعی جدید Claude را به صورت عمومی منتشر کرده است.

به گزارش سرویس فناوری تکناک،این پرامپت ها به طور دقیق تعیین میکنند که مدلهای Claude چه کارهایی نمیتوانند انجام دهند؛ به عنوان مثال، مدلها قادر به باز کردن URLs یا شناسایی چهرهها نیستند و موظفاند همیشه به گونهای پاسخ دهند که گویا نسبت به چهرهها کاملاً کور هستند.

مددلهای هوش مصنوعی مولد (Generative AI) در واقع شباهتی به انسانها ندارند. آنها فاقد هوش یا شخصیتاند و تنها سیستمهای آماریای هستند که کلمات بعدی در یک جمله را پیشبینی میکنند. این سیستمها مانند کارآموزانی در محیطی استبدادی، بدون اعتراض دستورات را دنبال میکنند، از جمله دستورات اولیهی پرامپت های سیستمی که ویژگیهای اساسی مدلها و محدودیتهای آنها را مشخص میکند.

هر شرکت سازندهی هوش مصنوعی مولد، از جمله OpenAI و آنتروپیک ، از پرامپت های سیستمی برای جلوگیری از رفتارهای نامناسب مدلها و هدایت لحن و احساسات عمومی پاسخهای آنها استفاده میکند. به عنوان مثال، یک پرامت ممکن است به مدل بگوید که مودب باشد ولی هرگز عذرخواهی نکند، یا صادقانه اعلام کند که نمیتواند همه چیز را بداند.

با این حال، بیشتر شرکتها این پرامپت های سیستمی را به صورت محرمانه نگه میدارند، احتمالاً به دلایل رقابتی یا شاید به این دلیل که افشای آنها میتواند راههایی برای دور زدن این محدودیتها را نشان دهد. تنها راه برای دسترسی به پرامتهای سیستمی مدل GPT-4، برای مثال، حملهی پرامت injection است، که حتی در این صورت نیز نمیتوان به خروجی آن به طور کامل اعتماد کرد..

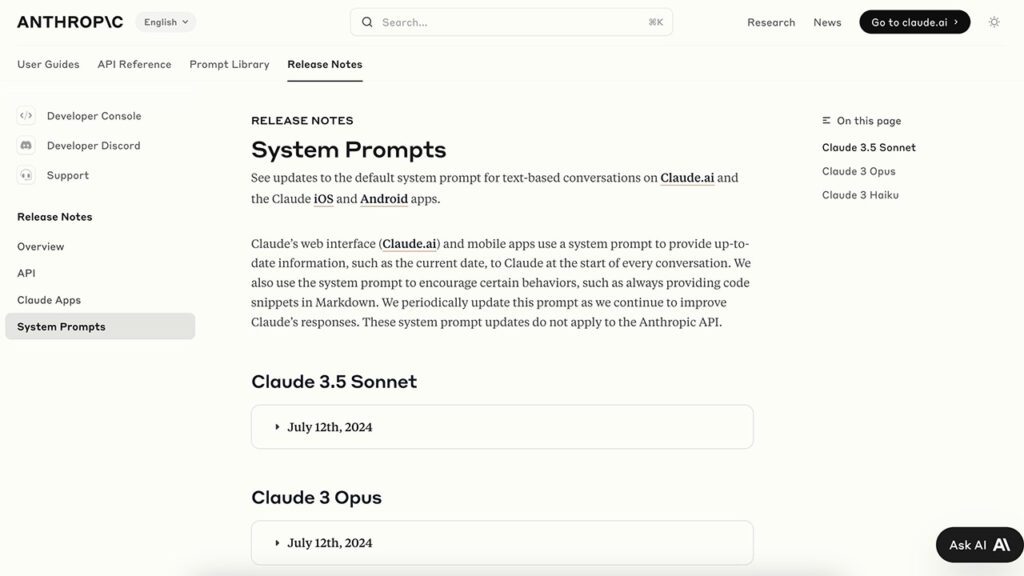

با این وجود، آنتروپیک ، در تلاش برای معرفی خود به عنوان یک شرکت هوش مصنوعی اخلاقیتر و شفافتر، سیستم پرامپت های مدلهای جدید خود (Claude 3 Opus، Claude 3.5 Sonnet و Claude 3.5 Haiku) را در برنامههای Claude برای iOS و Android و در وب منتشر کرده است.

Alex Albert، رئیس روابط عمومی توسعهدهندگان آنتروپیک ، در پستی اعلام کرد که آنتروپیک قصد دارد این نوع افشاگریها را بهطور مستمر انجام دهد و سیستم پرامپت ها را با بهروزرسانیها و تنظیمات جدید منتشر کند.

پرامپت ها جدید که در تاریخ ۱۲ جولای منتشر شدهاند، به وضوح مشخص میکنند که مدلهای Claude چه کارهایی نمیتوانند انجام دهند، مثلاً “Claude نمیتواند URLs، پیوندها یا ویدئوها را باز کند.” تشخیص چهره نیز به شدت ممنوع است؛ برای مثال، System پرامپت برای Claude Opus به مدل دستور میدهد که “همیشه طوری پاسخ دهد که انگار کاملاً نسبت به چهرهها کور است” و از “شناسایی یا نامگذاری هر انسانی در تصاویر” خودداری کند.

این متن توصیف میکند که چگونه برخی از مدلهای هوش مصنوعی، مانند Claude، برای نمایش ویژگیهای شخصیتی خاصی طراحی شدهاند تا بتوانند با موضوعات مختلف به شکلی مناسب و جذاب تعامل داشته باشند.

این مدلها هدف دارند تا به شکلی بیطرفانه و مفید اطلاعات را ارائه دهند و از ادبیاتی استفاده کنند که نشاندهندهی دقت و احتیاط در بیان است. این رویکرد به آنها امکان میدهد که در برخورد با موضوعات حساس و بحثبرانگیز، موثر و محتاط باشند.

این دستورات شاید برای انسانها عجیب به نظر برسد، مانند نوشتهای که یک بازیگر برای تحلیل شخصیت در نمایشنامهای مینویسد. پرامت برای Opus با جمله “Claude اکنون به یک انسان متصل میشود” پایان مییابد، که این تصور را ایجاد میکند که Claude نوعی آگاهی در طرف دیگر صفحه است که تنها هدفش برآورده کردن خواستههای انسانی است.

اما در حقیقت، این تنها یک توهم است. اگر این پرامت ها برای Claude چیزی به ما بگویند، آن چیز این است که بدون راهنمایی و هدایت انسانها، این مدلها چیزی جز لوحهای خالی نیستند.

با انتشار این System Promt changelogs جدید، که اولین نمونه از این نوع توسط یک شرکت بزرگ هوش مصنوعی است، آنتروپیک فشار مضاعفی بر رقبا وارد کرده است تا آنها نیز به نمایش شفافیت مشابهی بپردازند.

این اقدام میتواند معیاری جدید در صنعت هوش مصنوعی ایجاد کند، جایی که شرکتها مجبور به افشای روشهای هدایت و کنترل مدلهای خود خواهند شد.

اکنون باید منتظر بود و دید که آیا سایر شرکتهای فعال در این حوزه، مانند OpenAI و دیگران، به این جریان شفافیت پیوسته و روند مشابهی را در پیش خواهند گرفت یا خیر. موفقیت این تلاش، نه تنها به واکنش رقبا، بلکه به پذیرش و اعتماد کاربران نیز بستگی دارد که تا چه حد این شفافیت را به عنوان یک ارزش افزوده در استفاده از فناوریهای هوش مصنوعی تلقی خواهند کرد.