فهرست مطالب

مدل LLM منبع باز اپل در معیارهای مختلف عملکرد، از Phi-3، جدیدترین مدل LLM منبعباز مایکروسافت، بسیار عقب مانده است.

بهگزارش تکناک، مایکروسافت در ماه آوریل مدلهای زبان کوچک (SLM) از خانوادهی Phi-3 را معرفی کرد. مدلهای Phi-3 در معیارهای مهم عملکرد با اختلاف زیاد مدلهایی با اندازهی مشابه و حتی بزرگتر را پشتسر گذاشتند.

درواقع، کوچکترین مدل، یعنی Phi-3-mini، از مدلهایی با دو برابر اندازهی خود بهتر عمل میکند؛ درحالیکه Phi-3-small و Phi-3-medium از مدلهای بزرگتری مانند GPT-3.5 توربو عملکرد بهتری از خود نشان میدهند.

نئووین مینویسد که تیم DataComp for Language Models (DCLM) اپل بهتازگی مدل LLM منبع باز جدیدی به نام DCLM-7B را با مجوز نمونه کد اپل منتشر کرده است. این DCLM-7B جدید مدلی با ۷ میلیارد پارامتر است که با مجموعه داده DCLM-Baseline آموزش داده شده است.

اپل برای اینکه این مدل را برای کارهای رایج مختلف، ازجمله ریاضیات و کدنویسی، بهطور گسترده مفید کند، دادههای DCLM-Baseline 3.8Tخود را با دادههای StarCoder و ProofPile2 ترکیب کرد تا به مجموعه دادهی 4.1T توکنی برسد.

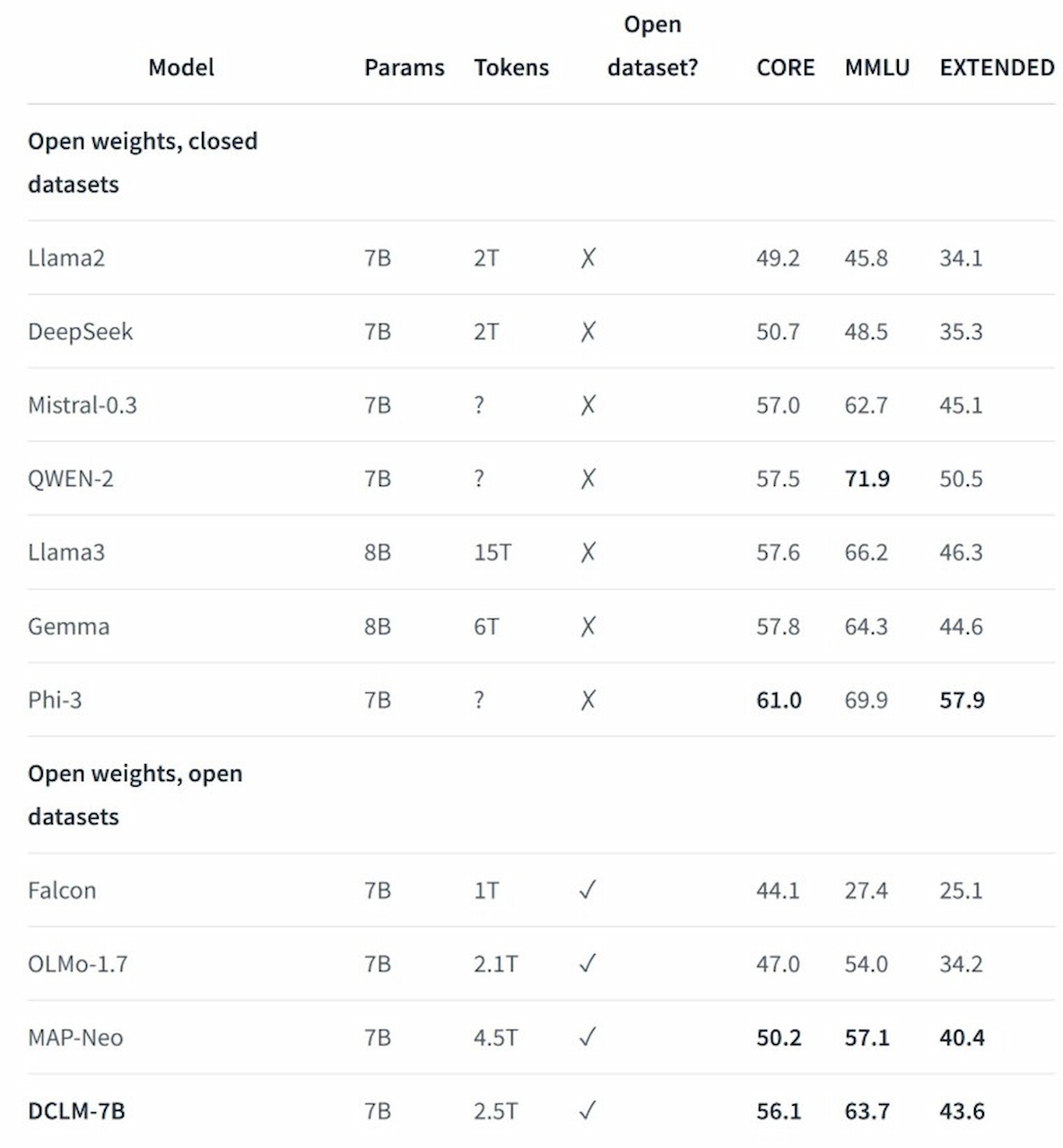

هدف اپل از ایجاد این مدل، برجستهکردن اثربخشی تکنیکهای مدیریت سیستماتیک داده برای بهبود عملکرد مدلهای زبان است. همچنین، اپل نتایج ارزیابی DCLM-7B را بههمراه مقایسههایی با سایر مدلهای مشابه ازنظر اندازه منتشر کرده که میتوانید درادامه آن را مشاهده کنید.

01

از 01تحلیل نتایج مدلهای زبان کوچک براساس معیارهای سنجش

همانطورکه در جدول مقایسهی معیارهای بالا مشاهده میکنید، Phi-3 مایکروسافت در هر سه دسته، ازجمله MMLU، از DCLM-7B اپل عملکرد بهتری دارد. نکتهی جالب دیگر این است که اپل مدل خاص Phi-3 استفادهشده برای این مقایسه را ذکر نکرده است. با استناد به امتیاز MMLU، میتوانیم استنتاج کنیم که این امتیاز متعلق به Phi-3 mini، مدلی ۳/۸ میلیارد پارامتری است.

مشخص نیست که چرا اپل مدل ۷ میلیارد پارامتری خود را با مدلی ۳/۸ میلیارد پارامتری از مایکروسافت مقایسه کرده است. در حالت ایدئال، آنها باید آن را با Phi-3 Small مقایسه میکردند که مدلی ۷ میلیارد پارامتری با امتیاز MMLU درخورتوجه ۷۵/۶ است.

رقابت برای توسعهی مدلهای زبان کوچک با عملکرد بالا در حال سرعتگرفتن است. درحالیکه Phi-3 مایکروسافت سطح بالایی را تعیین کرده است، DCLM-7B اپل قابلیتهای مدیریت دادهی هدفمند را برای بهبود مدل نشان میدهد. هنوز مشخص نیست که این مدلهای زبان کوچک چگونه در آینده تکامل پیدا میکنند و بر چشمانداز گستردهتر هوش مصنوعی تأثیر میگذارند.