شرکت OpenAI بالاخره قابلیت درک ویدیویی بلادرنگ را برای ChatGPT که حدود هفت ماه پیش در یک دمو معرفی کرده بود، منتشر کرد.

به گزارش تکناک و به نقل از سایت TechCrunch این ویژگی جدید که بهعنوان بخشی از حالت صدای پیشرفته به کاربران ارائه میشود، به آنها امکان میدهد تا از طریق تلفنهای همراه خود به ChatGPT دستور دهند تا به اشیاء مختلف نگاه کرده و تقریباً در بلادرنگ پاسخ دهد.

در یک پخش زنده که روز پنجشنبه برگزار شد، OpenAI اعلام کرد که ویژگی جدید با نام “حالت صدای پیشرفته با بینایی” (Voice Mode with vision )به کاربران اجازه میدهد تا با استفاده از اپلیکیشن ChatGPT و تنها با گرفتن گوشی خود به سمت اشیاء مختلف، از این دستیار هوش مصنوعی بازخورد فوری دریافت کنند.

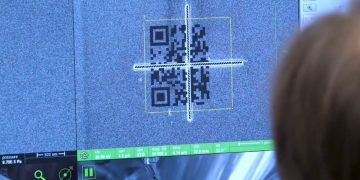

این قابلیت علاوه بر شناسایی اشیاء، میتواند اطلاعات نمایش دادهشده بر روی صفحه نمایش دستگاهها را از طریق به اشتراکگذاری صفحه تجزیه و تحلیل کند. بهعنوان مثال، ChatGPT میتواند منوهای تنظیمات را توضیح دهد یا پیشنهاداتی برای حل مسائل ریاضی ارائه دهد.

برای استفاده از این قابلیت، کاربران باید روی آیکون صدا در کنار نوار گفتگوی ChatGPT کلیک کرده و سپس آیکون ویدیو را در پایین سمت چپ لمس کنند. این عمل ویدیو را آغاز میکند و کاربران میتوانند برای به اشتراکگذاری صفحه، منوی سهنقطهای را انتخاب کرده و گزینه “Share Screen” را بزنند.

با توجه به اعلام OpenAI، ویژگی حالت صدای پیشرفته با بینایی از روز پنجشنبه آغاز شده و در طول هفته آینده برای کاربران مختلف منتشر خواهد شد. با این حال، تمام کاربران به این قابلیت دسترسی نخواهند داشت. مشترکان ChatGPT Enterprise و Edu باید تا ماه ژانویه منتظر بمانند و هنوز هیچ زمانبندی برای کاربران ChatGPT در اتحادیه اروپا، سوئیس، ایسلند، نروژ و لیختناشتاین ارائه نشده است.

در یک دمو اخیر که در برنامه “60 Minutes” شبکه CNN پخش شد، گرگ بروکمن، رئیس OpenAI، از حالت صدای پیشرفته با بینایی خواست که مهارتهای آناتومی اندرسون کوپر، مجری این برنامه، را آزمایش کند. در این دمو، زمانی که کوپر اعضای بدن انسان را روی تخته سیاه میکشید، ChatGPT توانست آنچه را که میکشید درک کند و بازخورد دقیقی ارائه دهد. با این حال، در بخشی دیگر از این دمو، این ویژگی در حل یک مسئله هندسی دچار خطای خیالی شد.

حالت صدای پیشرفته با بینایی پس از چندین بار تأخیر، بالاخره در این زمان برای برخی از کاربران منتشر شده است. OpenAI دلیل این تأخیر را اعلام این ویژگی پیش از آماده شدن آن برای تولید میداند. در ماه آوریل، این شرکت وعده داده بود که این قابلیت ظرف چند هفته به کاربران ارائه خواهد شد، اما در ماههای بعدی اعلام شد که زمان بیشتری برای تکمیل آن نیاز است.

این قابلیت جدید در کنار حالت صدای پیشرفته، در تلاش برای گسترش دسترسی به این ویژگی برای کاربران در اتحادیه اروپا و پلتفرمهای مختلف منتشر شده است. از سوی دیگر، رقبای OpenAI مانند گوگل و متا نیز در حال توسعه قابلیتهای مشابهی برای محصولات چتبات خود هستند.

گوگل به تازگی پروژهای تحت عنوان “Project Astra” را که شامل ویژگیهای گفتگویی با تحلیل ویدیویی بلادرنگ است، برای گروهی از “آزمونگران معتبر” روی سیستمعامل اندروید عرضه کرده است.