اینتل اعلام کرد که شتابدهندههای هوش مصنوعی Gaudi 2 این شرکت جایگزین مناسبی برای تراشههای انویدیا هستند.

بهگزارش تکناک، Hugging Face شرکت فرانسویآمریکایی است که درزمینه توسعه ابزارهای رایانهای برای ساخت برنامههای کاربردی با استفاده از یادگیری ماشین فعالیت میکند. Hugging Face توانایی تولید متن را با استفاده از مدلهای Llama 2 با پارامترهای حداکثر ۷۰ میلیارد نشان داده است. اینتل با گسترش اکوسیستم نرمافزار هوش مصنوعی خود، در حال هدف قراردادن محبوبترین کارهای هوش مصنوعی است که شامل مدلهای زبان بزرگ (LLM) میشود.

این کار با استفاده از Habana Optimum که بهعنوان رابط کتابخانههای ترانسفورماتور و پخشکننده عمل میکند و پردازندههای Habana Gaudi اینتل مانند Gaudi 2 امکانپذیر شده است. اینتل پیشازاین قابلیتها و عملکرد هوش مصنوعی پردازندههای Gaudi 2 خود را دربرابر پردازندههای گرافیکی A100 انویدیا، یکی از گزینههای محبوب در بازار، بهنمایش گذاشته است؛ اما Gaudi 2 در ارائه عملکرد سریعتر با TCO رقابتی، عملکرد تحسینبرانگیزی دارد.

در آخرین دموی، Hugging Face با استفاده از همان خط لوله Habana Optimum و شتابدهنده هوش مصنوعی Gaudi 2 اینتل، سهولت تولید متن با Llama 2 (۷ میلیارد، ۱۳ میلیارد، ۷۰ میلیارد) را نشان میدهد. نتیجه نهایی نشان میدهد که تراشه Gaudi 2 نهتنها ورودیهای تکی یا چندگانه را پذیرفت؛ بلکه استفاده از آن بسیار آسان بود و میتوانست افزونههای سفارشی را درون اسکریپتها مدیریت کند. Hugging Face درباره این موضوع توضیح میدهد:

با انقلاب هوش مصنوعی مولد (GenAI)، تولید متن با مدلهای ترانسفورماتور متنباز مانند Llama 2 به موضوع داغ محافل تبدیل شده است. علاقهمندان به هوش مصنوعی و توسعهدهندگان بهدنبال استفاده از قابلیتهای تولید متن چنین مدلهایی برای استفادهها و برنامههای کاربردی خود هستند. این مقاله نشان میدهد که تولید متن با خانواده مدلهای Llama 2 (۷ میلیارد، ۱۳ میلیارد و ۷۰ میلیارد) با استفاده از Optimum Habana و کلاس خط لوله سفارشی چقدر آسان است. شما میتوانید مدلها را فقط با چند خط کد اجرا کنید!

این کلاس خط لوله سفارشی برای ارائه انعطافپذیری و سهولت استفاده عالی طراحی شده است. علاوهبراین، سطح چشمگیری از انتزاع را ارائه میدهد و تولید متن انتهابهانتها را انجام میدهد که شامل پیشپردازش و پسپردازش میشود. روشهای مختلفی برای استفاده از خط لوله وجود دارد. شما میتوانید اسکریپت run_pipeline.py را از مخزن Habana Optimum اجرا و کلاس خط لوله را به اسکریپتهای پایتون خود اضافه یا کلاسهای LangChain را با آن راهاندازی کنید.

ما خط لوله تولید متن سفارشی را روی شتابدهنده هوش مصنوعی Gaudi 2 اینتل ارائه کردیم که ورودیهای تکی یا چندگانه را بهعنوان ورودی میپذیرد. این خط لوله ازنظر اندازه مدل و پارامترهای مؤثر بر کیفیت تولید متن، انعطافپذیری بیشتری ارائه میدهد. علاوهبراین، استفاده از آن در اسکریپتهای شما بسیار آسان و با LangChain سازگار است.

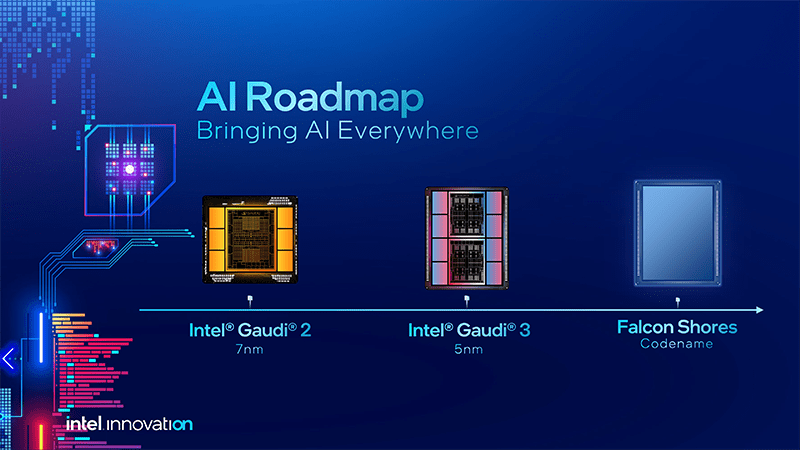

اینتل به شتاببخشیدن به بخش هوش مصنوعی خود در سالهای آینده متعهد است. امسال، این شرکت برنامهریزی کرده است تا سومین نسل از Gaudi را با نام Gaudi 3 معرفی کند که انتظار میرود از گره فرایندی 5 نانومتری استفاده کند و گزارش شده است که از انویدیا H100 با قیمت بسیار ارزانتر سریعتر است.

علاوهبراین، تیم آبی (اینتل) برنامهریزی کرده است تا با پردازنده گرافیکی نسل بعدی فالکن شورز به طراحی کاملاً داخلی منتقل شود. این شرکت تواناییهای هوش مصنوعی مانند رابط کاربری Llama 2 را با PyTorch برای پردازندههای گرافیکی سری Arc A مصرفی خود باز میکند.