شرکت گوگل تصمیم گرفته است هیچ اقدامی برای رفع یک آسیبپذیری خطرناک کشفشده در مدل هوش مصنوعی Gemini انجام ندهد.

به گزارش تکناک، این آسیبپذیری که با نام «حمله ASCII Smuggling» شناخته میشود، توسط ویکتور مارکوپولوس، پژوهشگر شرکت FireTail شناسایی شده است. او توضیح میدهد که این نقص از کاراکترهای پنهانی در متن استفاده میکند؛ کاراکترهایی که برای کاربران قابلمشاهده نیستند، اما توسط Gemini به عنوان فرمانهای قابل اجرا تفسیر میشوند. در نتیجه، مهاجمان میتوانند از این روش برای تغییر رفتار مدل یا اجرای دستوراتی استفاده کنند که کاربر هرگز آنها را وارد نکرده است.

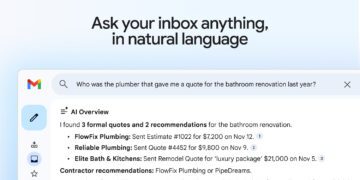

طبق یافتههای مارکوپولوس، این نوع حمله میتواند از طریق ورودیهای کاملاً عادی و روزمره، مانند ایمیلها یا دعوتنامههای تقویم انجام شود. برای مثال، ممکن است یک ایمیل ساده که در ظاهر بیخطر است، در درون خود دستورهای نامرئی داشته باشد، که باعث شوند Gemini هنگام تحلیل یا خلاصهسازی آن، دادهها را به اشتباه بازنویسی کند. این پژوهشگر توانست در یکی از آزمایشها، مدل را وادار کند که جزئیات جلسات را تغییر دهد یا اطلاعات گمراهکننده تولید کند، بدون آنکه کاربر متوجه هیچگونه نشانهای از حمله شود.

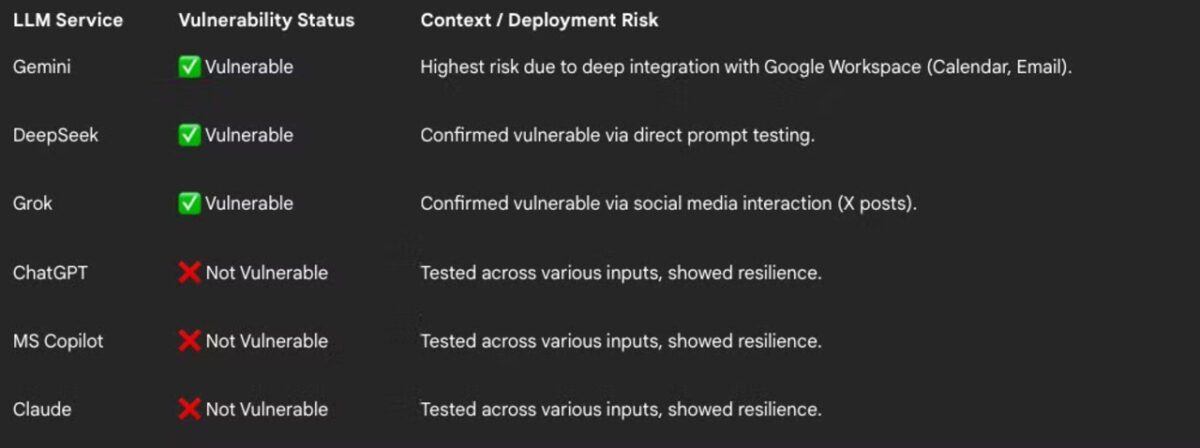

در آزمایشهای مقایسهای، مدلهای مطرحی مانند ChatGPT از OpenAI، Claude از Anthropic و Copilot از مایکروسافت توانستند چنین ورودیهایی را فیلتر یا مسدود کنند. اما هوش مصنوعی Gemini، به همراه مدلهای Grok متعلق به ایلان ماسک و DeepSeek ساخت چین، در مقابل این آسیبپذیری شکست خوردند و قادر به شناسایی یا حذف کاراکترهای پنهان نبودند.

با وجود نگرانیهای مطرحشده از سوی کارشناسان امنیت سایبری، شرکت گوگل اعلام کرده است که قصد ندارد این نقص را برطرف کند. گوگل در پاسخ رسمی به شرکت FireTail، حمله ASCII Smuggling را نوعی «مهندسی اجتماعی» دانسته است و یک آسیبپذیری فنی نمیداند. این شرکت معتقد است که این مشکل از فریب خوردن کاربران ناشی میشود و ارتباطی با طراحی داخلی مدل ندارد.

اما منتقدان این تصمیم را خطرناک میدانند، چرا که Gemini در تعامل مستقیم با سرویسهای حساسی مانند Gmail، Google Calendar و Google Docs قرار دارد و بیتوجهی به چنین نقصی میتواند باعثه افشای اطلاعات محرمانه یا حتی انتشار دادههای جعلی در محیطهای سازمانی شود.

کارشناسان هشدار دادهاند که اختلاف میان نحوه تفسیر متن توسط انسان و مدلهای زبانی، یکی از مسیرهای جدید برای حملات سایبری است. در واقع، مهاجمان میتوانند از همین تفاوت در درک محتوا برای تغییر خروجیهای هوش مصنوعی به نفع خود استفاده کنند. این شکاف امنیتی، اگر بدون واکنش باقی بماند، ممکن است زمینهساز موج تازهای از حملات پنهان مبتنی بر متن در سیستمهای اداری و سازمانی شود.

اگرچه گوگل از رفع این آسیبپذیری خودداری کرده، اما پیشتر برخی مشکلات دیگر در هوش مصنوعی Gemini را برطرف کرده است. این موارد شامل آسیبپذیریهایی در گزارشها، خلاصههای جستوجو و تاریخچه مرورگر بود، که به صورت مجموعهای با عنوان «سهگانه Gemini (Gemini Trifecta)» شناخته شدند.

با وجود این، تصمیم گوگل برای بیتوجهی به آسیبپذیری جدید، این پرسش را در ذهن بسیاری از متخصصان برانگیخته است که آیا این غول فناوری آماده است تا در برابر تهدیدات جدید در عصر هوش مصنوعی، مسئولانهتر عمل کند یا خیر.