شرکت متا در جریان نخستین رویداد «لاماکان» (LlamaCon)، از راهاندازی API جدید Llama با سرعت بیسابقه در پردازش و تولید پاسخها خبر داد.

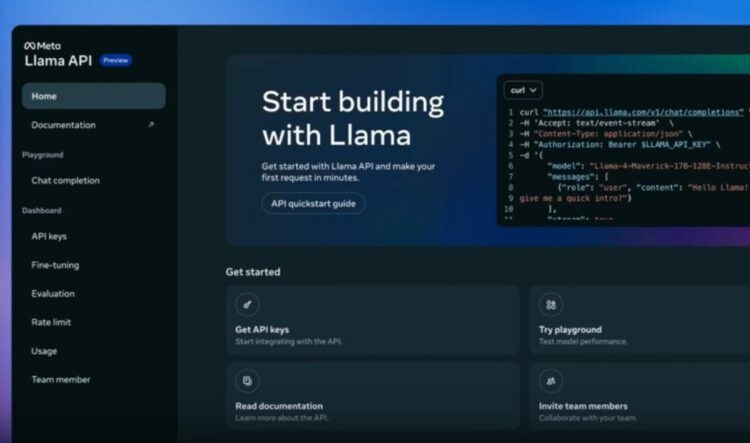

به گزارش تکناک، این API که اکنون به صورت پیشنمایش رایگان و محدود در دسترس توسعهدهندگان قرار گرفته است، امکان استفاده از مدلهای مختلف خانواده Llama — از جمله Llama 4 Scout و Llama 4 Maverick — را فراهم میکند. همچنین متا ابزارهایی مانند: ایجاد کلید API تنها با یک کلیک و نسخههای سبک SDK برای TypeScript و Python را نیز معرفی کرده است تا کار برای برنامهنویسان سادهتر شود. این API با SDK شرکت OpenAI نیز سازگار است و به توسعهدهندگان اجازه میدهد که برنامههای مبتنی بر OpenAI را با سهولت بیشتری به پلتفرم جدید منتقل کنند.

شرکت متا برای دستیابی به سرعتهای استثنایی، با شرکتهای Cerebras و Groq وارد همکاری شده است. بنا بر اعلام شرکت Cerebras، مدل Llama 4 آنها میتواند با سرعتی تا ۱۸ برابر سریعتر از راهکارهای مبتنی بر GPU مانند NVIDIA، پاسخها را تولید کند. وبسایت تخصصی Artificial Analysis نیز تأیید کرده که مدل Llama 4 Scout با پشتیبانی از Cerebras موفق شده است به نرخ تولید بیش از ۲۶۰۰ توکن در ثانیه برسد؛ در حالی که ChatGPT تنها ۱۳۰ توکن/ثانیه و DeepSeek حدود ۲۵ توکن/ثانیه تولید میکنند.

اندرو فلدمن، مدیرعامل و همبنیانگذار Cerebras، در این خصوص گفت: «Cerebras افتخار میکند که سریعترین API پردازش مدلهای زبانی جهان را ارائه میدهد. توسعهدهندگان اپلیکیشنهای عاملمحور و بلادرنگ، نیازمند سرعت هستند. با همکاری Cerebras در Llama API، آنها میتوانند سیستمهای هوش مصنوعی خلق کنند که تا پیش از این برای راهکارهای مبتنی بر GPU قابلدستیابی نبود.»

توسعهدهندگان علاقهمند میتوانند با انتخاب مدل Cerebras در میان گزینههای ارائهشده توسط Llama API، از این سرعت بالا بهرهمند شوند. مدل Llama 4 Scout از طریق Groq نیز در دسترس است، اما در حال حاضر با سرعتی در حدود ۴۶۰ توکن در ثانیه عمل میکند؛ سرعتی که اگرچه ۶ برابر کُندتر از مدل Cerebras است، اما همچنان ۴ برابر سریعتر از سایر راهکارهای GPUمحور ارزیابی میشود.