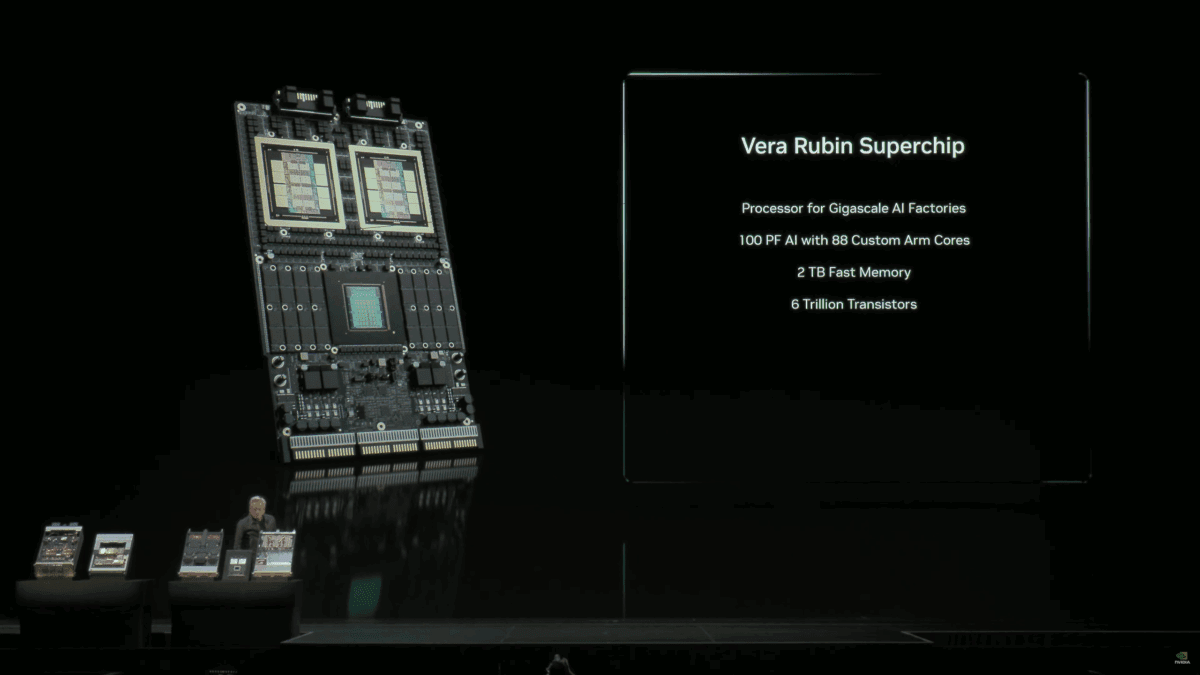

شرکت انویدیا در رویداد GTC واشنگتن برای اولینبار از سوپرچیپ نسل بعدی خود با نام Vera Rubin رونمایی کرد.

به گزارش تکناک، این تراشه قرار است موج تازهای از پیشرفت در حوزه هوش مصنوعی را رقم بزند.

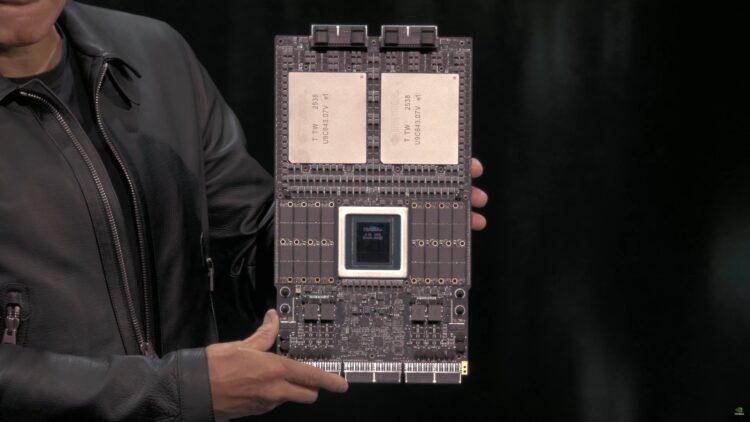

جنسن هوانگ، مدیرعامل انویدیا اعلام کرد که نخستین نمونههای GPUهای Rubin به تازگی از سوی کارخانه TSMC تایوان به آزمایشگاههای انویدیا رسیدهاند. این مادربرد یا همان «سوپرچیپ» انویدیا شامل پردازنده Vera CPU و دو GPU عظیم Rubin است و از ۳۲ ماژول حافظه LPDDR برای سیستم بهره میبرد. علاوه بر این، GPUها از حافظه HBM4 نسل جدید استفاده میکنند.

به گفته هوانگ، GPUهای Rubin در حال گذراندن مراحل آزمایشی هستند و انتظار میرود تا سهماهه سوم یا چهارم سال ۲۰۲۶ همزمان با عرضه کامل پلتفرمهای Blackwell Ultra GB300 وارد مرحله تولید انبوه شوند.

پلتفرم NVIDIA Vera Rubin NVL144 که برای نیمه دوم سال ۲۰۲۶ برنامهریزی شده است، از دو تراشه جدید استفاده میکند. GPUهای Rubin دارای دو تراشه در ابعاد رتیکل هستند که حداکثر ۵۰ پتافلاپس توان FP4 و ۲۸۸ گیگابایت حافظه HBM4 دارند. این GPUها در کنار CPU با ۸۸ هسته سفارشی ARM و ۱۷۶ رشته پردازشی قرار میگیرند و از اتصال فوقسریع NVLINK-C2C با پهنای باند ۱.۸ ترابایت بر ثانیه پشتیبانی میکنند.

در زمینه مقیاس عملکرد، سیستم NVL144 قادر است تا ۳.۶ اگزافلاپس در استنتاج FP4 و ۱.۲ اگزافلاپس در آموزش FP8 قدرت ارائه دهد؛ یعنی ۳.۳ برابر از پلتفرم GB300 NVL72 سریعتر است. همچنین این سامانه از ۱۳ ترابایت بر ثانیه حافظه HBM4، ۷۵ ترابایت حافظه سریع و دو برابر ظرفیت NVLINK و CX9 برخوردار است، که بهترتیب تا ۲۶۰ ترابایت بر ثانیه و ۲۸.۸ ترابایت بر ثانیه نرخ انتقال دارند.

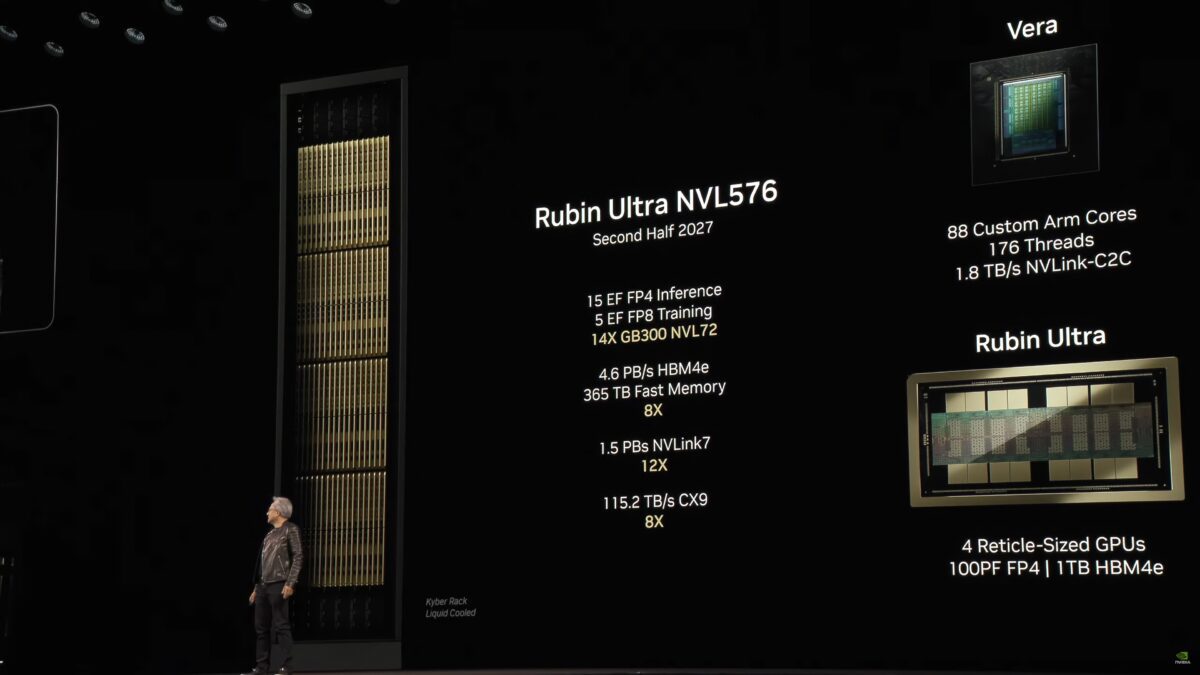

اما نسخه پیشرفتهتر یعنی Rubin Ultra NVL576 در نیمه دوم سال ۲۰۲۷ عرضه خواهد شد. این پلتفرم مقیاس سیستم را از ۱۴۴ به ۵۷۶ افزایش میدهد و از GPUهایی با چهار تراشه رتیکل بهره میبرد، که حداکثر ۱۰۰ پتافلاپس توان FP4 و یک ترابایت حافظه HBM4e (در ۱۶ ماژول) ارائه میدهند.

در این سطح، توان استنتاج به ۱۵ اگزافلاپس و آموزش به ۵ اگزافلاپس میرسد؛ یعنی ۱۴ برابر از GB300 NVL72 سریعتر است. پهنای باند حافظه به ۴.۶ پتابایت بر ثانیه و حافظه سریع به ۳۶۵ ترابایت افزایش یافته است. همچنین اتصال NVLINK تا ۱.۵ پتابایت بر ثانیه و CX9 تا ۱۱۵.۲ ترابایت بر ثانیه ارتقا یافتهاند.

این دستاوردها، سوپرچیپ Vera Rubin را به قدرتمندترین پلتفرم انویدیا تا به امروز تبدیل میکند و مسیر را برای جهش بزرگ بعدی در ابررایانههای هوش مصنوعی هموار میسازد.

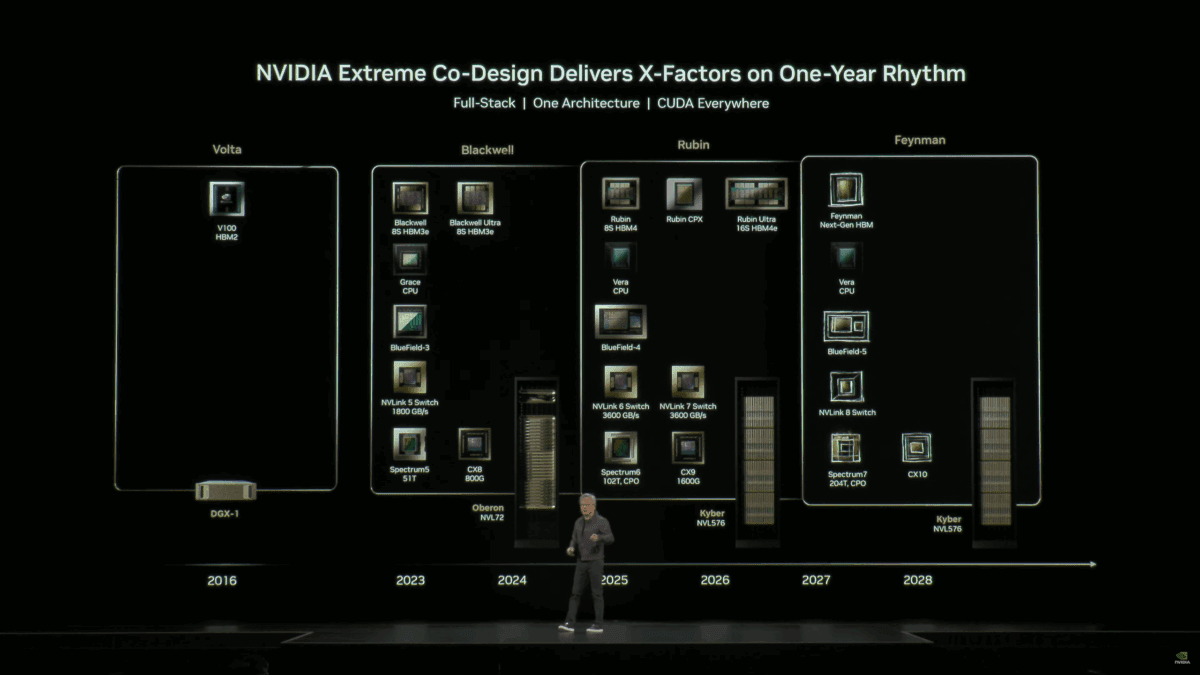

در ادامه نسخه کامل و ترکیبی جدول نقشهراه GPUهای دیتاسنتر و هوش مصنوعی انویدیا (NVIDIA Data Center / AI GPU Roadmap) آورده شده است. این جدول شامل نام رمز، خانواده تراشه، مدل، نوع حافظه، سال عرضه و ویژگیهای فنی کلیدی هر نسل است.

| نام رمز GPU | خانواده تراشه (GPU Family) | شناسه مدل (GPU SKU) | نوع حافظه (Memory) | سال عرضه (Launch Year) | ویژگی فنی کلیدی (Key Feature) |

| Feynman | GF200? | F200? | HBM4e / HBM5? | ۲۰۲۸ | نسل آینده با تمرکز بر هوش مصنوعی مولد (GenAI) و حافظه فوق سریع HBM5 |

| Rubin (Ultra) | GR300? | R300? | HBM4 | ۲۰۲۷ | چهار تراشه رتیکل، ۱۰۰ PFLOPS توان FP4، یک ترابایت حافظه HBM4e |

| Rubin | GR200? | R200? | HBM4 | ۲۰۲۶ | دو تراشه رتیکل، ۵۰ PFLOPS توان FP4، ۲۸۸ گیگابایت HBM4 |

| Blackwell (Ultra) | GB300 | B300 | HBM3e | ۲۰۲۵ | ارتقای پلتفرم GB300، کارایی بیشتر در مدلهای زبانی بزرگ (LLM) |

| Blackwell | GB200 / GB100 | B100 / B200 | HBM3e | ۲۰۲۴ | سوپرچیپ GB200 با CPU Grace و GPU دوگانه برای مراکز داده |

| Hopper | GH200 / GH100 | H100 / H200 | HBM2e / HBM3 / HBM3e | ۲۰۲۲ تا ۲۰۲۴ | تمرکز بر HPC و آموزش مدلهای GenAI، معرفی هستههای Tensor نسل چهارم |

| Ampere | GA100 | A100 | HBM2e | ۲۰۲۰ تا ۲۰۲۲ | پایهگذار عصر استنتاج AI و پردازش ابری گسترده |

| Volta | GV100 | V100 | HBM2 | ۲۰۱۸ | اولین نسل با هستههای Tensor برای یادگیری عمیق |

| Pascal | GP100 | P100 | HBM2 | ۲۰۱۶ | آغازگر نسل GPUهای HPC با تمرکز بر محاسبات موازی |