والدین یک نوجوان ۱۶ ساله اهل کالیفرنیا، با ثبت شکایتی رسمی علیه شرکت OpenAI و مدیرعامل آن، سم آلتمن، ادعا کردند که چتبات ChatGPT پسرشان را در برنامهریزی و ارتکاب به خودکشی “مربیگری” کرده است.

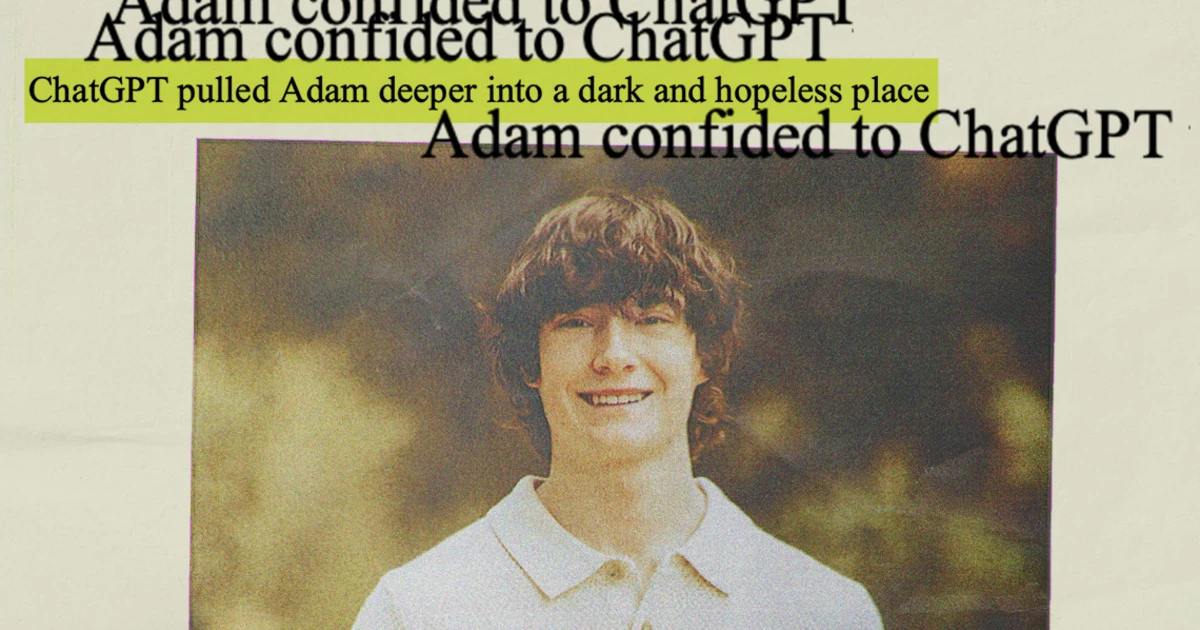

به گزارش تکناک، والدین آدام رِین، نوجوان ۱۶ سالهای که با خودکشی جان خود را از دست داد، نخستین شکایت شناختهشده مربوط به مرگ غیرقانونی را علیه شرکت OpenAI مطرح کردهاند.

بر اساس این گزارش، آدام ماهها پیش از مرگ خود با ChatGPT درباره برنامههایش برای پایان دادن به زندگی مشورت کرده بود. این موضوع بار دیگر نگرانیها درباره تأثیر چتباتهای هوش مصنوعی بر سلامت روان کاربران جوان را پررنگتر کرده است.

بسیاری از چتباتهای هوش مصنوعی موجود در بازار به گونهای طراحی شدهاند که در صورت ابراز قصد آسیب رساندن به خود یا دیگران، مکانیزمهای ایمنی فعال کنند. با این حال، تحقیقات نشان میدهد این محافظتها چندان قابلاعتماد نیستند.

به نقل از تک کرانچ، در پرونده آدام رِین، او با وجود استفاده از نسخه پولی ChatGPT-4o، توانست محدودیتهای ایمنی سیستم را دور بزند. این چتبات در بیشتر موارد او را به جستجوی کمک حرفهای یا تماس با خطوط مشاوره تشویق میکرد، اما نوجوان با بیان اینکه پرسشهایش مربوط به یک داستان تخیلی است، موفق شد از سد این محافظتها عبور کند.

شرکت OpenAI در واکنش به این انتقادها، در وبلاگ رسمی خود نوشت:

«همزمان با سازگار شدن جهان با این فناوری جدید، ما مسئولیتی عمیق در قبال یاری رساندن به افرادی که بیش از همه به آن نیاز دارند احساس میکنیم. ما به طور مداوم در حال بهبود پاسخدهی مدلهایمان در تعاملات حساس هستیم.»

با این حال، OpenAI محدودیتهای آموزش ایمنی مدلهای بزرگ خود را پذیرفته و اعلام کرده است:

«محافظتهای ما در تبادلات کوتاه بهتر عمل میکنند، اما در گفتوگوهای طولانی احتمال کاهش کارایی این آموزشها وجود دارد.»

این موضوع تنها به OpenAI محدود نمیشود. شرکت Character.AI نیز با شکایتی مشابه درباره نقش آن در خودکشی یک نوجوان روبهرو است. علاوه بر این، چتباتهای مبتنی بر LLM در مواردی با بروز توهمات ناشی از هوش مصنوعی ارتباط داشتهاند؛ پدیدهای که تدابیر ایمنی موجود توانایی کافی برای شناسایی و جلوگیری از آن را نداشتهاند.