فهرست مطالب

امروزه هوش مصنوعی به بخشی جدانشدنی از زندگی دیجیتال ما تبدیل شده است، اما وابستگی مداوم به اینترنت و سرویسهای ابری همیشه نگرانیهایی مانند حریم خصوصی، هزینههای بالا و محدودیت دسترسی را به همراه داشته است.

به گزارش تکناک، همین مسئله باعث شده توجه بسیاری از کاربران و توسعهدهندگان به سمت اجرای محلی هوش مصنوعی (Local AI) جلب شود؛ جایی که میتوان مدلهای قدرتمند زبان و تصویر را بدون نیاز به اتصال اینترنت و تنها روی رایانه شخصی اجرا کرد.

این روش امنیت دادهها را تضمین میکند و سرعت پاسخدهی بالاتری ارائه داده و هزینههای استفاده از سرویسهای ابری را نیز به حداقل میرساند. در این راهنما از آموزش هوش مصنوعی با بهترین ابزارها، مدلها و روشهای اجرای آفلاین آشنا میشوید تا بتوانید تجربهای کامل از هوش مصنوعی متنباز، سریع و ایمن روی ویندوز، لینوکس یا مک داشته باشید.

01

از 13چرا اجرای محلی هوش مصنوعی اهمیت دارد؟

اجرای محلی هوش مصنوعی (Local AI) تحولی مهم در دنیای فناوری است که به کاربران اجازه میدهد بدون نیاز به اینترنت، مدلهای هوشمند را روی دستگاه شخصی خود اجرا کنند. این قابلیت به افزایش استقلال کاربر کمک میکند و مزایای گستردهای در حوزه امنیت دادهها، کاهش هزینهها و بهینهسازی عملکرد دارد.

زمانی که پردازشها روی کامپیوتر یا سرور محلی انجام میشود، دادهها در همان محیط باقی میمانند و نیازی به ارسال آنها به سرویسهای ابری وجود ندارد؛ موضوعی که در سازمانها و کسبوکارهای دارای اطلاعات حساس اهمیت ویژهای دارد. همچنین اجرای آفلاین، دسترسی به قابلیتها را حتی هنگام قطع شبکه امکانپذیر میکند و چون همهچیز در لحظه و روی همان دستگاه انجام میشود، تجربهای سریعتر و کمتأخیر رقم میزند. در نتیجه، اجرای محلی—بهویژه وقتی در کنار بهترین ابزارهای هوش مصنوعی بهکار گرفته شود—به گزینهای جذاب برای پژوهشگران، توسعهدهندگان و شرکتها تبدیل میشود.

حفظ حریم خصوصی و امنیت دادهها

یکی از دغدغههای اصلی در استفاده از هوش مصنوعی، مسئله حفظ حریم خصوصی در پردازش هوش مصنوعی است. هنگامی که دادهها برای تحلیل یا پردازش به سرورهای ابری ارسال میشوند، همیشه خطر نشت اطلاعات یا دسترسی غیرمجاز وجود دارد. اجرای محلی این مشکل را تا حد زیادی برطرف میکند، زیرا تمام دادهها در دستگاه کاربر باقی میمانند و نیازی به اشتراکگذاری آنها با سرویسهای خارجی نیست.

برای شرکتهایی که با دادههای حساس مانند اطلاعات مالی، پزشکی یا حقوقی سروکار دارند، این موضوع اهمیت دوچندانی پیدا میکند. حتی کاربران عادی نیز میتوانند با اجرای مدلهای زبان بزرگ روی کامپیوتر شخصی خود، مطمئن باشند که مکالمات و اسناد شخصیشان در محیطی امن باقی میماند. به همین دلیل، بسیاری از توسعهدهندگان و سازمانها ترجیح میدهند از ابزارهای متنباز هوش مصنوعی استفاده کنند تا کنترل کامل بر دادههای خود داشته باشند. این رویکرد علاوه بر امنیت، حس اعتماد بیشتری به کاربران منتقل میکند.

کاهش هزینه در مقایسه با سرویسهای ابری

هزینههای مرتبط با استفاده از سرویسهای ابری همواره یکی از چالشهای اصلی سازمانها و کاربران فردی بوده است. هرچه پردازشها و درخواستها بیشتر باشد، هزینههای ماهیانه به شکل قابل توجهی افزایش پیدا میکند. اما کاهش هزینه با اجرای آفلاین مدلها بهوضوح محسوس است. زمانی که مدلها روی سختافزار محلی اجرا میشوند، نیاز به پرداخت هزینههای اشتراک یا مصرف منابع ابری از بین میرود.

حتی اگر در ابتدا لازم باشد برای خرید یک GPU یا افزایش حافظه RAM هزینهای انجام شود، در بلندمدت این سرمایهگذاری بسیار مقرونبهصرفه خواهد بود. علاوه بر این، در اجرای محلی محدودیتی برای تعداد درخواستها وجود ندارد و کاربر بدون دغدغه هزینه، از مدلها بهرهبرداری میکند.

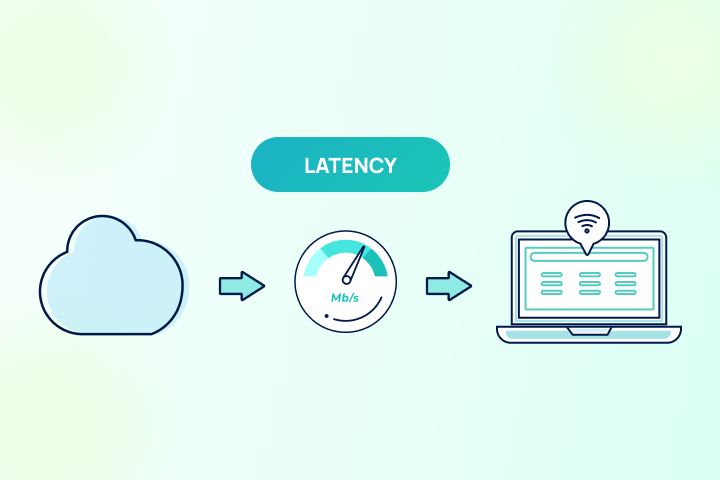

سرعت بالاتر در پردازش و کاهش تاخیر (Latency)

یکی دیگر از دلایل محبوبیت اجرای محلی، سرعت پردازش بالا و کاهش تاخیر در پاسخدهی است. زمانی که دادهها به سرورهای ابری ارسال میشوند، چندین مرحله شامل انتقال، پردازش و دریافت پاسخ وجود دارد که هرکدام تاخیر ایجاد میکند. اما در پردازش روی دستگاه (On-device AI)، همه چیز به صورت محلی و در همان سختافزار انجام میشود. این امر باعث افزایش سرعت پاسخها میشود و تجربه کاربری روانتری را به همراه دارد.

برای مثال، در یک چتبات آفلاین، کاربر میتواند بدون انتظار طولانی به پاسخهای فوری دسترسی داشته باشد. همچنین در کاربردهای زمانواقعی مانند تولید تصویر و ویدئو یا پردازش صوتی، کاهش Latency اهمیت زیادی دارد. این ویژگی بهویژه برای توسعهدهندگان بازیها، سیستمهای آموزشی و اپلیکیشنهای تعاملی بسیار ارزشمند است. به همین دلیل، بسیاری از کاربران حرفهای ترجیح میدهند مدلهای خود را روی سیستمهای شخصی اجرا کنند تا بیشترین بهرهوری را داشته باشند.

02

از 13نیازمندی سختافزاری برای اجرای LLM آفلاین

اجرای مدلهای زبان بزرگ بدون اینترنت نیازمند سختافزار مناسب است تا بتواند حجم بالای پردازشها را مدیریت کند. برای شروع، داشتن یک سیستم با پردازنده چند هستهای و حداقل ۱۶ گیگابایت RAM ضروری است. البته هرچه ظرفیت RAM بیشتر باشد، امکان بارگذاری مدلهای پیچیدهتر نیز فراهم میشود. اهمیت GPU و VRAM نیز در این مسیر غیرقابل انکار است، زیرا بسیاری از مدلهای مدرن برای استنتاج به شتابدهندههای گرافیکی نیاز دارند.

کارتهای گرافیک با حداقل ۶ گیگابایت VRAM میتوانند مدلهای سبک را اجرا کنند، اما برای پروژههای سنگینتر به ۱۲ گیگابایت یا بیشتر نیاز است. اجرای مدلها روی CPU هم امکانپذیر است، اما سرعت آن بهمراتب کمتر خواهد بود. همچنین مصرف انرژی و بهینهسازی منابع نقش مهمی در پایداری اجرای طولانیمدت دارند. در مجموع، انتخاب سختافزار مناسب بستگی به نوع مدل، حجم دادهها و سطح انتظارات کاربر دارد.

حداقل سیستم موردنیاز (CPU، RAM)

برای اجرای محلی مدلهای زبانی و تصویری، یک سیستم متوسط با قابلیتهای پایه کفایت میکند. حداقل مشخصات پیشنهادی شامل یک CPU چندهستهای (ترجیحاً نسلهای جدید اینتل یا AMD) و ۱۶ گیگابایت RAM است تا بتوان مدلهای سبک و بهینهشده را اجرا کرد. برای مدلهای بزرگتر مانند LLaMA یا Falcon، بهتر است RAM را به ۳۲ یا حتی ۶۴ گیگابایت افزایش دهید. استفاده از SSD نیز بهجای هارد مکانیکی، زمان بارگذاری و جابهجایی وزنها را بهطور محسوسی کاهش میدهد.

در نبود GPU، اجرای مدل روی CPU ممکن است اما سرعت استنتاج افت میکند؛ بنابراین، ترکیبی از CPU قدرتمند، حافظهٔ کافی و ذخیرهسازی سریع، حداقل سختافزار پیشنهادی است تا بتوانید بدون دردسر مدلهای محلی را راهاندازی کنید و از قابلیتهای آفلاین بهرهمند شوید—بهخصوص اگر قصد دارید برای آزمایش اولیه سراغ بهترین هوش مصنوعی های رایگان بروید و بدون هزینهٔ اشتراک، کیفیت و کارایی آنها را بسنجید.

اهمیت GPU و VRAM در استنتاج

GPU بهعنوان قلب تپنده پردازشهای هوش مصنوعی شناخته میشود. برخلاف CPU که برای وظایف عمومی طراحی شده است، GPU میتواند هزاران عملیات را به صورت موازی انجام دهد و این ویژگی آن را برای اجرای مدلهای بزرگ زبان و تصویر ایدهآل میسازد. VRAM یا حافظه گرافیکی نیز نقش کلیدی دارد، زیرا مدلها باید در حافظه بارگذاری شوند تا پردازش شوند. برای مدلهای سبک، ۶ گیگابایت VRAM کافی است، اما برای مدلهای پیچیدهتر حداقل ۱۲ تا ۲۴ گیگابایت نیاز است.

کاربران حرفهای که به دنبال اجرای Stable Diffusion یا LLaMA با حجم بالا هستند، به کارتهای گرافیک پیشرفته نیاز خواهند داشت. نبود GPU مناسب باعث میشود پردازشها کند شوند یا حتی امکان بارگذاری مدل وجود نداشته باشد. بنابراین، انتخاب GPU مناسب با توجه به نیاز پروژه اهمیت زیادی دارد. در نتیجه، سرمایهگذاری روی کارت گرافیک قدرتمند اجرای آفلاین مدلها را به تجربهای سریع، روان و پایدار تبدیل میکند.

تفاوت اجرای مدلها روی CPU و GPU

یکی از موضوعات کلیدی در اجرای محلی هوش مصنوعی، تفاوت عملکرد CPU و GPU است. CPUها برای پردازشهای متنوع و تسکهای روزمره بهینه شدهاند، در حالی که GPUها برای عملیات ریاضی موازی در مقیاس بزرگ طراحی شدهاند. این تفاوت معماری باعث میشود اجرای مدلها روی GPU تا چندین برابر سریعتر از CPU باشد. برای مثال، استنتاج یک مدل زبانی بزرگ روی CPU ممکن است چندین ثانیه طول بکشد، اما همان مدل روی GPU در کسری از زمان پاسخ میدهد.

البته استفاده از GPU نیازمند درایورها و کتابخانههای سازگار است که باید بهدرستی نصب شوند. از طرفی، اجرای روی CPU مزیتهایی مانند دسترسپذیری و هزینه کمتر دارد، زیرا اکثر کاربران از پیش به CPU مناسب دسترسی دارند. بهطور کلی، برای کاربران حرفهای و پروژههای سنگین، GPU انتخابی اجتنابناپذیر است، اما برای مدلهای سبک یا کاربردهای آزمایشی، CPU نیز پاسخگو است.

مصرف انرژی و بهینهسازی منابع

اجرای محلی مدلهای هوش مصنوعی خصوصاً زمانی که از GPUهای قدرتمند استفاده میشود مصرف انرژی بالایی دارد. این موضوع هزینه برق را افزایش میدهد، گرمای زیادی نیز تولید میکند و به سیستمهای خنککننده نیاز دارد. برای کاهش مصرف انرژی، بهینهسازی منابع اهمیت ویژهای دارد. یکی از روشها استفاده از مدلهای سبک و فشردهسازی شده است که بدون افت شدید در دقت، منابع کمتری مصرف میکنند.

همچنین تکنیکهایی مانند LoRA یا فاینتیون سبک به کاربران کمک میکنند بدون نیاز به بارگذاری کامل مدل، آن را برای نیازهای خاص خود تنظیم کنند. استفاده از کشگذاری و مدیریت صحیح حافظه نیز مصرف انرژی را کاهش میدهد. در محیطهای سازمانی، تقسیم بار پردازش میان چند دستگاه یا استفاده از سرورهای محلی بهینه عملکرد و مصرف انرژی را متعادل میسازد. در نهایت، انتخاب سختافزار مناسب و مدیریت هوشمندانه منابع، کلید موفقیت در اجرای آفلاین مدلها است.

03

از 13بهترین ابزارهای اجرای محلی LLM

امروزه ابزارهای متنوعی برای اجرای محلی مدلهای زبانی در دسترس کاربران قرار دارد. این ابزارها با رویکردهای مختلفی طراحی شدهاند تا نیازهای گوناگون از کاربران مبتدی تا توسعهدهندگان حرفهای را پوشش دهند. برخی از آنها رابطهای کاربری گرافیکی ساده ارائه میدهند تا کار با مدلها برای همه آسان شود، در حالی که برخی دیگر بیشتر بر خط فرمان و انعطافپذیری برای توسعهدهندگان تمرکز دارند.

برای مثال، LM Studio با رابط کاربری ساده و پشتیبانی از API، گزینهای عالی برای تازهکارها محسوب میشود. Ollama بیشتر برای کاربرانی مناسب است که به خط فرمان علاقه دارند و مدیریت مدلها را با دستورات ساده انجام میدهند. از سوی دیگر، Jan AI انتخاب مناسبی برای توسعهدهندگانی است که به دنبال یکپارچهسازی مدلها با اپلیکیشنهای خود هستند. در نهایت، GPT4All با ارائه نسخههای سبک و بهینه، امکان اجرای مدلها روی سختافزارهای متوسط را فراهم میکند. هرکدام از این ابزارها مزایا و محدودیتهای خاص خود را دارند.

LM Studio (رابط کاربری ساده و سازگار با API)

LM Studio یکی از محبوبترین ابزارها برای اجرای محلی مدلهای زبان بزرگ محسوب میشود. این نرمافزار با داشتن رابط کاربری گرافیکی ساده (GUI) به کاربران اجازه میدهد بدون دانش فنی پیچیده، مدلها را بارگذاری و اجرا کنند. یکی از ویژگیهای برجسته آن سازگاری با APIهای OpenAI است که امکان یکپارچهسازی آسان با اپلیکیشنها و سرویسهای مختلف را فراهم میکند.

کاربران میتوانند مدلهای متنباز مانند LLaMA، Mistral و Falcon را در LM Studio اجرا کرده و به عنوان یک چتبات آفلاین یا ابزار پردازش متن از آن استفاده کنند. این نرمافزار برای ویندوز، مک و لینوکس در دسترس است و انعطاف بالایی دارد. تنها محدودیت اصلی آن نیاز به GPU قدرتمند برای اجرای مدلهای بزرگتر است. با این حال، برای بسیاری از کاربران خانگی و حتی سازمانی، LM Studio انتخابی ایدهآل به شمار میرود که تعادل خوبی بین سهولت استفاده و قدرت پردازش ارائه میدهد.

Ollama (مدیریت مدلهای LLM با خط فرمان)

Ollama ابزاری قدرتمند برای کاربرانی است که به محیط خط فرمان علاقهمند هستند. این نرمافزار به جای تمرکز بر رابطهای گرافیکی، امکاناتی برای نصب سریع و مدیریت ساده مدلهای LLM ارائه میدهد. با Ollama میتوان مدلهای محبوبی مانند LLaMA و Mistral را به راحتی بارگذاری و اجرا کرد. یکی از مزیتهای اصلی آن، امکان مدیریت مدلها با دستورات ساده CLI است که انعطاف زیادی به توسعهدهندگان و کاربران حرفهای میدهد.

از سوی دیگر، این نرمافزار هنوز فاقد امکانات گسترده رابط گرافیکی است که ممکن است برای کاربران مبتدی محدودکننده باشد. Ollama بیشتر برای لینوکس و مک توسعه یافته و تمرکز آن بر کارایی و سرعت بالا در اجرای مدلها است. برای کاربرانی که به دنبال یک ابزار سبک، قابل اعتماد و قابل اسکریپتنویسی هستند، Ollama گزینهای بسیار مناسب محسوب میشود.

Jan AI (یکپارچهسازی آسان برای توسعهدهندگان)

Jan AI بیشتر از آنکه برای کاربران عادی طراحی شده باشد، تمرکز خود را روی توسعهدهندگان و تیمهای فنی قرار داده است. این ابزار API محور است و برای یکپارچهسازی مدلهای زبان بزرگ با اپلیکیشنها، سرویسها و سیستمهای سازمانی طراحی شده است. یکی از نقاط قوت Jan AI، پشتیبانی گسترده از مدلهای متنباز متنوع است که امکان استفاده از آن در پروژههای مختلف را فراهم میکند.

توسعهدهندگان میتوانند با استفاده از API این ابزار، چتبات آفلاین، سیستمهای مدیریت دانش یا ابزارهای تحلیلی اختصاصی خود را راهاندازی کنند. البته کار با Jan AI نیازمند دانش فنی بیشتری نسبت به ابزارهایی مانند LM Studio است و برای کاربران تازهکار ممکن است کمی پیچیده باشد. با این حال، برای سازمانها و تیمهای توسعه نرمافزار که به دنبال انعطاف و قابلیتهای پیشرفته هستند، Jan AI انتخابی قدرتمند و کاربردی محسوب میشود.

GPT4All (نسخههای سبک و بهینهشده برای PC)

GPT4All یکی از محبوبترین ابزارهای اجرای محلی هوش مصنوعی است که تمرکز آن بر ارائه مدلهای سبک و بهینهشده برای کامپیوترهای خانگی و لپتاپهای متوسط است. این نرمافزار به کاربران اجازه میدهد بدون نیاز به سختافزار فوقالعاده قدرتمند، از قابلیتهای مدلهای زبان بزرگ بهرهمند شوند. GPT4All هم از رابط گرافیکی (GUI) و هم از خط فرمان (CLI) پشتیبانی میکند و انعطاف زیادی برای انواع کاربران دارد.

یکی از مزیتهای اصلی آن رایگان بودن و متنباز بودن است که باعث شده جامعه کاربری گستردهای داشته باشد. البته به دلیل سبکسازی مدلها، دقت پاسخها ممکن است نسبت به مدلهای بزرگتر کمتر باشد. با این حال، برای استفادههای روزمره، آموزشی و حتی برخی کاربردهای سازمانی، GPT4All گزینهای بسیار مقرونبهصرفه و کاربردی به شمار میرود که اجرای آفلاین مدلها را برای طیف وسیعی از کاربران ممکن میسازد.

04

از 13مدلهای متنباز هوش مصنوعی قابل اجرا بدون اینترنت

یکی از بزرگترین مزیتهای هوش مصنوعی آفلاین، امکان اجرای مدلهای متنباز متنوع بدون نیاز به اینترنت است. این مدلها در حوزههای مختلف زبان، تصویر و صدا توسعه یافتهاند و به کاربران اجازه میدهند کاربردهای متنوعی را در محیط محلی تجربه کنند. در بخش مدلهای زبانی، نمونههایی مانند LLaMA، Mistral و Falcon جزو شناختهشدهترین گزینهها هستند که بهصورت رایگان و متنباز در دسترس قرار دارند.

در زمینه تولید تصویر و ویدئو، Stable Diffusion همراه با رابطهای کاربری متنوعی مانند Automatic1111 و ComfyUI به کاربران اجازه میدهد تصاویر خلاقانهای را بهصورت آفلاین بسازند. همچنین مدلهای صوتی برای تبدیل گفتار به متن یا پردازش صدا نیز بدون نیاز به اینترنت قابل استفاده هستند. این تنوع مدلها باعث شده کاربران بتوانند بسته به نیاز خود، ترکیبی از آنها را روی دستگاه شخصی نصب کرده و بهطور کامل از قدرت پردازش محلی بهرهمند شوند.

مدلهای زبانی LLaMA، Mistral و Falcon

مدلهای زبانی متنباز مانند LLaMA، Mistral و Falcon تحولی بزرگ در اجرای محلی هوش مصنوعی ایجاد کردهاند. این مدلها با حجمهای مختلف در دسترس هستند تا کاربران بسته به سختافزار خود بتوانند نسخه مناسب را انتخاب کنند. LLaMA ساخت متا، یکی از معروفترین گزینهها برای پژوهش و توسعه اپلیکیشنهای زبانی است. Mistral نیز با معماری بهینه، سرعت و دقت بالاتری نسبت به بسیاری از مدلهای مشابه ارائه میدهد.

Falcon از دیگر مدلهای قدرتمند متنباز است که در بسیاری از پروژههای تحقیقاتی و تجاری استفاده میشود. اجرای محلی این مدلها به کاربران امکان میدهد بدون نیاز به اتصال اینترنتی، از قابلیتهایی مانند چتبات آفلاین، پردازش اسناد و تولید متن بهرهمند شوند. علاوه بر این، متنباز بودن آنها به توسعهدهندگان آزادی میدهد تا تغییرات دلخواه خود را روی معماری مدل اعمال کنند و نسخههای اختصاصی متناسب با نیاز خود بسازند.

مدلهای تصویری (Stable Diffusion + Automatic1111, ComfyUI)

Stable Diffusion یکی از شناختهشدهترین مدلهای متنباز در حوزه تولید تصویر و ویدئو است که قابلیت اجرای محلی دارد.

این مدل به کاربران اجازه میدهد با وارد کردن توضیحات متنی، تصاویر خلاقانه و واقعگرایانه تولید کنند. برای سادهتر شدن استفاده از Stable Diffusion، رابطهای کاربری مانند Automatic1111 و ComfyUI توسعه داده شدهاند. Automatic1111 با داشبورد گرافیکی ساده و امکانات پیشرفته، به کاربران امکان مدیریت مدلها و شخصیسازی خروجیها را میدهد. ComfyUI نیز با طراحی ماژولار، انعطاف بالایی برای توسعهدهندگان و کاربران حرفهای فراهم میکند. اجرای این ابزارها روی کامپیوتر شخصی نیازمند GPU با VRAM مناسب است، اما پس از راهاندازی، تجربهای کاملاً مستقل و آفلاین ارائه میدهند. این موضوع برای طراحان، هنرمندان دیجیتال و حتی کسبوکارهایی که به تولید محتوا نیاز دارند، بسیار ارزشمند است، زیرا کنترل کامل بر فرآیند تولید و دادههای خود خواهند داشت.

مدلهای صوتی و پردازش گفتار بهصورت محلی

مدلهای صوتی متنباز نیز در کنار مدلهای زبانی و تصویری، جایگاه ویژهای در اجرای محلی هوش مصنوعی دارند. این مدلها میتوانند وظایفی مانند تبدیل گفتار به متن (Speech-to-Text)، تشخیص گوینده و حتی تولید صدای مصنوعی (Text-to-Speech) را بدون نیاز به اینترنت انجام دهند. اجرای محلی چنین مدلهایی بهویژه برای اپلیکیشنهای آموزشی، دستیارهای هوشمند و نرمافزارهای سازمانی بسیار کاربردی است.

به عنوان مثال، کاربری که نیاز به نوشتن متن از روی سخنرانی دارد، بدون اتصال به سرورهای خارجی و با اطمینان از حفظ حریم خصوصی دادهها، فایل صوتی خود را پردازش میکند. برخی از مدلهای محبوب در این حوزه شامل نسخههای سبکشده از Whisper یا ابزارهای مشابه هستند. استفاده از این مدلها در حالت آفلاین علاوه بر امنیت، سرعت بیشتری نیز ارائه میدهد، زیرا همه پردازشها در همان دستگاه انجام میشود و نیازی به ارسال داده به سرورهای ابری وجود ندارد.

05

از 13فریمورکها و کتابخانههای متنباز

اجرای محلی هوش مصنوعی بدون فریمورکها و کتابخانههای قدرتمند امکانپذیر نیست. این ابزارهای نرمافزاری پایهایترین بخش توسعه، آموزش و استنتاج مدلها را تشکیل میدهند. دو مورد از شناختهشدهترین آنها PyTorch و TensorFlow هستند که توسط هزاران پژوهشگر و توسعهدهنده در سراسر جهان مورد استفاده قرار میگیرند.

PyTorch به دلیل سادگی در کدنویسی و انعطافپذیری بالا در بین پژوهشگران محبوبیت زیادی دارد و گزینهای عالی برای توسعه سریع و تست مدلها است. از سوی دیگر، TensorFlow با پشتیبانی گوگل و قابلیت اجرای گسترده روی سختافزارهای مختلف، انتخاب مناسبی برای پروژههای سازمانی و تولیدی محسوب میشود. در کنار این دو، ابزارهایی مانند RAG نیز اهمیت پیدا کردهاند که امکان جستوجو و پاسخدهی هوشمند بر اساس اسناد را فراهم میکنند. این کتابخانهها و فریمورکها زیربنای اجرای مدلهای محلی هستند و مسیر توسعه هوش مصنوعی آفلاین را هموار میکنند.

PyTorch برای توسعه و استنتاج مدلها

PyTorch یکی از پرکاربردترین کتابخانههای متنباز در حوزه یادگیری عمیق است که توسط فیسبوک توسعه داده شده است. این فریمورک به دلیل ساختار انعطافپذیر و رابط کاربری ساده، در میان پژوهشگران و توسعهدهندگان محبوبیت زیادی دارد. PyTorch به کاربران اجازه میدهد مدلها را بهصورت ماژولار طراحی و پیادهسازی کنند و همین موضوع روند توسعه و تست را تسهیل میکند.

یکی از مزایای اصلی PyTorch، پشتیبانی عالی از GPU است که سرعت استنتاج و آموزش مدلها را به شکل قابل توجهی افزایش میدهد. همچنین این کتابخانه با ابزارهایی مانند Hugging Face Transformers سازگار است و به کاربران امکان میدهد مدلهای متنباز LLM را بهراحتی بارگذاری و اجرا کنند. استفاده از PyTorch برای اجرای محلی مدلها تجربهای روان و کارآمد ارائه میدهد و بهویژه برای پروژههای تحقیقاتی و پروتوتایپسازی بسیار مفید است.

TensorFlow و نقش آن در یادگیری ماشین

TensorFlow یکی دیگر از فریمورکهای قدرتمند متنباز است که توسط گوگل توسعه یافته و در بسیاری از پروژههای یادگیری ماشین و هوش مصنوعی بهکار میرود. این کتابخانه به دلیل قابلیت مقیاسپذیری بالا و پشتیبانی از اجرا روی CPU، GPU و حتی TPU، انتخاب مناسبی برای پروژههای بزرگ و سازمانی است. TensorFlow محیطی جامع برای طراحی، آموزش و استنتاج مدلها فراهم میکند و با ابزارهایی مانند Keras، توسعه مدلها را سادهتر میسازد.

یکی از نقاط قوت TensorFlow، پشتیبانی گسترده جامعه کاربری و مستندات کامل آن است که یادگیری و استفاده از آن را برای توسعهدهندگان آسان میکند. اجرای محلی مدلها با استفاده از TensorFlow به کاربران اجازه میدهد فرآیندهای پیچیده یادگیری ماشین را بدون وابستگی به سرویسهای ابری پیادهسازی کنند. این ویژگی برای کسبوکارهایی که به دنبال کنترل بیشتر بر دادهها و کاهش هزینهها هستند، اهمیت زیادی دارد.

استفاده از RAG برای جستوجو و پاسخدهی بر اساس اسناد

RAG یا Retrieval-Augmented Generation یکی از تکنیکهای نوین در حوزه هوش مصنوعی است که نقش مهمی در بهبود دقت و کاربرد مدلها ایفا میکند. این روش ترکیبی از بازیابی اطلاعات و تولید متن است که به مدلها امکان میدهد پاسخهایی دقیقتر و مبتنی بر اسناد واقعی ارائه دهند. در اجرای محلی، استفاده از RAG به کاربران کمک میکند تا دادههای سازمانی یا شخصی خود را به مدل متصل کرده و چتباتهایی بسازند که بر اساس اطلاعات اختصاصی پاسخ میدهند.

این موضوع برای سازمانهایی که نیاز به مدیریت دانش داخلی دارند، بسیار کاربردی است. بهعنوان مثال، یک شرکت پایگاه داده مستندات داخلی خود را به مدل متصل کرده و از آن برای پاسخگویی به سوالات کارکنان استفاده میکند. اجرای RAG به صورت آفلاین نیز باعث حفظ حریم خصوصی دادهها و افزایش امنیت میشود. این روش یکی از گامهای مهم در توسعه چتباتهای هوشمند محلی است.

06

از 13کاربردهای هوش مصنوعی آفلاین

هوش مصنوعی آفلاین با قابلیت اجرای مدلها بدون اینترنت، فرصتهای گستردهای برای کاربران و سازمانها فراهم کرده است. یکی از مهمترین کاربردها، ساخت چتبات شخصی و سازمانی است که در محیطی امن و بدون نیاز به سرورهای خارجی کار میکند. علاوه بر آن، پردازش اسناد و مدیریت دانش داخلی از دیگر کاربردهای مهم است که به شرکتها کمک میکند اطلاعات حساس خود را بدون نگرانی از نشت دادهها مدیریت کنند.

استفاده آموزشی و تحقیقاتی نیز جایگاه ویژهای دارد، زیرا پژوهشگران میتوانند مدلها را در محیط محلی اجرا کرده و بدون وابستگی به سرویسهای ابری آزمایشهای خود را انجام دهند. همچنین، در حوزههای تجاری و سازمانی، اجرای محلی به کاهش هزینهها و افزایش کنترل بر دادهها کمک میکند. این تنوع در کاربردها نشان میدهد که هوش مصنوعی آفلاین تنها یک انتخاب تکنولوژیک نیست، بلکه یک استراتژی کلیدی برای آینده هوش مصنوعی محسوب میشود.

ساخت چتبات شخصی و سازمانی

یکی از رایجترین کاربردهای اجرای محلی هوش مصنوعی، توسعه چتباتهای شخصی و سازمانی است. چتبات آفلاین بدون نیاز به اینترنت، پاسخگوی سوالات کاربر است و در سازمانها بهعنوان یک دستیار هوشمند داخلی عمل میکند. این چتباتها با اتصال به پایگاه داده داخلی یا اسناد شرکت، قادرند پاسخهای دقیق و مبتنی بر دادههای سازمانی ارائه دهند. مزیت بزرگ این روش، حفظ حریم خصوصی دادهها است، زیرا هیچیک از اطلاعات به سرورهای خارجی ارسال نمیشود.

برای کاربران عادی نیز امکان ساخت یک چتبات شخصی وجود دارد که در مدیریت کارهای روزمره، آموزش یا حتی سرگرمی مفید است. ابزارهایی مانند LM Studio یا GPT4All این فرآیند را برای کاربران سادهتر کردهاند. به این ترتیب، چتباتهای آفلاین ترکیبی از امنیت، سرعت و انعطافپذیری را در اختیار کاربران قرار میدهند و یکی از کاربردهای کلیدی هوش مصنوعی محلی محسوب میشوند.

پردازش اسناد و مدیریت دانش داخلی

سازمانها همواره با حجم زیادی از اسناد و دادههای داخلی مواجه هستند که مدیریت و تحلیل آنها نیازمند ابزارهای هوشمند است. اجرای محلی هوش مصنوعی در این زمینه مزیتهای قابلتوجهی ارائه میدهد. مدلهای زبان بزرگ میتوانند برای جستوجو، دستهبندی و تحلیل اسناد داخلی به کار گرفته شوند، بدون آنکه دادهها از محیط سازمان خارج شوند. این موضوع به حفظ امنیت و حریم خصوصی اطلاعات کمک میکند.

علاوه بر آن، استفاده از روشهایی مانند RAG امکان میدهد مدلها پاسخهای دقیق و مبتنی بر محتوای داخلی سازمان ارائه دهند. به این ترتیب، کارکنان میتوانند به سرعت به اطلاعات موردنیاز دسترسی پیدا کنند و بهرهوری افزایش یابد. اجرای چنین راهحلهایی در محیطهای آفلاین هزینهها را کاهش میدهد و کنترل کامل بر فرآیند پردازش و نگهداری دادهها را نیز فراهم میکند. این کاربرد یکی از دلایل اصلی تمایل سازمانها به استفاده از LLMهای محلی است.

استفاده آموزشی و تحقیقاتی

اجرای محلی هوش مصنوعی فرصتهای گستردهای برای محیطهای آموزشی و تحقیقاتی فراهم کرده است. دانشگاهها و موسسات علمی میتوانند بدون وابستگی به سرویسهای ابری، مدلهای زبان و تصویر را برای آموزش دانشجویان یا انجام تحقیقات علمی اجرا کنند. این روش علاوه بر کاهش هزینه، امکان دسترسی به ابزارهای پیشرفته را حتی در محیطهایی با محدودیت اینترنت فراهم میکند.

برای دانشجویان، کار با ابزارهای متنباز مانند GPT4All یا Stable Diffusion تجربهای ارزشمند است که به آنها در یادگیری عملی کمک میکند. پژوهشگران نیز میتوانند آزمایشهای خود را روی دادههای حساس یا اختصاصی بدون نگرانی از نشت اطلاعات انجام دهند. استفاده از فریمورکهایی مانند PyTorch و TensorFlow نیز به توسعهدهندگان امکان میدهد پروژههای تحقیقاتی خود را با انعطاف بالا طراحی و اجرا کنند. به این ترتیب، اجرای محلی هوش مصنوعی به یک ابزار کلیدی برای آموزش و پژوهش علمی تبدیل شده است.

استفاده تجاری و سازمانی (Enterprise AI)

اجرای آفلاین مدلهای هوش مصنوعی در محیطهای تجاری و سازمانی بهسرعت در حال گسترش است. شرکتها میتوانند از این فناوری برای بهبود فرآیندهای داخلی، تحلیل دادهها و ارائه خدمات هوشمند به مشتریان استفاده کنند، بدون آنکه به سرویسهای ابری وابسته باشند. این رویکرد علاوه بر کاهش هزینههای عملیاتی، کنترل کامل بر دادهها و فرآیندها را نیز در اختیار سازمان قرار میدهد.

برای مثال، یک شرکت چتبات سازمانی خود را بهصورت محلی راهاندازی میکند تا کارکنان بهسرعت پاسخ سوالات مربوط به مستندات داخلی را دریافت کنند. همچنین پردازش آفلاین به سازمانها اجازه میدهد در شرایطی که دسترسی به اینترنت محدود یا پرهزینه است، همچنان از قدرت هوش مصنوعی بهرهمند شوند. ابزارهایی مانند Jan AI یا LM Studio میتوانند برای یکپارچهسازی مدلها با سیستمهای موجود بهکار روند. در مجموع، اجرای محلی در محیط سازمانی راهکاری مقرونبهصرفه، امن و انعطافپذیر برای آینده کسبوکارها محسوب میشود.

07

از 13مقایسه اجرای آفلاین و ابری

انتخاب بین اجرای آفلاین و ابری هوش مصنوعی به نیازها، بودجه و اولویتهای کاربران بستگی دارد. اجرای ابری امکان دسترسی آسان، مقیاسپذیری سریع و استفاده از منابع قدرتمند را فراهم میکند، اما با هزینههای بالا و نگرانیهای مربوط به حریم خصوصی همراه است. در مقابل، اجرای محلی مدلها هزینههای طولانیمدت را کاهش داده و امنیت بیشتری ارائه میدهد، اما نیازمند سختافزار قدرتمند و نگهداری مناسب است.

برای شرکتهای کوچک و استارتاپها، اجرای محلی گزینهای مقرونبهصرفهتر است. در حالی که سازمانهای بزرگ ممکن است برای پروژههای گسترده همچنان به زیرساختهای ابری نیاز داشته باشند. به طور کلی، اجرای آفلاین برای کسانی مناسب است که به امنیت دادهها و کاهش هزینه اهمیت بیشتری میدهند، در حالی که اجرای ابری بیشتر برای مقیاسپذیری سریع و پردازشهای سنگین انتخاب میشود. این مقایسه نشان میدهد که هر دو رویکرد مزایا و معایب خاص خود را دارند و انتخاب درست وابسته به شرایط است.

هزینه اجرای محلی در برابر هزینه سرویسهای ابری

هزینه یکی از عوامل تعیینکننده در انتخاب بین اجرای محلی و ابری است. در سرویسهای ابری، کاربران معمولاً بر اساس میزان پردازش یا تعداد درخواستها هزینه پرداخت میکنند که در پروژههای بزرگ بسیار بالا است. علاوه بر آن، هزینههای اشتراک ماهیانه نیز بار مالی مضاعفی ایجاد میکند. در مقابل، اجرای محلی نیازمند سرمایهگذاری اولیه در سختافزار مانند RAM، GPU و ذخیرهسازی سریع است، اما پس از آن استفاده از مدلها بدون هزینه مداوم امکانپذیر خواهد بود. کاهش هزینه با اجرای آفلاین مدلها بهویژه برای شرکتهای کوچک یا پژوهشگران مستقل اهمیت زیادی دارد.

حتی اگر هزینه خرید سختافزار بالا باشد، در بلندمدت این سرمایهگذاری بهصرفهتر از پرداخت مستمر به سرویسهای ابری است. به همین دلیل بسیاری از کاربران ترجیح میدهند بهجای پرداخت هزینههای متغیر، یک بار روی سختافزار مناسب سرمایهگذاری کنند و کنترل کامل بر منابع خود داشته باشند.

مزایا و معایب اجرای مدلها روی دستگاه شخصی

اجرای مدلها روی دستگاه شخصی مزایای متعددی دارد. از جمله این مزایا میتوان به حفظ حریم خصوصی، کاهش هزینهها، دسترسی آفلاین و سرعت بالاتر در پردازش اشاره کرد. کاربران میتوانند بدون نگرانی از نشت دادهها، اطلاعات خود را در محیطی امن پردازش کنند. همچنین اجرای محلی به کاهش وابستگی به سرویسهای خارجی کمک میکند. با این حال، این رویکرد معایبی نیز دارد. نیاز به سختافزار قدرتمند و پرهزینه، مصرف انرژی بالا و پیچیدگیهای فنی از جمله چالشهای آن است.

علاوه بر این، نگهداری و بهروزرسانی مدلها بر عهده کاربر خواهد بود، در حالی که سرویسهای ابری این وظیفه را بهصورت خودکار انجام میدهند. بنابراین، اجرای روی دستگاه شخصی برای کاربرانی مناسب است که به امنیت و استقلال اهمیت بیشتری میدهند و توانایی مدیریت سختافزار و نرمافزار را دارند. انتخاب بین این دو گزینه به سطح نیاز و اولویتهای هر کاربر بستگی دارد.

مقیاسپذیری در محیط تیمی یا سازمانی

مقیاسپذیری یکی از موضوعات کلیدی در انتخاب بین اجرای آفلاین و ابری است. در محیطهای سازمانی، نیاز به پردازش همزمان چندین کاربر یا مدیریت حجم بالای دادهها وجود دارد. سرویسهای ابری به دلیل زیرساخت گسترده، امکان مقیاسپذیری سریع و آسان را فراهم میکنند. در مقابل، اجرای محلی محدود به منابع سختافزاری موجود است و مقیاسپذیری آن به ارتقای سختافزار وابسته است. با این حال، بسیاری از سازمانها ترجیح میدهند بهجای تکیه کامل بر ابر، ترکیبی از هر دو رویکرد را بهکار گیرند.

در این حالت، دادههای حساس بهصورت محلی پردازش میشوند و وظایف سنگینتر به سرورهای ابری سپرده میشود. این مدل هیبریدی به سازمانها اجازه میدهد بین امنیت، هزینه و مقیاسپذیری تعادل برقرار کنند. به طور کلی، اجرای محلی برای تیمهای کوچک یا پروژههای با دادههای حساس مناسبتر است، در حالی که برای پروژههای بسیار بزرگ، استفاده از ابر همچنان ضروری خواهد بود.

08

از 13روشهای بهینهسازی اجرای محلی

اجرای محلی مدلهای هوش مصنوعی به دلیل محدودیت منابع سختافزاری همیشه نیازمند راهکارهای بهینهسازی است. اگرچه رایانههای مدرن توان پردازشی بالایی دارند، اما مدلهای بزرگ زبان (LLM) و مدلهای تولید تصویر و ویدئو معمولاً به حافظه و قدرت گرافیکی سنگین نیازمندند. به همین دلیل، استفاده از روشهایی مانند کشگذاری، فاینتیون سبک و کاهش تأخیر در پردازش نقش کلیدی در بهبود عملکرد دارد.

هدف از این روشها افزایش سرعت، کاهش مصرف انرژی و به حداقل رساندن نیاز به منابع گرانقیمت است. بسیاری از توسعهدهندگان و کاربران حرفهای با ترکیب این تکنیکها توانستهاند مدلهای قدرتمند را حتی روی سیستمهای خانگی یا لپتاپ اجرا کنند. این روند هزینهها را کاهش میدهد و اجرای آفلاین هوش مصنوعی را برای افراد بیشتری قابل دسترس میسازد.

کشگذاری مدلها و مدیریت حافظه

یکی از مهمترین روشهای بهینهسازی، کشگذاری مدلها است. این کار باعث میشود بخشهایی از مدل که بیشتر استفاده میشوند در حافظه سریعتر ذخیره شده و زمان بارگذاری کاهش یابد. بهویژه در مدلهای بزرگ، مدیریت درست حافظه RAM و VRAM مانع از کندی سیستم یا کرش کردن نرمافزار میشود.

استفاده از LoRA و فاینتیون سبک

فاینتیون کامل یک مدل بزرگ نیازمند منابع عظیم است. اما با تکنیک LoRA میتوان تنها لایههای خاصی از مدل را آموزش داد و در نتیجه مصرف GPU و RAM بهطور چشمگیری کاهش مییابد. این روش برای کاربردهای سازمانی یا شخصی که نیاز به سفارشیسازی دارند بسیار مؤثر است.

کاهش Latency در اجرای دستورات

Latency یا تأخیر در پاسخدهی یکی از چالشهای اجرای محلی است. با استفاده از روشهایی مانند تقسیم پردازش بین CPU و GPU، اجرای دستورات بهینهسازیشده و بارگذاری بخشی از مدل در حافظه سریعتر، میتوان این مشکل را کاهش داد. نتیجه آن تجربه کاربری روانتر و پاسخهای سریعتر است.

09

از 13رابطهای کاربری و تجربه کاربری

اجرای محلی مدلهای هوش مصنوعی تنها به توان پردازشی محدود نمیشود؛ بلکه کیفیت تجربه کاربری (UX) نیز اهمیت زیادی دارد. اگر ابزارها رابطهای ساده و کاربردی نداشته باشند، حتی بهترین مدلها نیز کمتر مورد استفاده قرار میگیرند. به همین دلیل، توسعهدهندگان ابزارهای مختلف دو مسیر متفاوت را دنبال کردهاند: نرمافزارهای دارای رابط گرافیکی (GUI) برای کاربران عادی و ابزارهای خط فرمان (CLI) برای متخصصان. این تنوع باعث شده کاربران با هر سطح از دانش فنی بتوانند از قدرت هوش مصنوعی آفلاین بهرهمند شوند.

نرمافزارهای با رابط گرافیکی ساده (GUI)

این نرمافزارها محیطی کاربرپسند ایجاد میکنند تا افراد بدون نیاز به کدنویسی، تنها با چند کلیک مدلها را بارگذاری و اجرا کنند. برنامههایی مانند LM Studio نمونه بارزی از چنین ابزارهایی هستند.

ابزارهای خط فرمان و اسکریپتها برای حرفهایها

کاربران حرفهای که به دنبال انعطافپذیری بیشتر هستند، از ابزارهای CLI و اسکریپتها بهره میبرند. این ابزارها امکان اجرای دقیق دستورات و یکپارچهسازی با پروژههای نرمافزاری را فراهم میکنند.

10

از 13آینده هوش مصنوعی آفلاین و جایگزینی سرویسهای ابری

با رشد سریع هوش مصنوعی، آینده به سمت اجرای محلی و آفلاین حرکت میکند. بسیاری از کاربران و سازمانها ترجیح میدهند دادههای حساس خود را به سرورهای ابری ارسال نکنند و در عوض از مدلهای آفلاین روی رایانه یا سرور خانگی استفاده کنند. این تغییر امنیت دادهها را افزایش میدهد و هزینههای بلندمدت را نیز کاهش میدهد. با این حال، مسیر جایگزینی کامل سرویسهای ابری نیازمند پیشرفتهای بیشتر در زمینه مدیریت مدلها و بهینهسازی منابع است.

11

از 13رشد دستیارهای هوشمند مبتنی بر اسناد شخصی

یکی از روندهای آینده، توسعه دستیارهایی است که اسناد و دادههای شخصی را پردازش کرده و بدون اتصال به اینترنت پاسخهای هوشمند ارائه میدهند.

جایگزینی تدریجی سرویسهای ابری با سرورهای خانگی

با پیشرفت سختافزارهای خانگی و ابزارهای متنباز، بسیاری از کاربران قادر خواهند بود مدلها را بهصورت کامل روی دستگاههای خود اجرا کنند و نیازی به سرویسهای ابری نداشته باشند.

چالشهای نگهداری و بهروزرسانی مدلهای محلی

با وجود مزایا، بهروزرسانی و نگهداری مدلهای محلی نیاز به دانش فنی و منابع سختافزاری کافی دارد. این موضوع میتواند برای برخی کاربران چالشبرانگیز باشد، اما روند توسعه ابزارهای سادهتر این مشکل را به تدریج حل خواهد کرد.

12

از 13مقایسه ابزارهای اجرای محلی هوش مصنوعی

| ابزار | نوع رابط | پشتیبانی از مدلها | مزایا | معایب | سیستمعاملها |

| LM Studio | GUI + API | LLaMA, Mistral, Falcon | رابط کاربری ساده، سازگاری با OpenAI API | نیاز به GPU قوی برای مدلهای بزرگ | ویندوز، مک، لینوکس |

| Ollama | CLI | LLaMA, Mistral | نصب سریع، مدیریت آسان مدلها | محدودیت در امکانات GUI | مک، لینوکس |

| Jan AI | API محور | مدلهای متنباز متنوع | مناسب توسعهدهندگان، یکپارچهسازی با اپلیکیشنها | نیازمند دانش فنی بیشتر | ویندوز، مک، لینوکس |

| GPT4All | GUI + CLI | مدلهای سبک LLM | اجرا روی سختافزار متوسط، رایگان | دقت کمتر نسبت به مدلهای بزرگ | ویندوز، مک، لینوکس |

13

از 13پرسشهای متداول (FAQ)

بله، بسیاری از مدلهای متنباز مانند LLaMA و Mistral قابل دانلود و اجرای آفلاین هستند.

حداقل 16 گیگابایت RAM و GPU با VRAM حداقل 6 گیگابایت توصیه میشود.

بله، زیرا دادهها روی دستگاه شما باقی میمانند و به سرورهای خارجی ارسال نمیشوند.

بله، با رابطهایی مثل Automatic1111 و ComfyUI میتوانید تصاویر را بدون نیاز به اینترنت تولید کنید.

LM Studio و GPT4All به دلیل رابط کاربری ساده گزینههای مناسبی هستند.