مایکروسافت سیستم هوش مصنوعی (AI) مولد گفتار جدیدی به نام VALL-E 2 توسعه داده است که بهگفته خودش، آنقدر دقیق است که نمیتوان آن را دردسترس عموم قرار داد.

بهگزارش تکناک، مایکروسافت در هفتهی جاری اعلام کرد که توسعهی VALL-E 2، نسخهی دوم مولد گفتار هوش مصنوعی VALL-E خود را بهپایان رسانده است. بهگفتهی محققان، VALL-E 2 آنقدر پیشرفته است که انتشار عمومی آن خطرناک خواهد بود؛ زیرا این ابزار میتواند برای تقلید قانعکنندهی صدای انسانهای واقعی استفاده شود. بنابراین، این مدل فقط برای اهداف تحقیقاتی در نظر گرفته شده است.

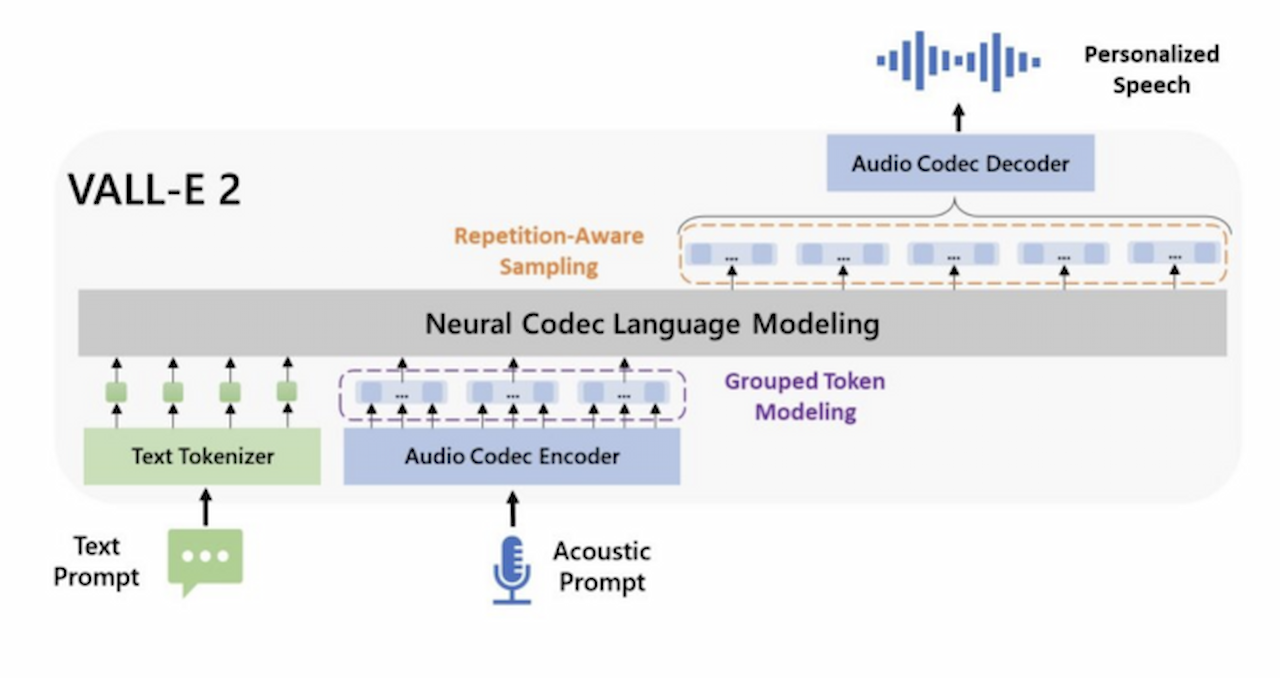

اکستریمتک مینویسد که مانند نسخهی قبلی VALL-E 2 مدل زبان کدک عصبی است؛ دستهای از یادگیری عمیق که از تکنیکهای شبکه عصبی برای رمزگذاری و رمزگشایی اطلاعات زبانی استفاده میکند. بااینحال برخلاف VALL-E، مدل VALL-E 2 ترکیب متن به گفتار (TTS) را انجام میدهد که از ورودیهای متنی برای تولید گفتار برای صداهایی استفاده میکند که بهطور مشخص برای آنها آموزش ندیده است.

این مدل از کتابخانههای آموزشی وسیع LibriSpeech و VCTK برای نگاشت ورودیهای متنی به خروجیهای صوتی مرتبط استفاده میکند. این نگاشت تغییرات در تلفظ، لحن، آهنگ و… را در نظر میگیرد. پس از شنیدن کلیپی کوتاه از گفتار کسی همراه با ورودی متن کاربر، VALL-E 2 برخی از این تغییرات را در پاسخ خود برای تولید گفتار مصنوعی تقلیدکنندهی صدای نمونهبرداریشده و شامل واژگان ورودی متن قرار میدهد.

هرکسی که جملات خشک و مصنوعی مولدهای گفتار هوش مصنوعی گذشته را شنیده باشد، میداند که این کار چقدر سخت است؛ اما طبق گفتهی محققان گروه محاسبات زبان طبیعی در مایکروسافت ریسرچ آسیا، VALL-E 2 این کار را بهطور یکپارچه انجام میدهد. درواقع، این مولد گفتار بهگفتهی محققان اولین نمونهای است که به سطح «برابر با انسان» دست یافته و دراختیار عموم قراردادن آن ممکن است آسیب بیشتری داشته باشد.

محققان در بیانیهای نوشتند:

VALL-E 2 صرفاً پروژهای تحقیقاتی است. درحالحاضر، برنامهای برای ادغام VALL-E 2 در محصول یا گسترش دسترسی به عموم نداریم. این مدل ممکن است خطرات بالقوهای در سوءاستفاده داشته باشد؛ مانند جعل هویت صوتی یا تقلید از گویندهای خاص.

این تیم خاطرنشان میکند که VALL-E 2 در مباحث آموزش یا سرگرمی مؤثرتر خواهد بود؛ چراکه در آن مدل میتواند دورههای آنلاین یا کتابهای صوتی را با حفظ صدای طبیعی انسانی خاص روایت کند.

بااینهمه، حتی این موضوع نیز میتواند مشکلات اخلاقی ایجاد کند. سایر مولدهای گفتار مانند Voicebox متا و ابزار روایت آمازون با هوش مصنوعی، بر سر اجازهدادن به هوش مصنوعی برای تقلید صدای فرد واقعی، بهویژه زمانیکه آن فرد دیگر برای ارائه رضایت خود دردسترس نیست، جنجالبرانگیز شدهاند.

مانند سایر اشکال هوش مصنوعی مولد، مولدهای گفتار نیز سؤالاتی دربارهی جایگزینی مشاغل انسانی را مطرح کردهاند؛ مسئلهای که بهویژه صداپیشگان نگران آن هستند. رویهمرفته با قفلکردن VALL-E 2، مایکروسافت میتواند بهراحتی محدودیتهای عملی مدل را آزمایش کند. محققان مینویسند:

آزمایشها را با این فرض انجام دادیم که کاربر موافقت میکند که گویندهی هدف در ترکیب گفتار باشد. اگر این مدل به گویندگان ناشناخته در دنیای واقعی تعمیم داده شود، باید پروتکلی برای اطمینان از تأیید استفاده از صدای گوینده و مدل تشخیص گفتار ترکیبشده وجود داشته باشد.