شرکت OpenAI به تازگی از مدل استدلالی جدید خود به نام o3 و نسخه کوچکتر آن o3-mini رونمایی کرد.

به گزارش تکناک، این مدلها که در آخرین روز از رویداد «12 روز با OpenAI» معرفی شدند، برای اولین بار در یک رویداد خاص، پیشنمایش میشوند.

با وجود این، شرکت OpenAI اعلام کرد که این مدلها به زودی منتشر نخواهند شد. این شرکت تأکید کرده که نتایج نهایی این مدلها ممکن است با گذشت زمان و در نتیجه تستهای بیشتر تغییر کنند.

همچنین OpenAI از محققان و اعضای جامعه علمی درخواست کرده است تا برای آزمایش این سیستمها قبل از انتشار عمومی، درخواستهای خود را ارسال کنند. تاریخ دقیق انتشار عمومی هنوز مشخص نشده است.

مدل استدلالی o3 شرکت OpenAI و نسخه کوچکتر آن o3-mini به طور خاص برای حل مسائل پیچیده و افزایش قدرت استدلال ماشینها طراحی شدهاند.

شرکت OpenAI این مدلها را به طور مستقیم پس از مدل o1 (با نام رمز Strawberry) که در سپتامبر گذشته معرفی شد، رونمایی و از مدل o2 صرفنظر کرد. این تصمیم برای جلوگیری از ایجاد هرگونه سردرگمی یا تضاد تجاری با شرکت مخابراتی بریتانیایی O2 گرفته شد.

واژه «استدلال» به طور فزایندهای در دنیای هوش مصنوعی به کار میرود و به معنای توانایی سیستمها برای تجزیه و تحلیل و حل مسائل پیچیده از طریق تقسیم وظایف به بخشهای کوچکتر و قابل مدیریت است.

این مدلها نهتنها به نتیجه نهایی دست مییابند، بلکه روند و روشهایی که برای رسیدن به جواب استفاده کردهاند را نیز نشان میدهند، تا کاربران بتوانند دلیل تصمیمات مدل را درک کنند.

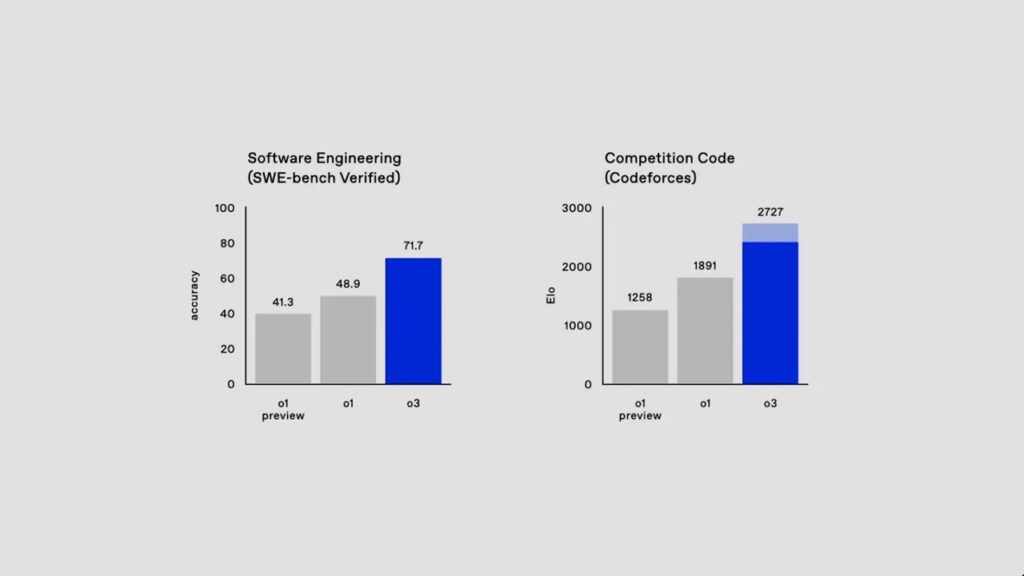

بر اساس اعلام OpenAI، مدل استدلالی جدید o3 در مقایسه با نسخههای قبلی خود عملکرد بسیار بهتری دارد. این مدل توانسته است در آزمونهای برنامهنویسی (SWE-Bench Verified) 22.8 درصد بهتر از نسخه قبلی خود عمل کند، همچنین از دانشمند ارشد OpenAI در برنامهنویسی رقابتی پیشی بگیرد.

این مدل در یکی از سختترین مسابقات ریاضی (AIME 2024) تنها یک سؤال را اشتباه جواب داد و توانست در معیار مسائل علمی سطح کارشناسی (GPQA Diamond) 87.7 درصد امتیاز کسب کند.

از طرفی، در چالشهای ریاضی و استدلالی که هوش مصنوعی اغلب در آنها با مشکل مواجه میشود، مدل o3 توانست 25.2 درصد از مسائل را حل کند، در حالی که هیچ مدل دیگری از مرز 2 درصد عبور نکرده است.

شرکت OpenAI در کنار پیشرفتهای فنی، تحقیقات جدیدی را در زمینه همراستایی تبیینی معرفی کرده است. این تحقیق به مدلهای هوش مصنوعی این امکان را میدهد که تصمیمات ایمنی خود را به طور گام به گام و دقیق بررسی کنند.

این الگو به جای استفاده از قوانین ساده بله/خیر برای تصمیمگیری، از مدل هوش مصنوعی میخواهد که به طور فعال بررسی کند که آیا درخواست کاربران با سیاستهای ایمنی OpenAI همخوانی دارد یا خیر.

نتایج آزمایشات نشان میدهد که مدل o1 در این زمینه عملکرد بهتری نسبت به مدلهای قبلی، از جمله GPT-4، داشته و توانسته است دستورالعملهای ایمنی را با دقت بیشتری دنبال کند.

شرکت OpenAI با معرفی این مدلها و تحقیقات جدید، گامهای بزرگی در جهت پیشرفت فناوریهای هوش مصنوعی و افزایش ایمنی سیستمها برداشته است.

به نظر میرسد که این مدلها قادر خواهند بود در حل مسائل پیچیدهتر و ارائه توضیحات شفافتر در مورد تصمیمات خود، انقلابی در دنیای هوش مصنوعی ایجاد کنند.