پژوهشگران Google Research روشی نوین در یادگیری ماشین با نام Nested Learning توسعه دادهاند که هدف آن رفع یکی از بزرگترین مشکلات هوش مصنوعی یعنی «فراموشی فاجعهبار» در یادگیری پیوسته است.

به گزارش سرویس هوش مصنوعی تکناک، «فراموشی فاجعهبار» به وضعیتی گفته میشود که یک مدل هوش مصنوعی با دادههای تازه آموزش میبیند یا مهارت جدیدی یاد میگیرد، اما بخش زیادی از تواناییهای قبلی خود را از دست میدهد و در انجام کارهایی که پیشتر بر آنها مسلط بوده است، دچار افت عملکرد میشود.

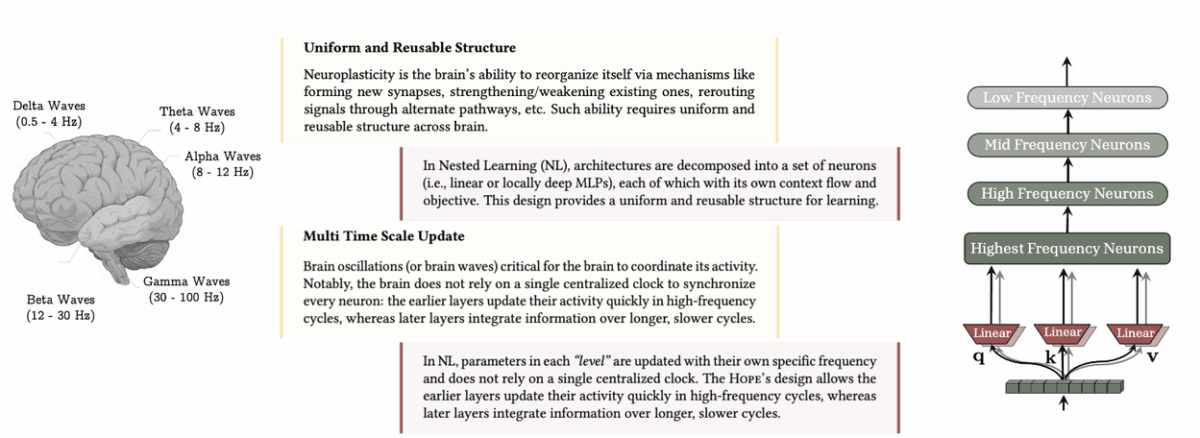

روش Nested Learning که در Google Research طراحی شده، برای رفع این نقص از ساختار و عملکرد مغز انسان الهام گرفته است. گوگل این شیوه را گامی بنیادی در جهت نزدیکتر کردن مدلهای زبانی بزرگ (LLMs) به تواناییهای شناختی انسان و رفع ماهیت فراموشکار آنها دانسته است.

روش Nested Learning تحولی مفهومی در نحوه درک معماری مدلهای هوش مصنوعی و الگوریتمهای بهینهسازی ایجاد میکند. توسعهدهندگان در نگاه سنتی، این دو بخش ساختار مدل و روش آموزش و بهینهسازی آن را مستقل از هم میدیدند، اما در Nested Learning، هر دو به عنوان یک کل واحد و درهمتنیده در نظر گرفته میشوند؛ بهعبارتی مدل و الگوریتم با یکدیگر همزیستی یادگیرنده دارند.

بخوانید: هوشمصنوعی کمدین شد؛ خلق یک ربات با الهام از رابین ویلیامز

در این رویکرد، مدل هوش مصنوعی بهصورت مجموعهای از مسائل کوچکتر و درونهمقرارگرفته تعریف میشود، که هرکدام به طور مستقل و در تعامل با سایر بخشها یاد میگیرند. هر یک از این زیرمسائل یا زیرمدولها با سرعتهای متفاوتی دانش خود را بهروزرسانی میکنند؛ فرایندی که «بهروزرسانیهای چندمقیاسی» (multi-time-scale updates) نام دارد. این همان چیزی است که در مغز انسان نیز رخ میدهد: بخشهای مختلف مغز به تجربههای جدید واکنش نشان میدهند، اما حافظههای قدیمی را پاک نمیکنند. به این ترتیب، Nested Learning باعث میشود که مدل بتواند دانش جدید را بیاموزد بدون آنکه آموختههای گذشته را از بین ببرد و در نتیجه ساختاری پویا و چندلایه برای حفظ و یادگیری تدریجی بهوجود آید.

بیشتر بخوانید: طرح مایکروسافت برای ساخت هوش مصنوعی فوق هوشمند انسان گرا

Google Research برای آزمایش این ایده، مدلی مفهومی با نام Hope طراحی کرده است. Hope یک معماری بازگشتی خودتغییرپذیر است که میتواند حافظه درونی خود را بهینه کند. این مدل از سامانهای موسوم به Continuum Memory Systems استفاده میکند، که حافظه را بهصورت دو بخش مجزا (کوتاهمدت و بلندمدت) نمیبیند، بلکه بهشکل طیفی پیوسته از ماژولهای حافظهای در نظر میگیرد. هرکدام از این ماژولها با بسامد خاص خود بهروزرسانی میشوند و در کنار یکدیگر شبکهای چندلایه از دانش را تشکیل میدهند. این طراحی به مدل امکان میدهد تا حجم گستردهتری از دادهها را در طول زمان بهصورت سازمانیافته، قابلبازیابی و دقیقتر ذخیره کند.

نتایج آزمایشها نشان داده است که Hope در سنجشهای حافظه متنی بلندمدت، مانند چالش معروف «سوزن در انبار کاه» (Needle-In-Haystack) که مستلزم یافتن جزئیات کوچک در میان متنی بزرگ است، عملکردی فراتر از مدلهای پیشرفته موجود داشته است. همچنین در زمینه مدلسازی زبانی عمومی، Hope توانسته است دقت و کارایی بالاتری نسبت به مدلهای کنونی از خود نشان دهد و توانایی درک متون طولانی و حفظ پیوستگی معنایی را بهبود دهد.

بیشتر بخوانید: ایلان ماسک: «سونامی مافوقصوت» هوش مصنوعی شغلهای اداری را از بین می برد

شرکت گوگل میگوید که نتایج این پروژه برای رفع مشکل فراموشی فاجعهبار هوشمصنوعی میتواند در آینده در نسخههای بعدی مدل جمنای گوگل به کار گرفته شود و گامی بزرگ در جهت هوش مصنوعیهایی باشد که همچون مغز انسان قادر به یادگیری مستمر بدون از دست دادن دانش پیشین هستند. با وجود این، گوگل هنوز جدول زمانی مشخصی برای پیادهسازی این فناوری در مدلهای اصلی خود اعلام نکرده است.

این دستاورد جدید میتواند آغازگر دورهای تازه در هوش مصنوعی باشد؛ دورهای که در آن مدلها نهتنها به یاد میآورند بلکه هوشمندانهتر یاد میگیرند، درست همانگونه که مغز انسان در طول زندگی با تجربههای نو سازگار میشود بدون آنکه حافظههای قبلی را از بین ببرد.