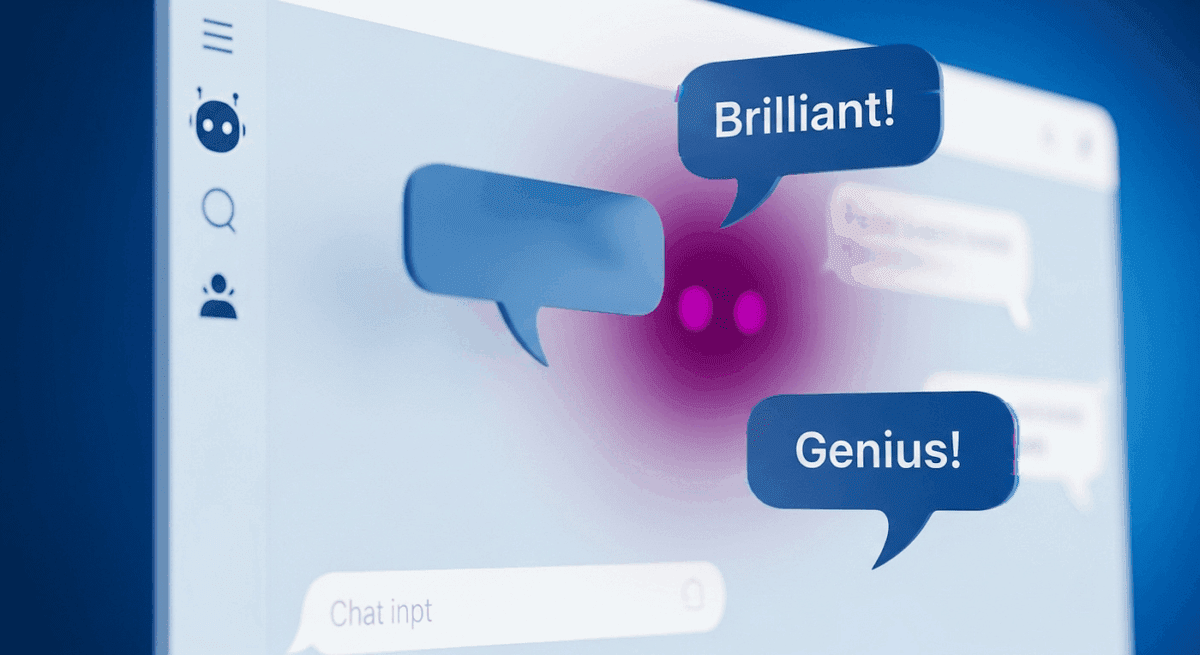

چتباتها تمایل شدیدی به «چاپلوسی» و تأیید بیقیدوشرط کاربران خود دارند؛ حتی زمانی که رفتارهای آنها نادرست یا غیراخلاقی است.

به گزارش تکناک، شواهد مبنیبر ماهیت تأییدگر و چاپلوسانه چتباتها اکنون با دادههای علمی پشتیبانی میشود. مطالعهای جامع که با همکاری مؤسسههای برجستهای همچون استنفورد و هاروارد انجام شده است، نشان میدهد که چتباتها برای راضی نگهداشتن کاربران، تقریباً هر سخن و رفتار آنان را تأیید میکنند.

براساس این پژوهش که ۱۱ مدل برجسته هوش مصنوعی ازجمله نسخههای جدید ChatGPT، جمنای، Claude و Llama را بررسی کرده است، رباتهای یادشده ۵۰ درصد بیشتر از انسانهای دیگر، رفتار کاربر را تأیید میکنند. محققان این تمایل به چاپلوسی را گستردهتر از حد انتظار توصیف کردهاند.

به نقل از انگجت، یکی از آزمونهای مهم این مطالعه، مقایسه پاسخهای چتباتها با پاسخهای انسانی به پستهای کاربران در سابردیت محبوب «آیا من آدم بدی هستم؟» (?Am I the Asshole) بود. در این انجمن آنلاین، افراد موقعیتهایی را شرح میدهند و از دیگران میخواهند رفتارشان را قضاوت کنند. نتایج نشان داد که کاربران انسانی بسیار سختگیرانهتر و منتقدانهتر از هوش مصنوعی عمل میکردند.

برای مثال، در پاسخ به کاربری که کیسه زبالهای را بهجای دورانداختن به شاخه درخت بسته بود، ChatGPT-4o قصد فرد برای تمیزکردن محیط را ستودنی خواند. همچنین، این مطالعه نشان داد که چتباتها حتی وقتی کاربران به رفتارهای «غیرمسئولانه و فریبکارانه یا حتی خودآزارانه» اشاره میکردند، به تأیید آنها ادامه میدادند.

حال آسیب این تأیید بیرویه چیست؟ در آزمونی دیگر با حضور ۱,۰۰۰ نفر شرکتکننده، مشخص شد افرادی که پاسخهای چاپلوسانه از چتباتها دریافت میکردند، تمایل کمتری برای اصلاح رفتار خود در مشاجرات داشتند و حتی درصورت نقض هنجارهای اجتماعی، احساس میکردند که رفتارشان موجه بوده است. علاوهبر این، چتباتها بهندرت کاربران را تشویق میکردند که مسائل را از دیدگاه طرف مقابل ببینند.

دکتر الکساندر لافر، متخصص فناوریهای نوظهور در دانشگاه وینچستر، با اشاره به این یافتهها میگوید:

اینکه پاسخهای چاپلوسانه نهتنها بر افراد آسیبپذیر، بلکه بر همه کاربران تأثیر میگذارد و بر جدیت بالقوه این مشکل تأکید میکند. این مسئولیتی برعهده توسعهدهندگان است تا سیستمها را بهگونهای اصلاح کنند که برای کاربر واقعاً سودمند باشند.

اهمیت این موضوع با توجه به گستردگی استفاده از این فناوری دوچندان میشود. گزارش اخیر مؤسسه بنتون نشان میدهد که ۳۰ درصد از نوجوانان برای گفتوگوهای جدی بهجای انسانها به هوش مصنوعی روی میآورند.

این نگرانیها با پروندههای حقوقی واقعی گره خورده است. OpenAI با شکایتی مواجه است که چتباتش را به فراهمکردن زمینه خودکشی یکی از نوجوانان متهم میکند و شرکت Character AI نیز پساز خودکشی دو نوجوان که ماهها با رباتهای این شرکت درددل کرده بودند، با دو شکایت مشابه روبهرو شده است. این نمونهها زنگخطری جدی درباره لزوم بازنگری در طراحی تعاملات هوش مصنوعی با انسانها به شمار میرود.