پس از بازگشت سم آلتمن به هیئتمدیرهی شرکت OpenAI، گمانهزنیهای بسیاری دربارهی ریشهی اختلافات هیئتمدیره با وی مطرح میشود. بهراستی دلیل اختلاف آنها چه بوده است؟

سم آلتمن، مدیرعامل سابق شرکت OpenAI، پس از هفتهای پرماجرا در سیلیکون ولی شکوهمندانه به شرکت بازگشت. این بازگشت در حالی اتفاق افتاد که اختلافات او با هیئتمدیرهی OpenAI در رسانههای اجتماعی و خبری در کانون توجه قرار گرفته بود. گفته میشود که ریشهی این اختلافات ممکن است به تفاوتهای میان طبیعت سودآور و غیرانتفاعی شرکت مادر OpenAI برگردد.

بااینحال، گزارش جدیدی از نیویورکتایمز نشان میدهد که محور اصلی این اختلافات ممکن است مقالهی تحقیقاتی هلن تونر، عضو هیئتمدیره OpenAI و مدیر مرکز فناوری امنیتی و نوظهور دانشگاه جورجتاون باشد. این اوضاع نشاندهندهی پیچیدگیهای موجود در حوزهی فناوری پیشرفته و تأثیر آن بر روابط مدیریتی و سیاستهای شرکتهای بزرگ است.

مقالهی تونر ممکن است نقش مهمی در اخراج سم آلتمن از OpenAI ایفا کرده باشد. در این مطالعه که اکتبر۲۰۲۳ منتشر شد، تونر رویکردهای ارتباطی بین دولتها و شرکتها را با هدف جلوگیری از سوءتفاهم و برداشتهای اشتباه بررسی کرده است،.

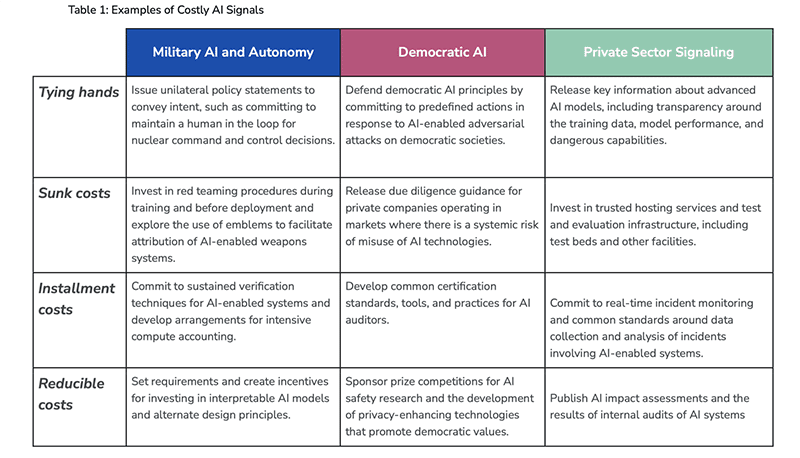

در مقالهی مذکور که با همکاری سایر اعضای دانشگاه جورجتاون نوشته شده است، ابزارهای ارتباطی به نام «نشانهها» معرفی شدهاند. این نشانهها بهعنوان ابزارهایی برای بازیگران در حوزهی امنیت ملی و هوش مصنوعی طراحی شدهاند تا بتوانند بهوضوح نیتها و هدفهای خود را بیان کنند. بااینحال، بهنظر میرسد که مقالهی تونر رویکرد «نشانهگذاری» اتخاذشدهی شرکت OpenAI را ناکافی دانسته است.

انتقادها ممکن است نشاندهندهی تفاوتهای نظریهای یا عملی دربارهی رویکردهای ارتباطی و استراتژیهای استفادهشده در حوزهی فناوری پیشرفته مانند هوش مصنوعی باشد. این موضوع بر اهمیت اتخاذ رویکردهای ارتباطی مؤثر و شفاف در محیطهای پیچیده و چندبعدی نیز تأکید میکند.

ترجمهی جدول بالا در زیر آمده است:

| حوزه | سیگنال | توضیحات |

|---|---|---|

| نظامهای خودمختار نظامی و زمینی | دستبندزدن | انتشار بیانیههای سیاست یکجانبه برای انتقال قصد و نیت مانند تعهد به حفظ انسان در حلقه برای تصمیمگیریهای کنترل و فرماندهی هستهای. |

| نظامهای خودمختار نظامی و زمینی | هزینههای غرقشده | سرمایهگذاری در رویههای تیمسازی قرمز در طول آموزش و قبل از استقرار و بررسی استفاده از نشانهها برای تسهیل انتساب سیستمهای تسلیحاتی خودمختار هوش مصنوعی. |

| نظامهای خودمختار نظامی و زمینی | هزینههای نصب | تعهد به تأیید مداوم شیوههای تأیید برای سیستمهای مبتنیبر هوش مصنوعی و توسعهی ترتیبات برای حسابداری محاسباتی فشرده. |

| دموکراتیک هوش مصنوعی | هزینههای کاهشدادنی | تعیین الزامات و ایجاد انگیزه برای سرمایهگذاری در مدلهای تفسیرشدنی هوش مصنوعی و اصول طراحی جایگزین. |

| دموکراتیک هوش مصنوعی | هزینههای کاهشدادنی | حمایت از مسابقات جایزهمحور برای تحقیقات ایمنی هوش مصنوعی و توسعهی فناوریهای تقویت حریم خصوصی که ارزشهای دموکراتیک را ترویج میکنند. |

| بخش خصوصی سیگنالینگ | رهاسازی اطلاعات مهم | انتشار اطلاعات مهم دربارهی مدلهای هوش مصنوعی پیشرفته، ازجمله شفافیت درزمینهی دادههای آموزشی و عملکرد مدل و قابلیتهای خطرناک. |

| بخش خصوصی سیگنالینگ | انتشار دستورالعملهای تفحص | انتشار دستورالعملهای تفحص برای شرکتهای خصوصی که در بازارهایی فعالیت میکنند و در آن خطر سوءاستفاده از فناوریهای هوش مصنوعی بهطور نظاممند وجود دارد. |

| بخش خصوصی سیگنالینگ | توسعهی استانداردهای مشترک | توسعهی استانداردهای مشترک و ابزارها و شیوهها برای بازرسان هوش مصنوعی. |

در اسناد مربوط به انتشار چتبات GPT-4 شرکت OpenAI، کارت سیستمی گنجانده شده بود که خطرهای مرتبط با GPT-4 و چگونگی کاهش آنها بهدست OpenAI در فرایند تسریع برای انتشار نخستین مدل GPT-4 در بازار را شرح میداد.

نویسندگان مقاله معتقدند که این کارت سیستم بهعنوان ابزاری ارتباطی برای نشاندادن تعهد OpenAI به ایمنی نسبتاً ناکام مانده است. این نظر نشاندهندهی مشکلاتی است که OpenAI در تلاش برای ارائهی توضیحات واضح و مؤثر درزمینهی مسائل ایمنی و اخلاقی مرتبط با محصولات هوش مصنوعی خود با آن مواجه است.

محققان در مقالهی خود رویکرد OpenAI را با رویکرد Anthropic و پلتفرم Claude آن مقایسه کردهاند. آنان تصمیم Anthropic برای بهتعویقانداختن راهاندازی Claude را بهمنظور جلوگیری از پیشرفت سریع قابلیتهای هوش مصنوعی ستودهاند. بهگفتهی آنان، این تصمیم بهعنوان نشانهای هزینهبر از خودداری قلمداد میشود.

دانشمندان در مقالهشان بیان کردند که این رویکرد نشاندهندهی تعهدی عمیقتر به ایمنی و اخلاق در توسعهی هوش مصنوعی است. این تصمیم نهتنها از احتیاط Anthropic در مواجهه با پیشرفتهای فناوری حکایت میکند؛ بلکه بهعنوان الگویی برای سایر شرکتها در حوزهی هوش مصنوعی میتواند عمل کند که میخواهند نشان دهند توجه ویژهای به پیامدهای اخلاقی و ایمنی فناوریهای خود میکنند.

در مقالهی یادشده، محققان تأخیر Anthropic در انتشار Claude را تحلیل و اشاره کردند که با انتظار برای انتشار Claude تا زمانیکه شرکتی دیگر محصول مشابهی عرضه کند، Anthropic نشان داده است که میخواهد از نوع خاصی از شتابزدگی دوری کند که بهنظر میرسد انتشار ChatGPT را تحریک کرده است. شرکت مذکور این هدف را با بهکارگیری هزینههای قسطی محقق ساخته است؛ یعنی هزینههای ثابتی که در طول زمان جبرانشدنی نیستند.

در این تحلیل، Anthropic با عقب نگهداشتن مدل خود از انتشار زودهنگام و پذیرش احتمالی زیانهای درآمدی آتی، اعتبار تعهداتش به ایمنی هوش مصنوعی را افزایش داده است. هدف این اقدام کسب سهم بیشتری از بازار نبوده است؛ بلکه برای ارتقای استانداردهای صنعتی و کمک به شکلگیری انتظارات مشترک درزمینهی توسعه و استقرار مسئولانه هوش مصنوعی بوده است. این رویکرد نشاندهندهی تأکید Anthropic بر اهمیت اخلاق و ایمنی در توسعهی هوش مصنوعی است.

گزارش نیویورکتایمز نشان میدهد که در پی انتشار مقالهی هلن تونر، سم آلتمن، مدیرعامل وقت شرکت OpenAI، از نتایج آن راضی نبود. آلتمن نگرانیهایش دربارهی مقاله را با ارسال ایمیل با کارمندان OpenAI مطرح کرد. بهدنبال این اتفاق، تحولی جالب رخ داد: ایلیا سوتسکور، سرپرست تحقیقات در OpenAI، در ابتدا بررسی اخراج هلن تونر از هیئتمدیره را مطرح کرد. بااینحال، بهناگهان تصمیم گرفت بهجای این کار، علیه آلتمن اقدام کند؛ تصمیمی که ظاهراً پس از گذشت چند روز بهشدت او را پشیمان کرده است.

دیدگاه شما کاربران تکناک دربارهی ریشهی اختلافات سم آلتمن و هیئتمدیرهی شرک OpenAI چیست؟ فکر میکنید چه عاملی سبب شد تا این شرکت یک هفتهی پرهیاهو را پشتسر بگذارد؟

دانش آموخته عمران،عکاس خبری سابق، علاقهمند به کامپیوتر